Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem 5-minütigen No-Code-Lernprogramm werden generative KI in Azure Databricks eingeführt. Sie verwenden den KI-Playground, um Folgendes zu tun:

- Große Sprachmodelle (LLMs) abfragen und Ergebnisse im direkten Vergleich betrachten

- Prototyp eines KI-Agenten, der Werkzeuge aufruft

- Exportieren des Agenten in Code

- Optional: Prototyp eines Fragebeantwortungs-Chatbots unter Verwendung von "Retrieval-Augmented Generation" (RAG)

Bevor Sie anfangen

Stellen Sie sicher, dass Ihr Arbeitsbereich auf Folgendes zugreifen kann:

- Grundlagenmodelle. Siehe Verfügbarkeit von Features des Modells.

- Unity-Katalog. Weitere Informationen finden Sie unter "Erste Schritte mit Unity-Katalog".

- Mosaik AI Agenten-Framework. Weitere Informationen finden Sie unter Features mit eingeschränkter regionaler Verfügbarkeit.

Schritt 1: Abfragen von LLMs mit AI Playground

Verwenden Sie den KI-Playground, um LLMs in einer Chatschnittstelle abzufragen.

- Wählen Sie in Ihrem Arbeitsbereich " Playground" aus.

- Geben Sie eine Frage wie "Was ist RAG?" ein.

Fügen Sie eine neue LLM hinzu, um Antworten nebeneinander zu vergleichen:

- Wählen Sie + oben rechts aus, um ein Modell zum Vergleich hinzuzufügen.

- Wählen Sie im neuen Bereich ein anderes Modell über das Dropdown-Menü aus.

- Aktivieren Sie die Kontrollkästchen " Synchronisieren ", um die Abfragen zu synchronisieren.

- Probieren Sie eine neue Eingabeaufforderung aus, z. B. "Was ist ein zusammengesetztes KI-System?", um die beiden Antworten nebeneinander anzuzeigen.

Testen und vergleichen Sie unterschiedliche LLMs, damit Sie entscheiden können, welches am besten zur Erstellung eines KI-Agenten verwendet werden kann.

Testen und vergleichen Sie unterschiedliche LLMs, damit Sie entscheiden können, welches am besten zur Erstellung eines KI-Agenten verwendet werden kann.

Schritt 2: Prototyp eines Tools, der KI-Agent aufruft

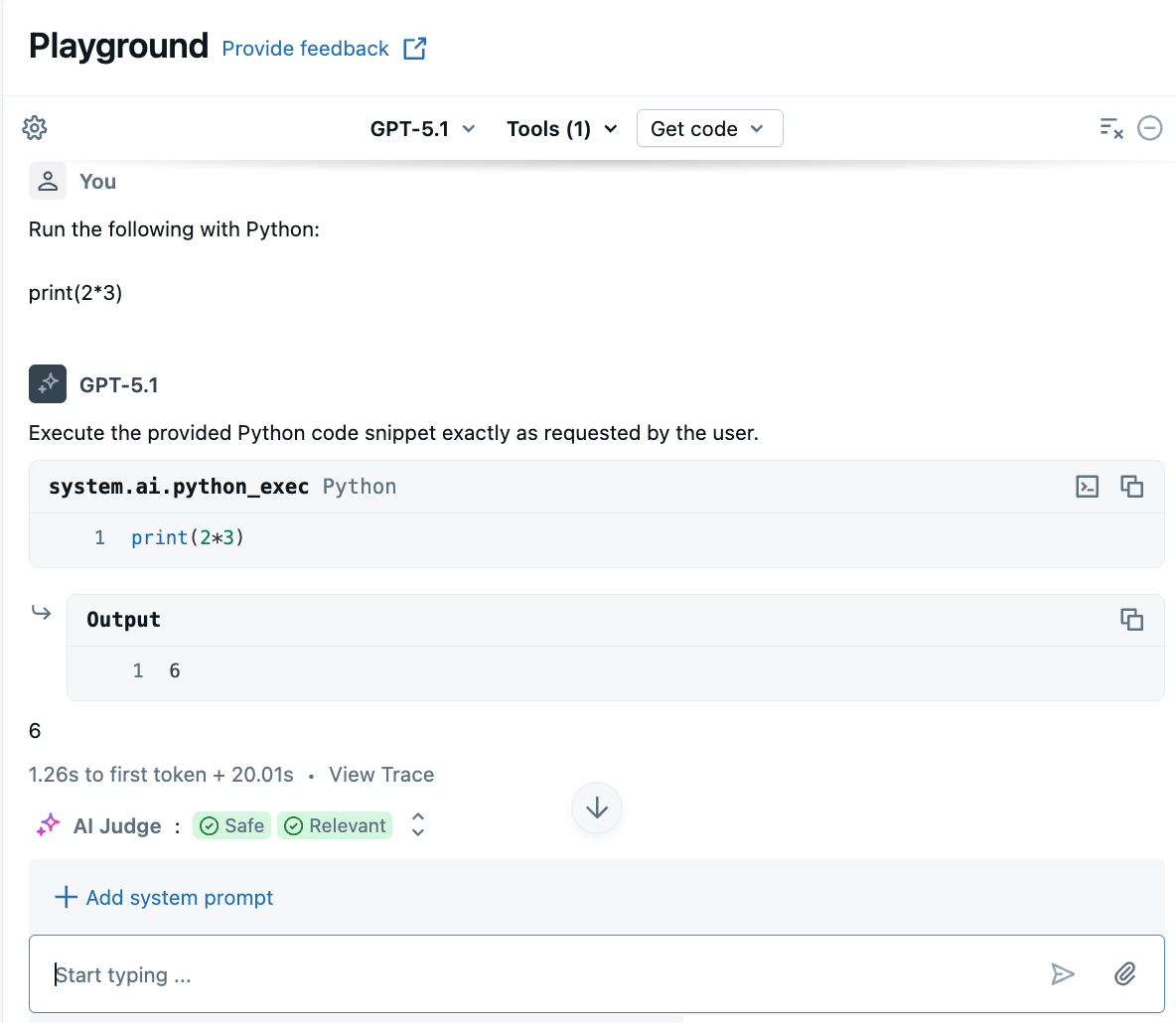

Mit Tools können LLMs mehr tun als Sprache generieren. Tools können externe Daten abfragen, Code ausführen und andere Aktionen ausführen. AI Playground bietet die Möglichkeit, ohne Code Agenten zu prototypisieren, die Werkzeuge aufrufen.

Wählen Sie im Playground ein Modell mit der Bezeichnung Tools aktiviert aus.

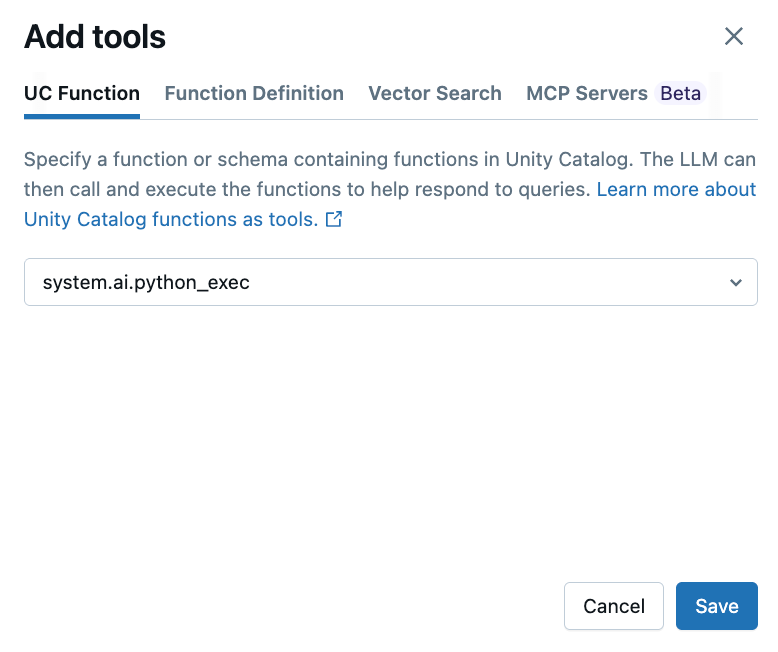

Wählen Sie Tools>+ Tool hinzufügen aus, und wählen Sie die integrierte Unity Catalog-Funktion aus.

system.ai.python_execMit dieser Funktion kann Ihr Agent beliebigen Python-Code ausführen.

Stellen Sie eine Frage, die das Generieren oder Ausführen von Python-Code umfasst. Sie können verschiedene Variationen Ihrer Eingabeformulierung ausprobieren. Wenn Sie mehrere Tools hinzufügen, wählt das LLM das entsprechende Tool aus, um eine Antwort zu generieren.

Schritt 3: Exportieren Ihres Agents in Code

Klicken Sie nach dem Testen Ihres Agents im KI-Playground auf "Code>erstellen", um Ihren Agent in ein Python-Notizbuch zu exportieren.

Das Python-Notizbuch enthält Code, der den Agenten definiert und ihn zu einem Bereitstellungsendpunkt für Modelle bereitstellt.

Optional: Prototyp eines RAG-Fragebeantwortungs-Bots

Wenn Sie einen Vektorsuchindex in Ihrem Arbeitsbereich eingerichtet haben, können Sie einen Prototyp für einen Fragebeantwortungs-Bot erstellen. Dieser Agenttyp verwendet Dokumente in einem Vektorsuchindex, um Fragen basierend auf diesen Dokumenten zu beantworten.

Klicken Sie auf Extras>+ Tool hinzufügen. Wählen Sie dann Ihren Vektorsuchindex aus.

Stellen Sie eine Frage im Zusammenhang mit Ihren Dokumenten. Der Agent kann den Vektorindex verwenden, um relevante Informationen nachzuschlagen und alle dokumente zu zitieren, die in seiner Antwort verwendet werden.

Informationen zum Einrichten eines Vektorsuchindex finden Sie unter Erstellen eines Vektorsuchindex

Nächste Schritte

Verwenden Sie Agent Framework, um erweiterte Agents programmgesteuert zu entwickeln. Siehe Erstellen von KI-Agents im Code.

Erfahren Sie, wie Sie eine RAG-Anwendung erstellen. Siehe RAG-Leitfaden.