Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Lernprogramm erstellen Sie eine Pipeline, um OData aus einer Northwind-Quelle zu einem Lakehouse-Ziel zu verschieben und eine E-Mail-Benachrichtigung zu senden, wenn die Pipeline abgeschlossen ist.

Voraussetzungen

Um zu beginnen, müssen die folgenden Voraussetzungen erfüllt sein:

- Stellen Sie sicher, dass Sie über einen für Microsoft Fabric aktivierten Arbeitsbereich verfügen, der nicht der Standardarbeitsbereich „Eigener Arbeitsbereich“ ist.

Erstellen eines Lakehouse

Zunächst müssen Sie ein Lakehouse erstellen. Ein Lakehouse ist ein Data Lake, der für Analysen optimiert ist. In diesem Tutorial erstellen Sie ein Lakehouse, das als Ziel für den Dataflow verwendet wird.

Navigieren Sie zu Ihrem für Fabric aktivierten Arbeitsbereich.

Wählen Sie im Menü „Erstellen“ die Option Lakehouse aus.

Geben Sie einen Namen für das Lakehouse ein.

Wählen Sie Erstellen aus.

Jetzt haben Sie ein Lakehouse erstellt und können nun den Dataflow einrichten.

Erstellen eines Dataflows

Ein Dataflow ist eine wiederverwendbare Datentransformation, die in einer Pipeline verwendet werden kann. In diesem Tutorial erstellen Sie einen Dataflow, der Daten aus einer OData-Quelle abruft und die Daten in ein Lakehouse-Ziel schreibt.

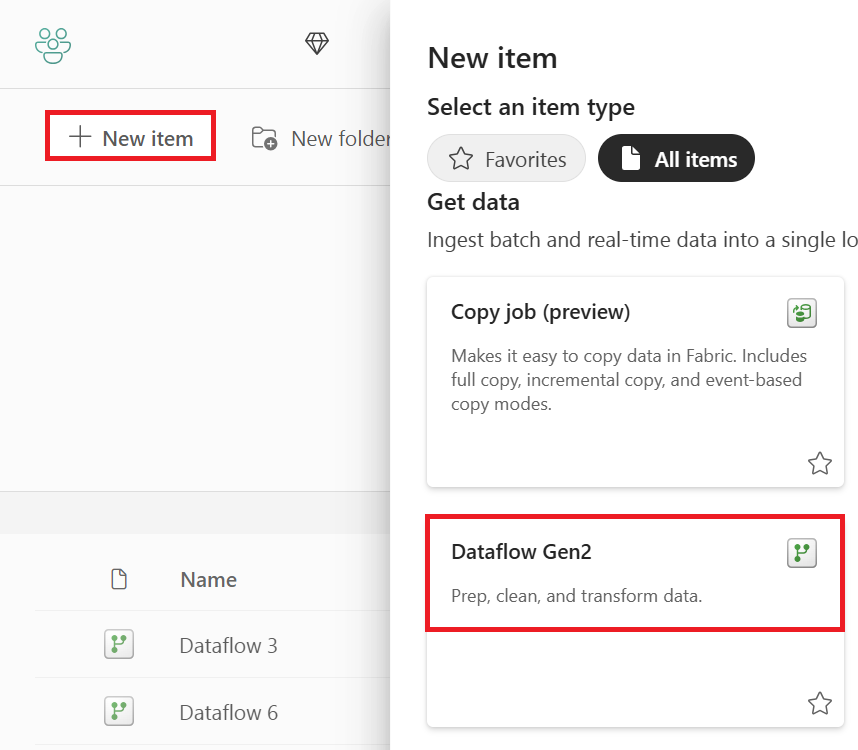

Navigieren Sie zu Ihrem für Fabric aktivierten Arbeitsbereich.

Wählen Sie im Menü „Erstellen“ die Option Dataflow Gen2 aus.

Erfassen Sie die Daten aus der OData-Quelle.

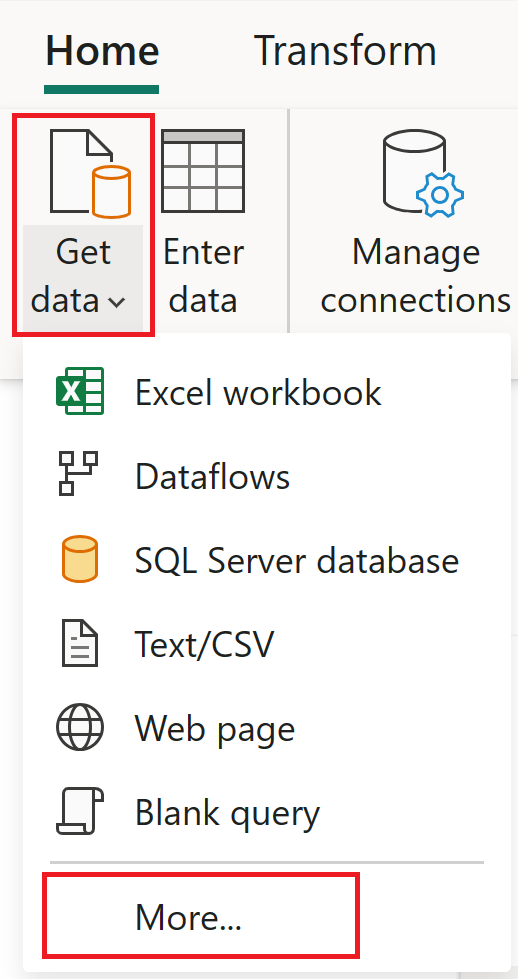

Wählen Sie Daten abrufen und dann Weitere aus.

Suchen Sie in Datenquelle auswählen nach OData, und wählen Sie dann den OData-Connector aus.

Geben Sie die URL der OData-Quelle ein. Verwenden Sie für dieses Tutorial den OData-Beispieldienst.

Wählen Sie Weiter aus.

Wählen Sie die Entität aus, die Sie erfassen möchten. Verwenden Sie in diesem Tutorial die Entität Orders.

Wählen Sie Erstellen aus.

Nachdem Sie die Daten aus der OData-Quelle erfasst haben, können Sie das Lakehouse-Ziel einrichten.

So erfassen Sie die Daten im Lakehouse-Ziel:

Wählen Sie Datenziel hinzufügen aus.

Wählen Sie Lakehouse aus.

Konfigurieren Sie die Verbindung, die Sie zum Herstellen einer Verbindung mit dem Lakehouse verwenden möchten. Die Standardeinstellungen sind in Ordnung.

Wählen Sie Weiter aus.

Navigieren Sie zu dem Arbeitsbereich, in dem Sie das Lakehouse erstellt haben.

Wählen Sie das Lakehouse aus, das Sie im vorherigen Schritt erstellt haben.

Bestätigen Sie den Tabellennamen.

Wählen Sie Weiter aus.

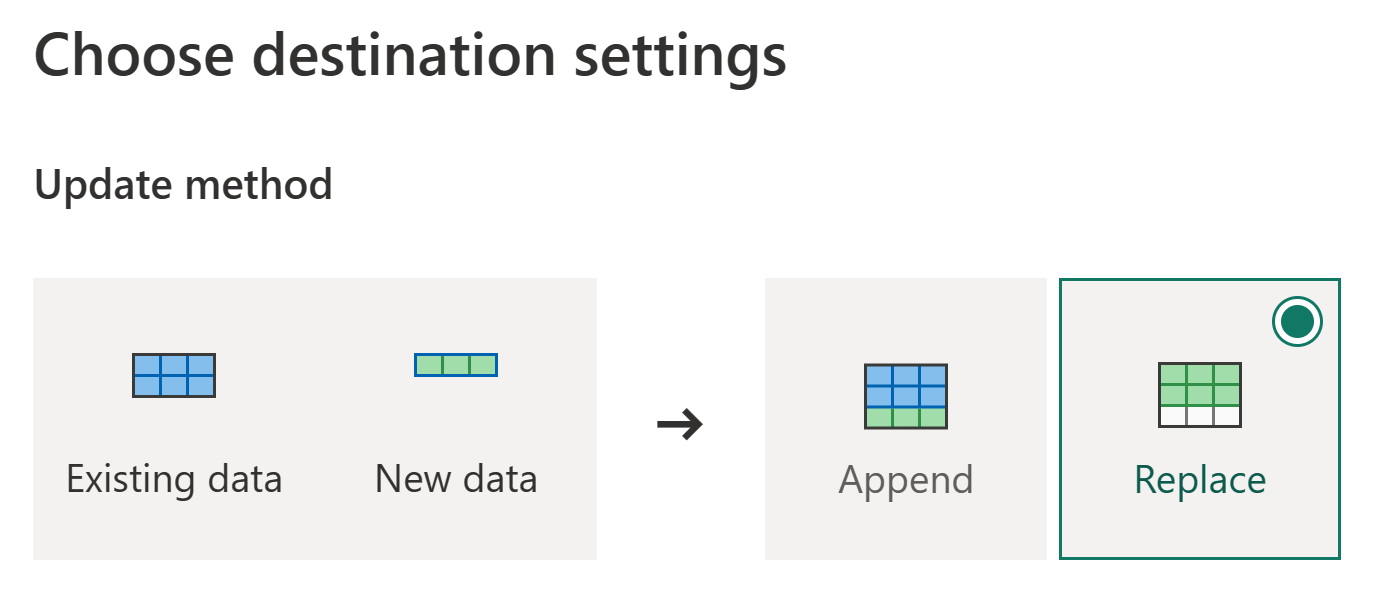

Bestätigen Sie die Aktualisierungsmethode, und wählen Sie Einstellungen speichern aus.

Veröffentlichen Sie den Dataflow.

Wichtig

Bei der ersten Dataflow Gen2-Erstellung in einem Arbeitsbereich werden Lakehouse- und Warehouse-Elemente zusammen mit den zugehörigen SQL-Analyseendpunkten und semantischen Modellen bereitgestellt. Diese Elemente werden von allen Dataflows im Arbeitsbereich gemeinsam verwendet und sind für Dataflow Gen2 erforderlich. Sie sollten nicht gelöscht und nicht direkt von Benutzern verwendet werden. Die Elemente sind ein Implementierungsdetail von Dataflow Gen2. Die Elemente sind im Arbeitsbereich nicht sichtbar, können aber in anderen Oberflächen wie Notebook, SQL-Endpunkt, Lakehouse- und Warehouse-Erfahrungen zugänglich sein. Sie können die Elemente anhand ihres Präfixes im Namen erkennen. Das Präfix der Elemente lautet „DataflowsStaging“.

Jetzt, da Sie die Daten in das Lakehouse-Ziel aufgenommen haben, können Sie Ihre Pipeline einrichten.

Erstellen einer Pipeline

Eine Pipeline ist ein Workflow, der zum Automatisieren der Datenverarbeitung verwendet werden kann. In diesem Tutorial erstellen Sie eine Pipeline, die die Dataflow Gen2 ausführt, die Sie im vorherigen Schritt erstellt haben.

Navigieren Sie zurück zur Arbeitsbereichsübersichtsseite, und wählen Sie "Pipelines " im Menü "Erstellen" aus.

Geben Sie einen Namen für die Pipeline an.

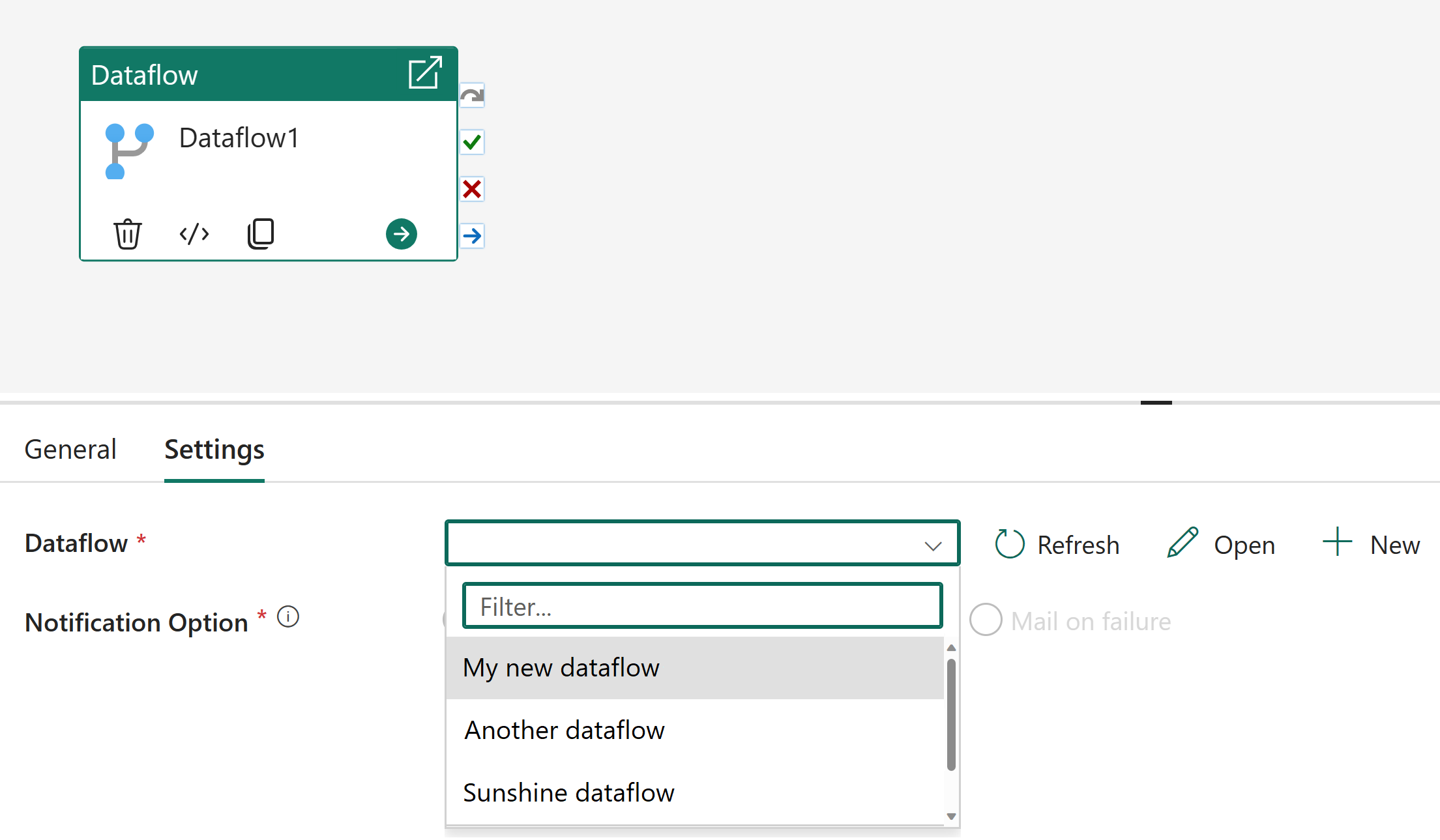

Wählen Sie die Dataflow-Aktivität aus.

Wählen Sie den Dataflow aus, den Sie im vorherigen Verfahren in der Dropdownliste Dataflow unter Einstellungen erstellt haben.

Fügen Sie eine Office 365 Outlook-Aktivität hinzu.

Konfigurieren Sie die Office 365 Outlook-Aktivität zum Senden von E-Mail-Benachrichtigungen.

Ausführen und Planen der Pipeline

In diesem Abschnitt führen Sie die Pipeline aus und planen sie. Mit diesem Zeitplan können Sie die Pipeline auf Zeitplan ausführen.

Wechseln Sie zu Ihrem Arbeitsbereich.

Öffnen Sie das Dropdownmenü der Pipeline, die Sie im vorherigen Verfahren erstellt haben, und wählen Sie dann "Zeitplan" aus.

Wählen Sie unter Geplante Ausführung die Option Ein aus.

Geben Sie den Zeitplan an, den Sie zum Ausführen der Pipeline verwenden möchten.

- Wiederholen Sie die Ausführung z. B. jeden Tag oder jede Minute.

- Wenn Sie „Täglich“ ausgewählt haben, können Sie auch die Uhrzeit auswählen.

- Starten Sie die Option Ein an einem bestimmten Datum.

- Beenden Sie die Option Ein an einem bestimmten Datum.

- Wählen Sie die Zeitzone aus.

Wählen Sie Übernehmen aus, um die Änderungen zu übernehmen.

Sie haben nun eine Pipeline erstellt, die in einem Zeitplan ausgeführt wird, die Daten im Seehaus aktualisiert und Ihnen eine E-Mail-Benachrichtigung sendet. Sie können den Status der Pipeline überprüfen, indem Sie zum Monitor Hub wechseln. Sie können auch den Status der Pipeline überprüfen, indem Sie zu Pipeline wechseln und im Dropdownmenü die Registerkarte " Verlauf ausführen " auswählen.

Zugehöriger Inhalt

In diesem Beispiel wird gezeigt, wie Sie einen Dataflow in einer Pipeline mit Data Factory in Microsoft Fabric verwenden. Sie haben Folgendes gelernt:

- Erstellen Sie einen Dataflow.

- Erstellen Sie eine Pipeline, die Ihren Dataflow aufruft.

- Führen Sie Ihre Pipeline aus, und planen Sie sie.

Erfahren Sie im nächsten Schritt mehr über die Überwachung Ihrer Pipelineausführungen.