Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel wird beschrieben, wie Sie Funktionen verwenden, die speziell für den Schutz von KI-Apps und der Daten gelten, mit denen diese interagieren.

- Schützen Sie Ihre vertraulichen Daten bei Benutzeraufforderungen und KI-generierten Daten

- Verteidigen Sie sich gegen neue Bedrohungen wie Prompt-Injektionen

Dies ist der dritte Artikel in einer Reihe. Wenn Sie noch nicht die Aufgaben in "Vorbereiten auf KI-Sicherheit " und "KI-Apps und -Daten entdecken" ausgeführt haben, beginnen Sie mit diesen Artikeln, um Ihre Umgebung mit den in diesem Artikel vorgeschriebenen Funktionen vorzubereiten.

Verwenden Sie diesen Artikel zusammen mit dieser Ressource:

- Cloud Adoption Framework (CAF) für KI – Prozess zum Sichern von KI

Microsoft bietet eine breite Palette von Funktionen zum Schutz von KI-Apps und -Daten. In diesem Artikel werden diese in zwei Kategorien erläutert: Datenschutz und Bedrohungsschutz.

In den folgenden beiden Tabellen werden die Abbildung beschrieben und die Schritte zur Implementierung dieser Funktionen erläutert.

Tabelle 1: Datenschutzfunktionen

| Schritt | Aufgabe | Umfang |

|---|---|---|

| 1 | Wenden Sie SharePoint-Steuerungen für übermäßiges Teilen an, um vertrauliche Websites und Daten schnell von der Reichweite der KI-Apps auszunehmen. | Websites und Dateien in Ihrer Microsoft 365-Umgebung. |

| 2 | Nutzen Sie Data Security Posture Management (DSPM) für KI, um zu erfahren, wo Oversharing stattfindet und um Lücken in der Abdeckung Ihrer Richtlinien, Etiketten, Bezeichnungen, etikettieren zu finden. | Copiloten, Agents und andere KI-Apps, die große Sprachmodule (LLMs) von Drittanbietern verwenden, einschließlich der unterstützten KI-Websites. KI-Apps in anderen Cloudanbietern über das Purview SDK. |

| 3 | Machen Sie weiterhin Fortschritte bei Vertraulichkeitsbezeichnungen und DLP-Richtlinien (Data Loss Prevention). | Websites, Dateien und Geräte in Ihrer Microsoft 365-Umgebung. SaaS-Apps, wenn sie in Defender für Cloud-Apps integriert sind. KI-Apps in Azure und anderen Cloudanbietern über das Purview SDK. |

| 4 | Wenden Sie innerhalb des Insider-Risikomanagements (IRM) die Vorlage riskante KI an, um riskantes Verhalten in KI-Apps zu identifizieren. | Generative Künstliche Intelligenz-Webseiten. Microsoft 365 Copilot, Microsoft Copilot, Copilot Studio, Azure AI-Dienste. KI-Apps in anderen Cloudanbietern über das Purview SDK. |

| 5 | Konfigurieren von adaptivem Schutz für Insider-Risikomanagement, um den Schutz für Daten basierend auf dem Risiko von Benutzern zu erhöhen | Websites, Dateien und Geräte in Ihrer Microsoft 365-Umgebung. |

Tabelle 2– Bedrohungsschutzfunktionen

| Schritt | Aufgabe | Umfang |

|---|---|---|

| 1 | Verwenden Sie Defender für Cloud-Apps, um Sie zu benachrichtigen, wenn neue KI-Apps verwendet werden, um Risikobewertungen für KI-Apps zu berechnen und diese Apps in Ihrer Umgebung zuzulassen oder zu blockieren. Defender für Cloud-Apps bietet zusätzlichen Schutz für Microsoft 365 Copilot. | SaaS KI-Anwendungen |

| 2 | Defender für Cloud Entdecken Sie bereitgestellte KI-Workloads in Ihrer Umgebung und gewinnen Sie Sicherheitseinblicke mit Microsoft Defender für Cloud |

Maßgeschneiderte Azure AI-basierte KI-Anwendungen |

Schützen von KI-Daten

Diese Funktionen helfen Ihnen dabei, die wichtigsten Risiken im Zusammenhang mit Datenüberteilung, vertraulicher Datennutzung und riskantem Verhalten von Benutzern effizient zu erlernen und zu mindern. Diese Fähigkeiten beschränken sich auf Schutzmaßnahmen für KI-Apps und -Daten in Ihrer Umgebung.

Schritt 1 - Anwenden der SharePoint Oversharing-Kontrollen

SharePoint-Oversharing-Kontrollen umfassen Steuerelemente, die in SharePoint integriert sind, wie spezifizierte Berechtigungen, und Add-On-Funktionen in SharePoint Advanced Management, um die Inhaltsgovernance für den Microsoft Copilot-Bereitstellungsprozess zu stärken. SharePoint Oversharing-Kontrollen helfen Ihnen:

- Beschränken Sie die Copilot-Suche vorübergehend auf eine Liste von Websites, die Sie angeben (Eingeschränkte SharePoint-Suche).

- Schnelles Auffinden von Webseiten, die potenziell übermäßig freigegebene Daten oder vertrauliche Inhalte enthalten (Berichte zur Datenzugriffsverwaltung).

- Kennzeichnen Sie Websites, sodass Benutzer sie nicht über Copilot oder organisationsweite Suche (Eingeschränkte Inhalte entdecken in der erweiterten Verwaltung von SharePoint) finden können.

- Erstellen sie inaktive Websiterichtlinien, um inaktive Websites automatisch zu verwalten und zu reduzieren (erweiterte SharePoint-Verwaltung).

- Einschränken des Zugriffs auf SharePoint- und OneDrive-Websites auf Benutzer in einer bestimmten Gruppe (eingeschränkte Zugriffssteuerungsrichtlinien in der erweiterten SharePoint-Verwaltung).

Verwenden Sie die folgenden Ressourcen, um mit der Überteilung von Steuerelementen zu beginnen.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Prüfen Sie die Illustration und Beschreibung der Oversharing-Kontrollen, die Sie mit Microsoft 365 Copilot verwenden können | Microsoft 365 Copilot Datenschutz- und Überwachungsarchitektur |

| Herunterladbarer Entwurf zur Verhinderung der übermäßigen Weitergabe | Microsoft 365 Copilot Blaupause für Oversharing |

| Weitere Informationen zur erweiterten Verwaltung von SharePoint | Microsoft SharePoint Premium - Übersicht über SharePoint Advanced Management |

Schritt 2– Schützen von Daten durch DSPM für KI

Verwenden Sie DSPM für KI, um zu lernen, wo Oversharing stattfindet, und um Lücken in Ihrer Richtlinienabdeckung für Empfindlichkeitskennzeichnungen und DLP-Richtlinien zu finden.

Ein guter Startpunkt ist der Bericht Bewertung für die Woche.

Sie können in einzelne Berichte einsteigen, um weitere Informationen darüber zu erhalten, wo Sie Lücken in den Oversharing-Kontrollen, Etiketten, Bezeichnungen und DLP-Richtlinien haben, so dass Sie diese Probleme schnell beheben können.

Für jeden Bericht bietet DSPM für KI Empfehlungen zur Verbesserung Ihrer Datensicherheit. Verwenden Sie den Link " Alle Empfehlungen anzeigen " oder "Empfehlungen " im Navigationsbereich, um alle verfügbaren Empfehlungen für Ihren Mandanten und deren Status anzuzeigen.

Verwenden Sie die folgenden Ressourcen, um KI-Apps und -Daten mit DSPM für KI zu schützen.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Erfahren Sie mehr über DSPM für KI | So verwenden Sie DSPM für KI |

| Erfahren Sie mehr über die Voraussetzungen und die Funktionsweise von One-Click-Richtlinien und Standardrichtlinien | Überlegungen für DSPM für KI |

| Für KI-Apps in anderen Cloudanbietern erfahren Sie, wie Sie die Integration mit DSPM für KI mithilfe des Purview SDK testen. | So testen Sie eine KI-Anwendung, die in das Purview SDK integriert ist |

Schritt 3: Weiterhin Lücken in Vertraulichkeitsbezeichnungen und DLP-Richtlinien identifizieren

Bei der Vorbereitung auf KI-Sicherheit haben Sie Microsoft Purview-Tools für die Verwaltung von Datensicherheitsstatus, DSPM und DSPM für KI verwendet, um den Schutz ihrer vertraulichen Daten zu priorisieren. Überprüfen Sie diese Tools weiterhin, um Lücken in Ihrer Richtlinienabdeckung zu identifizieren und zu ermitteln, wo Sie weiterhin in das Anwenden von Vertraulichkeitsbezeichnungen und DLP-Richtlinien investieren müssen. Erweitern Sie außerdem Vertraulichkeitsbezeichnungen und DLP-Richtlinien auf SaaS-Apps, indem Sie Defender für Cloud-Apps verwenden.

Verwenden Sie die folgenden Ressourcen, um mit Microsoft Purview Fortschritte zu machen.

Schritt 4– Anwenden der Vorlage "Risky AI" in Insider Risk Management (IRM)

Microsoft Purview Insider Risk Management (IRM) enthält vordefinierte Richtlinienvorlagen, die Sie auf Ihre Umgebung anwenden können, einschließlich riskanter KI-Nutzung. IRM-Vorlagen sind vordefinierte Richtlinienbedingungen, die die Arten von Risikoindikatoren und das von der Richtlinie verwendete Risikobewertungsmodell definieren.

Die Riskante KI-Nutzungsrichtlinie kann dabei helfen, Risikobewertungen für Aufforderungen und Antworten in allen KI-Tools in Ihrer Organisation zu erkennen und zu aktivieren. IRM hilft Ihnen, Risikoaktivitäten im Zusammenhang mit KI zu untersuchen und Maßnahmen zu ergreifen.

Verwenden Sie die folgenden Ressourcen, um mit dem Insider-Risikomanagement zu beginnen und die Vorlage für riskante KI-Nutzungsrichtlinien anzuwenden.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Erste Schritte mit dem Insider-Risikomanagement und Informationen zu den wichtigsten Szenarien, die Ihrer Organisation zugute kommen | Informationen zum Insider-Risikomanagement |

| Anwenden der Risky AI-Vorlage | Informationen zu Richtlinienvorlagen für Insider-Risikomanagement | Microsoft Learn |

| Informationen zu wichtigen Szenarien für KI und Beispielberichte ansehen | Insider-Risikomanagement, das risikobehaftete Sichtbarkeit der KI-Nutzung und Sicherheitsuntersuchungen ermöglicht |

| Testen Sie für KI-Apps, die mit dem Purview SDK entwickelt wurden, die Integration des Insider-Risikomanagements. | So testen Sie eine KI-Anwendung, die in das Purview SDK integriert ist |

Schritt 5: Konfigurieren des adaptiven Schutzes für das Insider-Risikomanagement

Adaptiver Schutz in Microsoft Purview Insider Risk Management weist Benutzern dynamisch eine Risikostufe zu und wendet dann Richtlinien an, die Sie für Benutzer mit moderatem oder erhöhtem Risiko erstellen. Richtlinien können erhöhte Maßnahmen zur Verhinderung von Datenverlust implementieren, gelöschte Inhalte beibehalten oder höhere Anforderungen für bedingten Zugriff erzwingen.

Verwenden Sie die folgenden Ressourcen, um mit adaptivem Schutz zu beginnen.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Erste Schritte mit dem Insider-Risikomanagement und Informationen zu den wichtigsten Szenarien, die Ihrer Organisation zugute kommen | Informationen zum Insider-Risikomanagement |

| Informationen zu wichtigen Szenarien für KI und Beispielberichte ansehen | Insider-Risikomanagement, das risikobehaftete Sichtbarkeit der KI-Nutzung und Sicherheitsuntersuchungen ermöglicht |

| Anwenden der Risky AI-Vorlage | Informationen zu Richtlinienvorlagen für Insider-Risikomanagement |

| Untersuchen und Reagieren auf Insider-Risikoaktivitäten |

Untersuchen von Insider-Risikomanagementaktivitäten Ergreifen von Maßnahmen für Insider-Risikomanagementfälle |

Optimale Nutzung des Bedrohungsschutzes für KI

Defender für Cloud-Apps und Defender für Cloud umfassen Funktionen, mit denen Sie über die Verwendung neuer KI-Apps informiert bleiben und geeignete Steuerelemente anwenden können.

Schritt 1: Verwenden von Defender für Cloud-Apps zum Triagen und Schützen der Verwendung von KI-Apps

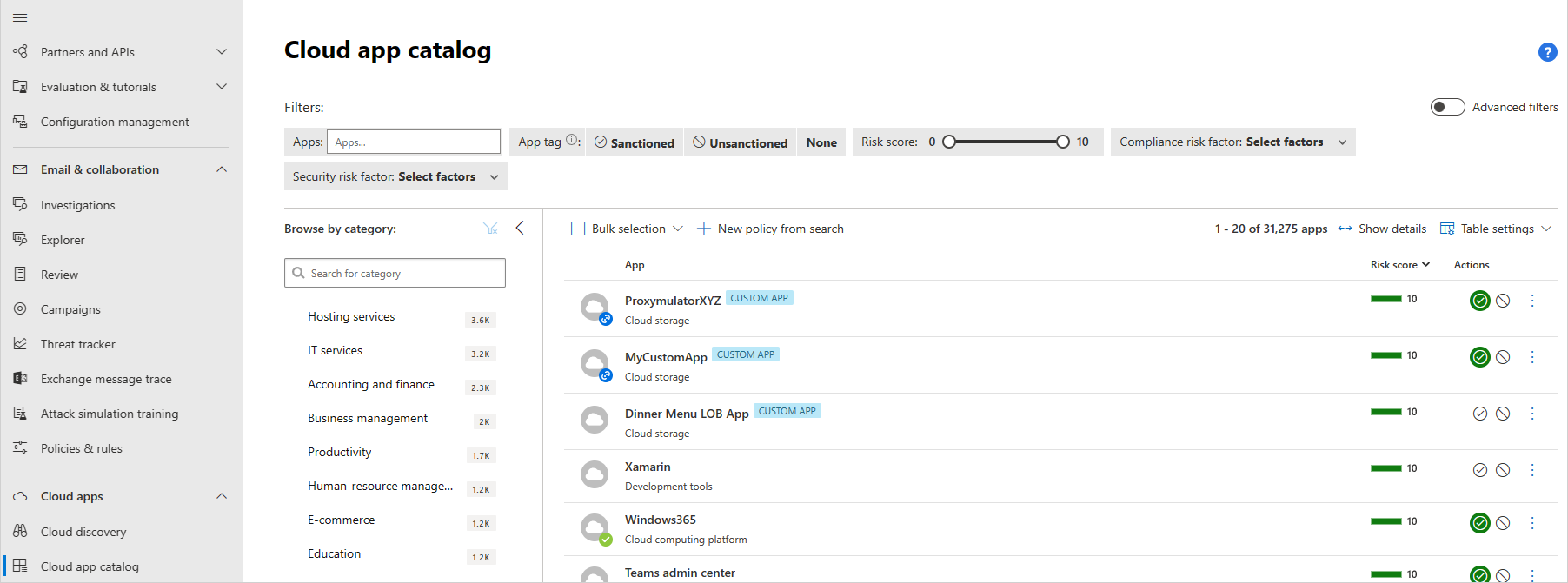

Der vorherige Artikel dieser Reihe, Entdecken von KI-Apps und Daten, konzentriert sich auf die Verwendung von Defender for Cloud Apps, um KI-Apps in Ihrer Umgebung zu entdecken. Dieser Artikel empfiehlt Organisationen, Defender für Cloud-Apps zu verwenden, um den Überblick über die verwendung neuer KI-Apps zu behalten, indem sie das Risiko bewerten, das diese Risiken für Ihre Umgebung darstellt, diese Apps sanktionieren oder blockieren und Sitzungssteuerelemente auf Apps anwenden.

Erstellen Sie zunächst eine Richtlinie, um automatisch eine Warnung auszulösen, wenn eine neue generative KI-App in Ihrer Organisation verwendet wird.

Bewerten Sie als Nächstes die Risikobewertung für neu ermittelte Apps. Sie können auch die Risikobewertung anpassen. Beispielsweise können stark regulierte Organisationen die Gewichtung bestimmter Attribute der Risikobewertung ändern. Sie können auch eine Risikobewertung außer Kraft setzen.

Entscheiden Sie, ob jede App sanktioniert oder blockiert werden soll. Organisationen können die Verwendung von Apps aus verschiedenen Gründen blockieren. Einige sind besorgt darüber, dass vertrauliche Daten unwissentlich mit Anwendungen geteilt und später für eine Zielgruppe außerhalb der Organisation verfügbar gemacht werden. Dies könnte dazu führen, dass die Organisation die Verwendung aller nicht verwalteten KI-Apps blockiert. Während andere Organisationen sicherstellen müssen, dass alle verwendeten Apps gemäß unterschiedlichen Standards, z. B. SOC2 oder HIPAA, konform sind.

Entscheiden Sie abschließend für Apps, die Sie sanktionieren, ob Sie Sitzungsrichtlinien für eine bessere Kontrolle und Sichtbarkeit anwenden möchten. Mit Sitzungsrichtlinien können Sie Parameter für die Nutzung von Cloud-Apps in Ihrer Organisation festlegen. Sie können beispielsweise eine Sitzungsrichtlinie konfigurieren, mit der nur verwaltete Geräte auf eine KI-App zugreifen können. Ein einfacheres Beispiel wäre die Konfiguration einer Richtlinie zur Überwachung des Datenverkehrs von nicht verwalteten Geräten, sodass Sie das Risiko dieses Datenverkehrs analysieren können, bevor Sie strengere Richtlinien anwenden.

In dieser Abbildung:

- Der Zugriff auf sanktionierte Cloud-Apps von Benutzern und Geräten in Ihrer Organisation wird über Defender for Cloud Apps geroutet, wo Richtlinien, Richtlinien für Sitzungen auf bestimmte Apps angewendet werden können.

- Cloud-Apps, die Sie nicht sanktioniert oder explizit nicht genehmigt haben, sind nicht betroffen.

Defender für Cloud-Apps bietet zusätzlich dedizierte Erkennungen für Microsoft 365 Copilot. Sicherheitsteams können verdächtige Interaktionen eines Benutzers mit Copilot erkennen und reagieren und die Bedrohung mindern. Wenn beispielsweise ein Benutzer über Copilot über eine riskante IP-Adresse auf vertrauliche Daten zugreift, löst Defender für Cloud Apps eine Warnung aus, um diese verdächtige Aktivität mit wichtigen Details zu kennzeichnen, einschließlich der MITRE-Angriffstechnik, der IP-Adresse und anderer Felder, mit denen Sicherheitsteams diese Warnung weiter untersuchen können.

Verwenden Sie die folgenden Ressourcen als nächste Schritte.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Überprüfen Sie die Schritte 5-8 in diesem Bereitstellungsablauf von Defender for Cloud Apps. | Entdecken und verwalten Sie Cloud Apps |

| Lesen Sie dieses Video-Lernprogramm zum Verwalten von Apps | Entdecken Sie, welche generativen KI-Apps in Ihrer Umgebung mit Defender für Cloud-Apps verwendet werden – YouTube |

| Erstellen einer App-Ermittlungsrichtlinie | Erstellen Sie Richtlinien für die Cloud-Erkennung |

| Bewertung des Risikowerts für neu entdeckte Apps | Cloud-App-Katalog und Risikobewertungen |

| Sanktionieren oder Blockieren neuer Apps | Gouverneur hat Apps entdeckt |

| Anwenden von Sitzungsrichtlinien auf KI-Apps zur besseren Kontrolle und Sichtbarkeit | Richtlinien für Sitzungen erstellen |

| Erfahren Sie, wie Sie bedrohungsschutz für Microsoft 365 Copilot verwenden. | Neue Bedrohungserkennungen für Microsoft Copilot für Microsoft 365 |

Schritt 2: Anwenden von KI-Schutzfunktionen in Defender for Cloud

Der vorherige Artikel in dieser Reihe, Entdecken Sie KI-Apps und -Daten, konzentrierte sich auf die Entdeckung von generativen KI-Workloads und -Modellen, die in Ihrer Umgebung ausgeführt werden. Dieser Artikel konzentriert sich auf den Schutz von GenAI-Anwendungen während des gesamten Anwendungslebenszyklus, während Sie Ihre benutzerdefinierten KI-Apps erstellen und verwenden.

Organisationen entscheiden sich dafür, neue GenAI-Anwendungen zu entwickeln und KI in bestehende Anwendungen einzubetten, um die Geschäftseffizienz und Produktivität zu steigern. Angreifer suchen zunehmend, Anwendungen auszunutzen, um den entworfenen Zweck des KI-Modells mit neuen Angriffen wie Eingabeaufforderungen, Brieftaschenangriffen, Modelldiebstahl und Datenvergiftungen zu verändern und gleichzeitig bekannte Risiken wie Datenschutzverletzungen und Denial-of-Service zu erhöhen. Sicherheitsteams müssen vorbereitet sein und sicherstellen, dass sie über die richtigen Sicherheitskontrollen für ihre KI-Anwendungen und Erkennungen verfügen, die sich auf die neue Bedrohungslandschaft beziehen.

Microsoft Defender für Cloud hilft Organisationen bei der Sicherung ihrer Hybrid- und Multicloud-Umgebungen von Code zu Cloud. Defender für Cloud umfasst Sicherheitsstatus- und Bedrohungsschutzfunktionen, mit denen Organisationen ihre unternehmensbasierten GenAI-Anwendungen während des gesamten Anwendungslebenszyklus schützen können:

- Entdecken Sie kontinuierlich GenAI-Anwendungskomponenten und KI-Artefakte von Code zu Cloud.

- Erkunden und beheben Sie Risiken für GenAI-Anwendungen mit integrierten Empfehlungen zur Stärkung des Sicherheitsstatus.

- Identifizieren und beheben Sie toxische Kombinationen in GenAI-Anwendungen mithilfe der Angriffspfadanalyse.

- Erkennen Sie GenAI Anwendungen, die von Azure KI Inhalt Safety Prompt Shields, Microsoft Threat Intelligence Signalen und kontextbezogener Aktivitätsüberwachung unterstützt werden.

- Suchen und Untersuchen von Angriffen in GenAI-Apps mit integrierter Integration in Microsoft Defender.

Starten Sie mit KI-Sicherheitsstatusverwaltungsfunktionen in Defender Cloud Security Posture Management (CSPM). Defender CSPM ermittelt automatisch und kontinuierlich bereitgestellte KI-Workloads mit agentloser und präziser Sichtbarkeit in Anwesenheit und Konfigurationen von AI-Modellen, SDKs und Technologien, die für KI-Dienste wie Azure OpenAI Service, Azure Machine Learning und Amazon Bedrock verwendet werden.

CSPM zeigt kontinuierlich kontextbezogene Sicherheitsprobleme an und schlägt risikobasierte Sicherheitsempfehlungen vor, die darauf zugeschnitten sind, kritische Lücken in Ihren KI-Workloads zu priorisieren. Relevante Sicherheitsempfehlungen werden auch innerhalb der Azure OpenAI-Ressource selbst im Azure-Portal angezeigt, indem sie Entwicklern oder Workloadbesitzern direkten Zugriff auf Empfehlungen bietet und bei der schnelleren Behebung hilft.

Die Analysefunktion für Angriffspfade kann komplexe Risiken für KI-Workloads identifizieren, einschließlich Datensicherheitsszenarien, in denen Verankerungs- oder Feintuning-Daten durch laterale Bewegungen dem Internet ausgesetzt werden und anfällig für Datenvergiftung sind.

Im nächsten Schritt gewährleisten Sie Sicherheit während der Ausführung mit Bedrohungsschutz für KI-Arbeitspakete. Defender für Cloud umfasst Bedrohungsschutz für KI-Workloads. Der Bedrohungsschutz für KI verwendet die native Integration des Azure OpenAI Service, Schutzmechanismen für Eingabeaufforderungen des Azure AI Content Safety und die Microsoft Threat Intelligence, um kontextbezogene und umsetzbare Sicherheitswarnungen bereitzustellen. Der Schutz vor Bedrohungen für KI-Workloads ermöglicht es Sicherheitsteams, ihre mit Azure OpenAI betriebenen Anwendungen während der Laufzeit auf böswillige Aktivitäten zu überwachen, die mit direkten und indirekten Prompt-Injection-Angriffen, Lecks sensibler Daten und Datenvergiftung sowie Wallet-Missbrauch oder Denial-of-Service-Angriffen in Verbindung stehen.

Verwenden Sie die folgenden Ressourcen für die nächsten Schritte.

| Aufgabe | Empfohlene Ressourcen |

|---|---|

| Überprüfen der wichtigsten Szenarien, die in diesem Blog beschrieben werden | Sichere generative KI-Anwendungen mit Microsoft Defender für Cloud |

| Verwenden sie CSPM, um Einblicke in KI-Risiken in Ihrer Umgebung zu erhalten |

Schützen Ihrer Ressourcen mit Defender CSPM Überprüfen des Daten- und KI-Sicherheitsdashboards (Vorschau) |

| Aktivieren des Bedrohungsschutzes für KI-Workloads (Vorschau) | Aktivieren des Bedrohungsschutzes für KI-Workloads (Vorschau) Warnungen für KI-Workloads (Vorschau) |

Nächster Schritt zum Sichern von KI

Nach dem Schutz von KI-Apps und -Daten in Ihrer Organisation besteht der nächste Schritt darin, KI-Apps zu steuern, um die gesetzlichen Complianceanforderungen zu erfüllen:

- Bewerten und stärken Sie Ihre Compliance-Haltung gegenüber Vorschriften.

- Implementieren Sie Steuerelemente zur Steuerung der Verwendung von KI-Apps und -Daten.

Lesen Sie den nächsten Artikel in dieser Reihe: Wie kann ich KI für Compliance steuern?