Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

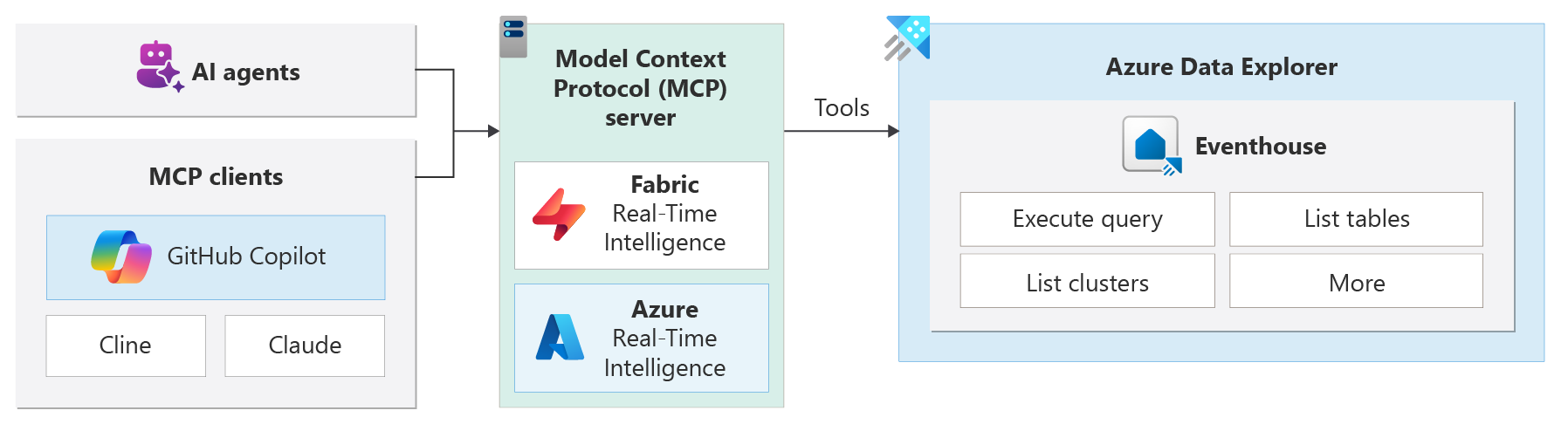

La integración del Protocolo de contexto de modelo (MCP) con clústeres de Azure Data Explorer (ADX) le permite obtener información y acciones controladas por ia en tiempo real. El servidor MCP permite que los agentes de inteligencia artificial o las aplicaciones de IA interactúen con ADX proporcionando herramientas a través de la interfaz MCP, de modo que pueda consultar y analizar datos fácilmente.

El Protocolo de contexto de modelo (MCP) es un protocolo que permite a los modelos de IA, como los modelos de Azure OpenAI, interactuar con herramientas y recursos externos. MCP facilita la búsqueda, conexión y uso de datos empresariales a los agentes.

Nota:

Esta característica se encuentra en versión preliminar.

El escenario más común para usar RTI o Azure MCP Server es conectarse a él desde un cliente de IA existente, como Cline, Claude y GitHub copilot. Después, el cliente de IA puede usar las herramientas disponibles para acceder a los recursos de ADX e interactuar con ellos mediante lenguaje natural.

Por ejemplo, podría usar el modo de agente copilot de GitHub con el servidor MCP de RTI para enumerar las bases de datos KQL o ejecutar consultas de lenguaje natural en clústeres de ADX.

Crear agentes de IA

La compatibilidad de MCP con Azure Data Explorer es una integración completa del servidor MCP de código abierto. Admite consultas de lenguaje natural y permite a los agentes detectar esquemas y metadatos dinámicamente. El servidor MCP se puede usar con varios clientes de IA, como GitHub Copilot, Cline o Claude Desktop.

Puede usar los siguientes servidores MCP para integrar y compilar agentes de INTELIGENCIA ARTIFICIAL con Azure Data Explorer:

Fabric RTI MCP Server (versión preliminar): este servidor está diseñado para su uso con clústeres de ADX o con un centro de eventos fabric Real-Time Intelligence (RTI). Proporciona una interfaz unificada para que los agentes de inteligencia artificial consulten, razonen y actúen sobre datos en tiempo real.

Servidor de Azure MCP (versión preliminar): el servidor de Azure MCP permite administrar recursos de Azure Data Explorer mediante mensajes de lenguaje natural. Puede enumerar clústeres, ver bases de datos, datos de consulta y mucho más sin recordar la sintaxis compleja del lenguaje de consulta kusto (KQL).

Arquitectura

El servidor MCP está en el núcleo del sistema y actúa como un puente entre los agentes de IA y los orígenes de datos de ADX. Los agentes envían solicitudes al servidor MCP, lo que los traduce en consultas de ADX.

Esta arquitectura le permite crear aplicaciones inteligentes modulares, escalables y seguras que responden a señales en tiempo real. MCP usa una arquitectura de servidor cliente, por lo que las aplicaciones de inteligencia artificial pueden interactuar con herramientas externas de forma eficaz. La arquitectura incluye los siguientes componentes:

- Host de MCP: el entorno host en el que se ejecuta el modelo de IA (como GPT-4, Claude o Gemini).

- Cliente MCP: un servicio intermediario reenvía las solicitudes del modelo de IA a los servidores MCP, como GitHub Copilot, Cline o Claude Desktop.

- SERVIDOR MCP: aplicaciones ligeras que exponen funcionalidades específicas por las API de lenguaje natural, las bases de datos. Por ejemplo, para ejecutar consultas KQL para la recuperación de datos en tiempo real desde clústeres de ADX.

Características clave

Acceso a datos en tiempo real: Recuperación de datos de clústeres de ADX en segundos.

Interfaces de lenguaje natural: los usuarios o agentes hacen preguntas en inglés sin formato u otros idiomas, y el sistema los convierte en consultas optimizadas (NL2KQL).

Detección de esquemas: los servidores MCP muestran el esquema y los metadatos, por lo que los agentes pueden aprender estructuras de datos dinámicamente.

Integración de Plug-and-Play: Los clientes MCP como GitHub Copilot, Claude y Cline se conectan a RTI con una configuración mínima gracias a APIs estandarizadas y mecanismos de descubrimiento.

Inferencia de idioma local: use su idioma preferido para trabajar con los datos.