Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Este tutorial sin código de 5 minutos presenta inteligencia artificial generativa en Azure Databricks. Usarás AI Playground para hacer lo siguiente:

- Consultar modelos de lenguaje grande (LLM) y comparar los resultados en paralelo

- Prototipo de un agente de IA que ejecuta herramientas

- Exporta tu agente al código

- Opcional: Prototipo de un bot de chat de pregunta-respuesta mediante la generación aumentada de recuperación (RAG)

Antes de empezar

Asegúrese de que el área de trabajo puede acceder a lo siguiente:

- Modelos de base. Consulte Disponibilidad de características de servicio de modelos.

- Catálogo de Unity. Consulte Introducción al catálogo de Unity.

- Marco de Agente de Mosaic AI Consulte Características con disponibilidad regional limitada.

Paso 1: Consulta de LLM mediante AI Playground

Usa el AI Playground para consultar los modelos de lenguaje de gran tamaño en una interfaz de chat.

- En el área de trabajo, seleccione Parque infantil.

- Escriba una pregunta como "¿Qué es RAG?".

Agregue un nuevo LLM para comparar las respuestas en paralelo:

- En la esquina superior derecha, seleccione + para agregar un modelo para la comparación.

- En el nuevo panel, seleccione otro modelo con el selector desplegable.

- Active las casillas Sincronizar para sincronizar las consultas.

- Pruebe un mensaje nuevo, como "¿Qué es un sistema de inteligencia artificial compuesto?" para ver las dos respuestas en paralelo.

Continúe probando y comparando diferentes modelos de lenguaje para ayudarle a decidir cuál es el mejor para crear un agente de IA.

Continúe probando y comparando diferentes modelos de lenguaje para ayudarle a decidir cuál es el mejor para crear un agente de IA.

Paso 2: Crear un prototipo de un agente de IA para llamar herramientas

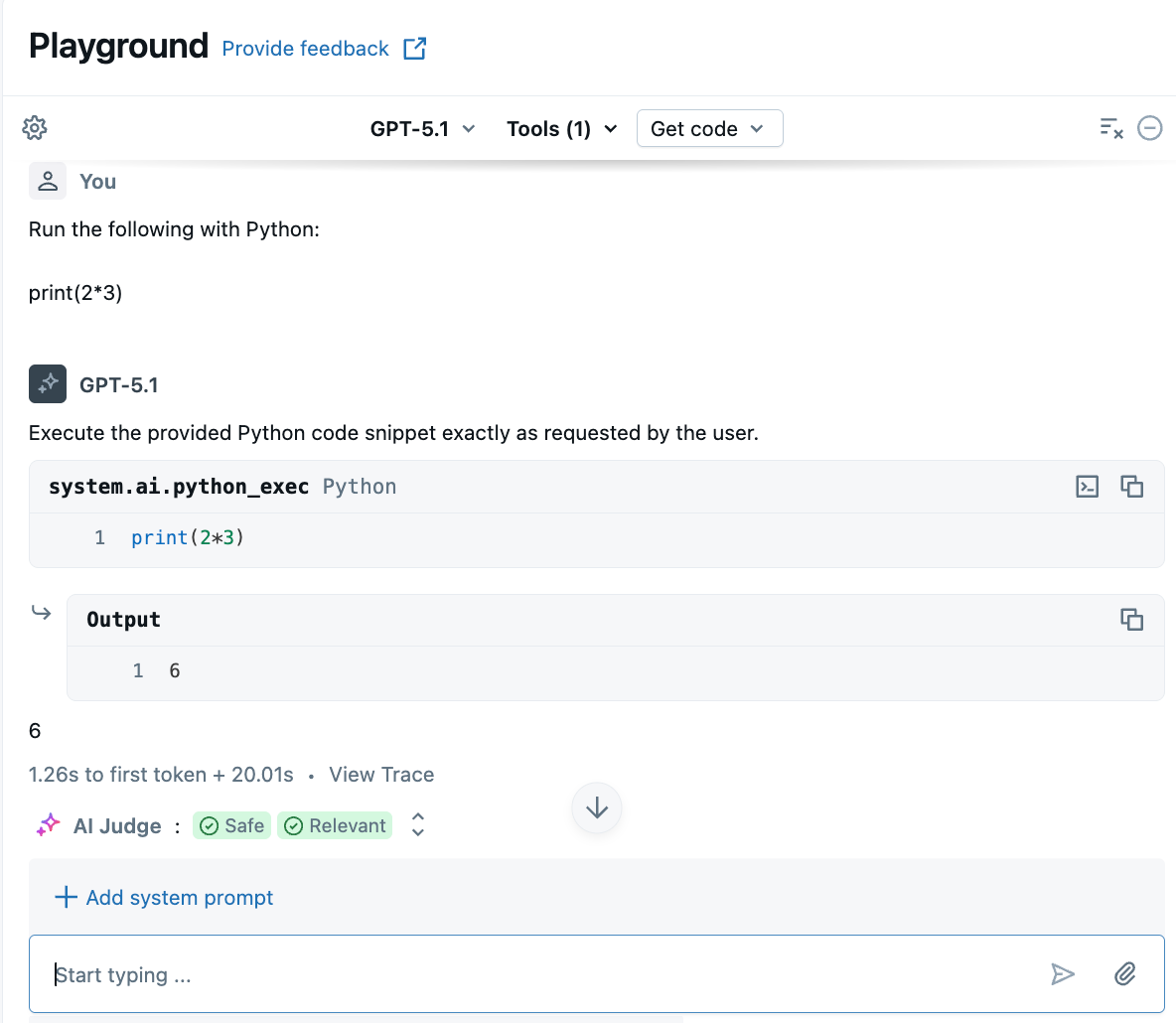

Las herramientas permiten que las LLM realicen más que generar lenguaje. Las herramientas pueden consultar datos externos, ejecutar código y realizar otras acciones. AI Playground te ofrece una opción sin código para prototipar agentes para invocar herramientas.

En Área de juegos, elija un modelo con la etiqueta Herramientas habilitadas.

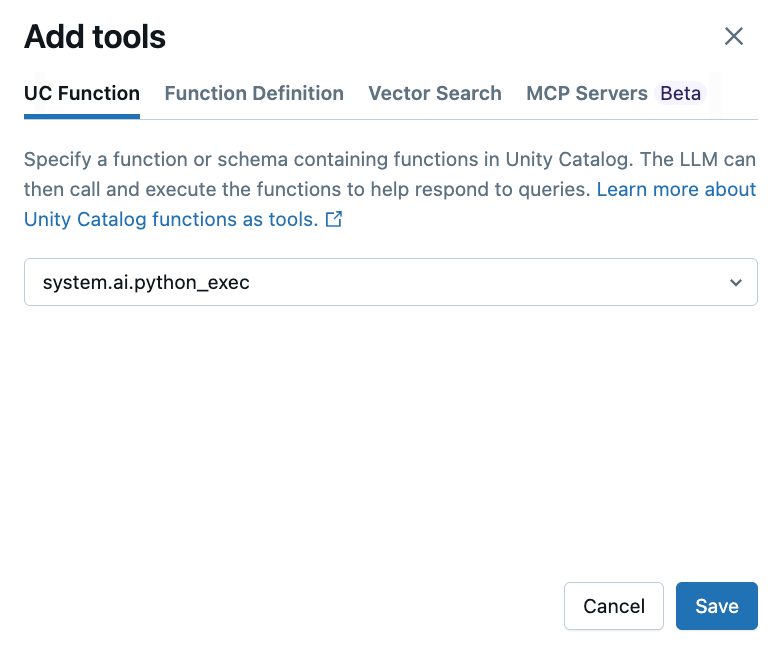

Seleccione Herramientas>+ Agregar herramienta y seleccione la función integrada Catálogo de Unity,

system.ai.python_exec.Esta función permite al agente ejecutar código arbitrario de Python.

Haga una pregunta que implique generar o ejecutar código de Python. Puede probar diferentes variaciones en la expresión del mensaje. Si agrega varias herramientas, LLM selecciona la herramienta adecuada para generar una respuesta.

Paso 3: Exporta tu agente al código

Después de probar el agente en AI Playground, haga clic en

El cuaderno de Python contiene código que define el agente y lo despliega en un endpoint de servicio del modelo.

Opcional: Prototipo de un bot de respuesta a preguntas RAG

Si tiene un índice de búsqueda vectorial configurado en el área de trabajo, puede crear prototipos de un bot de respuesta a preguntas. Este tipo de agente usa documentos en un índice de búsqueda vectorial para responder a preguntas basadas en esos documentos.

Haga clic en Herramientas>+ Agregar herramienta. A continuación, seleccione el índice de búsqueda vectorial.

Haga una pregunta relacionada con sus documentos. El agente puede usar el índice vectorial para buscar información relevante y citará los documentos usados en su respuesta.

Para configurar un índice de búsqueda vectorial, consulte Creación de un índice de búsqueda vectorial.

Pasos siguientes

Use Agent Framework para desarrollar agentes avanzados programáticamente. Consulte Creación de agentes de IA en el código.

Obtenga información sobre cómo compilar una aplicación RAG. Consulte la guía RAG.