Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

La extensión Fabric Data Engineering VS Code admite una experiencia profesional para explorar los lakehouses de Microsoft Fabric y crear notebooks de Fabric y definiciones de trabajos de Spark.

En este artículo, obtendrá más información sobre la extensión, incluido cómo empezar a trabajar con los requisitos previos necesarios.

Visual Studio Code (VS Code) es uno de los editores de código fuente más populares; se ejecuta en el escritorio y está disponible para Windows, macOS y Linux. Al instalar la extensión Fabric Data Engineering VS Code, puede crear, ejecutar y depurar el cuaderno y la definición de trabajo de Spark localmente en VS Code. También puede publicar el código en el entorno de cómputo remoto de Spark en el área de trabajo de Fabric para ejecutar o depurar. La extensión también le permite examinar los datos de lakehouse, incluidas tablas y archivos sin procesar, en VS Code.

Prerrequisitos

Requisitos previos para la extensión de VS Code:

- Instale Visual Studio Code.

- Instale la extensión de Jupyter para VS Code

Instalación de la extensión y preparación del entorno

Busque Fabric Data Engineering VS Code en el marketplace de extensiones de VS Code e instale la extensión.

Una vez completada la instalación de la extensión, reinicie VS Code. VS Code muestra el icono de la extensión en la barra de actividad.

Acceso a la paleta de comandos

Puede acceder a muchas de las características de la extensión a través de la paleta de comandos de VS Code. Para abrir la paleta de comandos:

- En Windows/Linux: presione Ctrl+Mayús+P

- En macOS: presione Cmd+Mayús+P

Como alternativa, puede acceder a él desde el menú seleccionando Ver>paleta de comandos.

Una vez que se abra la paleta de comandos, empiece a escribir el nombre del comando (por ejemplo, "Fabric Data Engineering") para filtrar y buscar los comandos que proporciona la extensión.

Directorio de trabajo local

Para editar un cuaderno, debe tener una copia local del contenido del cuaderno. El directorio de trabajo local de la extensión sirve como carpeta raíz local para todos los cuadernos descargados, incluso cuadernos de áreas de trabajo diferentes. Al invocar el comando Fabric Data Engineering: Set Local Work Folder, puede especificar una carpeta como directorio de trabajo local para la extensión.

Para validar la configuración, abra la configuración de la extensión y compruebe los detalles allí:

Iniciar y cerrar sesión en tu cuenta

En la paleta de comandos de VS Code, escriba el comando

Fabric Data Engineering: Sign Inpara iniciar sesión en la extensión. Aparece una página de inicio de sesión del explorador independiente.Escriba el nombre de usuario y la contraseña.

Después de iniciar sesión correctamente, la barra de estado de VS Code muestra el nombre de usuario para indicar que ha iniciado sesión.

Para cerrar la sesión de la extensión, escriba el comando

Fabric Data Engineering: Sign Out.

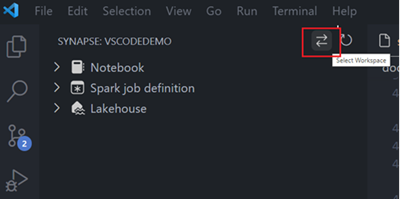

Elección de un área de trabajo con la que trabajar

Para seleccionar un área de trabajo de Fabric:

Debe tener un área de trabajo creada. Si no tiene una, puede crear una en el portal de Fabric. Para obtener más información, consulte Creación de un área de trabajo.

Una vez que tenga un área de trabajo, selecciónela seleccionando la opción Seleccionar área de trabajo. Aparece una lista de todas las áreas de trabajo a las que tiene acceso; seleccione la que desee en la lista.

Limitaciones actuales

- La extensión no admite comandos de shell que empiecen por "!".

Contenido relacionado

Ahora tiene conocimientos básicos sobre cómo instalar y configurar la extensión fabric Data Engineering VS Code. En los artículos siguientes se explica cómo desarrollar los cuadernos y las definiciones de trabajos de Spark localmente en VS Code.

- Para empezar a trabajar con cuadernos, consulte Creación y administración de cuadernos de Microsoft Fabric en Visual Studio Code.

- Para empezar a trabajar con las definiciones de trabajos de Spark, consulte Creación y administración de definiciones de trabajos de Apache Spark en Visual Studio Code.