Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Para obtener información empresarial y enriquecimiento de datos, Microsoft Fabric ofrece experiencias de ciencia de datos que permiten a los usuarios crear flujos de trabajo de ciencia de datos de un extremo a otro. Para empezar, consulte el tutorial de un extremo a otro de ciencia de datos.

Puede completar una amplia gama de actividades en todo el proceso de ciencia de datos:

- exploración de datos

- Preparación de datos

- limpieza de datos

- experimentación

- modelado

- evaluación de modelos

- proporcionar información predictiva a informes de BI

Los usuarios de Microsoft Fabric pueden acceder a una página principal de Ciencia de datos. A continuación, pueden detectar y acceder a varios recursos relevantes, como se muestra en la captura de pantalla siguiente:

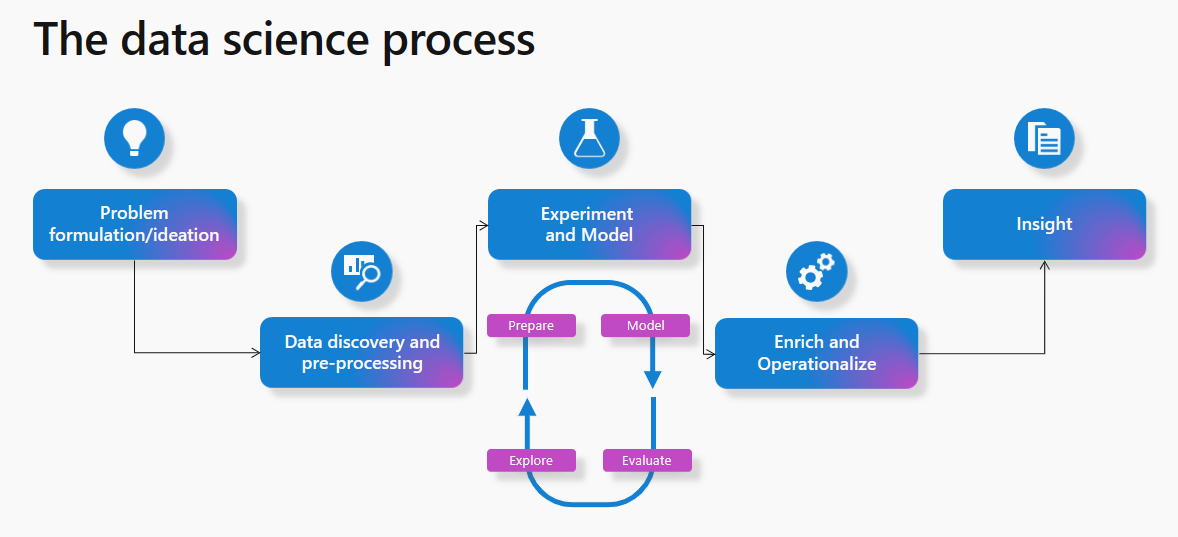

La mayoría de los proyectos de aprendizaje automático siguen el proceso de ciencia de datos. En un nivel alto, ese proceso implica estos pasos:

- formulación y ideación de problemas

- detección y preprocesamiento de datos

- experimentación y modelado

- enriquecer y operacionalizar

- build insights

En este artículo se describen las funcionalidades de ciencia de datos de Microsoft Fabric desde una perspectiva del proceso de ciencia de datos. Para cada paso del proceso de ciencia de datos, en este artículo se resumen las funcionalidades de Microsoft Fabric que pueden ayudar.

Formulación e ideación de problemas

Los usuarios de ciencia de datos de Microsoft Fabric trabajan en la misma plataforma que los usuarios empresariales y los analistas. El uso compartido y la colaboración de datos se vuelven más fluidas en distintos roles como resultado. Los analistas pueden compartir fácilmente informes y conjuntos de datos de Power BI con profesionales de ciencia de datos. La facilidad de colaboración entre roles en Microsoft Fabric facilita las entregas durante la fase de formulación de problemas.

Detección y preprocesamiento de datos

Los usuarios de Microsoft Fabric pueden interactuar con los datos de OneLake mediante el recurso lakehouse. Para examinar e interactuar con los datos, Lakehouse se asocia fácilmente a un cuaderno. Los usuarios pueden leer fácilmente datos de una instancia de Lakehouse directamente en un dataframe de Pandas. Para la exploración, las lecturas de datos sin problemas de OneLake se vuelven posibles.

Hay disponible un conjunto eficaz de herramientas para canalizaciones de ingesta de datos y orquestación de datos con canalizaciones de integración de datos: una parte integrada de forma nativa de Microsoft Fabric. Las canalizaciones fáciles de construir pueden acceder a los datos y transformarlos en un formato que pueda consumir el aprendizaje automático.

Exploración de datos

Una parte importante del proceso de aprendizaje automático implica comprender los datos a través de la exploración y visualización.

En función de la ubicación del almacenamiento de datos, Microsoft Fabric ofrece herramientas para explorar y preparar los datos para el análisis y el aprendizaje automático. Los propios cuadernos se convierten en herramientas de exploración de datos eficientes y eficaces.

Apache Spark y Python para la preparación de datos

Microsoft Fabric puede transformar, preparar y explorar los datos a escala. Con Spark, los usuarios pueden usar las herramientas PySpark/Python, Scala y SparkR/SparklyR para preprocesar datos a escala. Las eficaces bibliotecas de visualización de código abierto pueden mejorar la experiencia de exploración de datos para comprender mejor los datos.

Data Wrangler para una limpieza de datos sin problemas

Para usar Data Wrangler, la experiencia de Microsoft Fabric Notebook agregó una característica de herramienta de código que prepara los datos y genera código de Python. Esta experiencia facilita la aceleración de tareas tediosas y mundanas, por ejemplo, la limpieza de datos. Con él, también puede crear automatización y repetibilidad a través del código generado. Obtenga más información sobre Data Wrangler en la sección Data Wrangler de este documento.

Experimentación y modelado de ML

Con herramientas como PySpark/Python y SparklyR/R, los cuadernos pueden controlar el entrenamiento del modelo de aprendizaje automático. Los algoritmos y bibliotecas de aprendizaje automático pueden ayudar a entrenar modelos de aprendizaje automático. Las herramientas de administración de bibliotecas pueden instalar estas bibliotecas y algoritmos. Luego, los usuarios pueden emplear bibliotecas populares de aprendizaje automático para completar el entrenamiento de modelos de aprendizaje automático en Microsoft Fabric. Además, las bibliotecas populares como Scikit Learn también pueden desarrollar modelos.

Los experimentos y ejecuciones de MLflow pueden realizar un seguimiento del entrenamiento del modelo de ML. Para registrar experimentos y modelos, Microsoft Fabric ofrece una experiencia de MLflow integrada que admite la interacción. Obtenga más información sobre cómo usar MLflow para realizar un seguimiento de los experimentos y administrar modelos en Microsoft Fabric.

SynapseML

Microsoft posee y opera la biblioteca de código abierto de SynapseML (anteriormente conocida como MMLSpark). Simplifica la creación de canalizaciones de aprendizaje automático escalables de forma masiva. Como ecosistema de herramientas, expande el marco de Apache Spark en varias direcciones nuevas. SynapseML unifica varios marcos de aprendizaje automático existentes y nuevos algoritmos de Microsoft en una sola API escalable. La biblioteca synapseML de código abierto incluye un amplio ecosistema de herramientas de APRENDIZAJE automático para el desarrollo de modelos predictivos y usa modelos de INTELIGENCIA artificial entrenados previamente de los servicios de Azure AI. Para más información, visite el recurso synapseML .

Enriquecer y poner en funcionamiento

Los cuadernos pueden controlar la puntuación por lotes del modelo de aprendizaje automático con bibliotecas de código abierto para la predicción. También pueden gestionar la función Predict universal de Spark escalable de Microsoft Fabric. Esta función admite modelos empaquetados de MLflow en el registro de modelos de Microsoft Fabric.

Obtener más información

En Microsoft Fabric, puede escribir fácilmente valores previstos en OneLake. Desde allí, los informes de Power BI pueden consumirlos sin interrupciones con el modo Direct Lake de Power BI. Los profesionales de ciencia de datos pueden compartir fácilmente los resultados de su trabajo con las partes interesadas, y simplifica la operacionalización.

Puede usar características de programación de cuadernos para programar ejecuciones de cuadernos que contienen puntuación por lotes. También puede programar la evaluación por lotes como parte de las actividades de canalización o los trabajos de Spark. Con el modo Direct Lake en Microsoft Fabric, Power BI obtiene automáticamente las predicciones más recientes sin necesidad de cargas o refrescos de datos.

Exploración de datos con vínculo semántico

Los científicos de datos y los analistas de negocios pasan mucho tiempo intentando comprender, limpiar y transformar datos antes de que pueda comenzar un análisis significativo. Normalmente, los analistas de negocios trabajan con modelos semánticos y codifican su conocimiento de dominio y la lógica de negocios en medidas de Power BI. Por otro lado, los científicos de datos pueden trabajar con los mismos datos, pero normalmente usan un lenguaje o entorno de código diferente. Con el vínculo semántico, los científicos de datos pueden establecer una conexión entre los modelos semánticos de Power BI y la ciencia de datos de Synapse en la experiencia de Microsoft Fabric a través de la biblioteca de Python de SemPy. Para simplificar el análisis de datos, SemPy captura y usa la semántica de datos a medida que los usuarios realizan diversas transformaciones en los modelos semánticos. Cuando los científicos de datos usan un vínculo semántico, pueden

- evitar la reimplementación de la lógica de negocios y el conocimiento de dominio en su código

- Acceso sencillo y uso de medidas de Power BI en su código

- usar la semántica para impulsar nuevas experiencias, por ejemplo, funciones semánticas

- explorar y validar las dependencias funcionales y las relaciones entre los datos

Cuando las organizaciones usan SemPy, pueden esperar

- mayor productividad y colaboración más rápida entre equipos que operan en los mismos conjuntos de datos

- aumento de la colaboración cruzada entre equipos de inteligencia empresarial e inteligencia artificial

- reducción de la ambigüedad y una curva de aprendizaje más sencilla al incorporarse a un nuevo modelo o conjunto de datos

Para obtener más información sobre el vínculo semántico, consulte ¿Qué es el vínculo semántico?.

Contenido relacionado

- Visite Los tutoriales de ciencia de datos para empezar a trabajar con ejemplos completos de ciencia de datos

- Visite Data Wrangler para obtener más información sobre la preparación y limpieza de datos con Data Wrangler.

- Visite el experimento de Aprendizaje automático para obtener más información sobre los experimentos de seguimiento.

- Visite El modelo de Machine Learning para más información sobre la administración de modelos.

- Visite Puntuación de modelos con PREDICT para obtener más información sobre la puntuación por lotes con Predict.

- Predicciones de Serve Lakehouse en Power BI con Direct Lake