Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

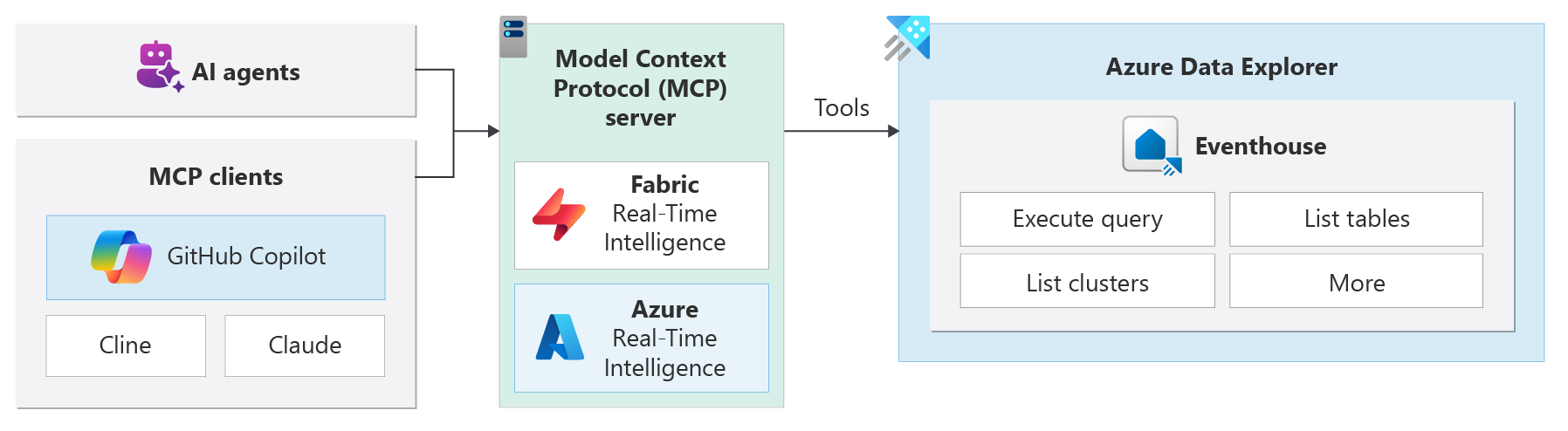

L’intégration du protocole MCP (Model Context Protocol) avec des clusters Azure Data Explorer (ADX) vous permet d’obtenir des insights et des actions pilotés par l’IA en temps réel. Le serveur MCP permet aux agents IA ou aux applications IA d’interagir avec ADX en fournissant des outils via l’interface MCP, afin de pouvoir interroger et analyser facilement les données.

Le protocole MCP (Model Context Protocol) est un protocole qui permet aux modèles IA, comme les modèles Azure OpenAI, d’interagir avec des outils et des ressources externes. MCP facilite la recherche, la connexion et l’utilisation des données d’entreprise pour les agents.

Remarque

Cette fonctionnalité est en préversion.

Le scénario le plus courant d’utilisation du serveur RTI ou Azure MCP consiste à se connecter à celui-ci à partir d’un client IA existant, tel que Cline, Claude et GitHub copilot. Le client IA peut ensuite utiliser les outils disponibles pour accéder aux ressources ADX et interagir avec eux à l’aide du langage naturel.

Par exemple, vous pouvez utiliser le mode agent Copilot GitHub avec le serveur MCP RTI pour répertorier les bases de données KQL ou exécuter des requêtes en langage naturel sur des clusters ADX.

Générer des agents IA

La prise en charge de MCP pour Azure Data Explorer est une intégration complète d’un serveur MCP open source. Il prend en charge les requêtes en langage naturel et permet aux agents de découvrir dynamiquement des schémas et des métadonnées. Le serveur MCP peut être utilisé avec différents clients IA, tels que GitHub Copilot, Cline ou Claude Desktop.

Vous pouvez utiliser les serveurs MCP suivants pour intégrer et générer des agents IA avec Azure Data Explorer :

Fabric RTI MCP Server (préversion) : ce serveur est conçu pour une utilisation avec des clusters ADX ou avec un Eventhouse Fabric Real-Time Intelligence (RTI). Il fournit une interface unifiée pour que les agents IA interrogent, raison et agissent sur des données en temps réel.

Serveur Azure MCP (préversion) : le serveur Azure MCP vous permet de gérer les ressources Azure Data Explorer à l’aide d’invites en langage naturel. Vous pouvez répertorier des clusters, afficher des bases de données, des données de requête et bien plus encore sans mémoriser la syntaxe KQL (Kusto Query Language) complexe.

Architecture

Le serveur MCP est au cœur du système et agit comme un pont entre les agents IA et les sources de données ADX. Les agents envoient des requêtes au serveur MCP, ce qui les traduit en requêtes ADX.

Cette architecture vous permet de créer des applications intelligentes modulaires, évolutives et sécurisées qui répondent aux signaux en temps réel. MCP utilise une architecture de serveur client, afin que les applications IA puissent interagir efficacement avec des outils externes. L’architecture comprend les composants suivants :

- Hôte MCP : environnement hôte dans lequel le modèle IA s’exécute (comme GPT-4, Claude ou Gemini).

- Client MCP : un service intermédiaire transfère les demandes du modèle IA aux serveurs MCP, tels que GitHub Copilot, Cline ou Claude Desktop.

- MCP Server : applications légères exposant des fonctionnalités spécifiques par les API de langage naturel, les bases de données. Par exemple, pour exécuter des requêtes KQL pour la récupération de données en temps réel à partir de clusters ADX.

Fonctionnalités clés

Accès aux données en temps réel : récupération de données à partir de clusters ADX en quelques secondes.

Interfaces de langage naturel : les utilisateurs ou les agents posent des questions en anglais brut ou d’autres langues, et le système les transforme en requêtes optimisées (NL2KQL).

Découverte de schéma : les serveurs MCP affichent le schéma et les métadonnées, afin que les agents puissent apprendre dynamiquement des structures de données.

Intégration plug-and-Play : les clients MCP tels que GitHub Copilot, Claude et Cline se connectent à RTI avec une configuration minimale en raison de mécanismes de découverte et d’API standardisés.

Inférence de langue locale : utilisez votre langue préférée pour utiliser vos données.