Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

L’activité Azure Databricks dans Data Factory pour Microsoft Fabric vous permet d’orchestrer les travaux Azure Databricks suivants :

- Carnet de notes

- Jar

- Python

- Job

Cet article fournit une procédure pas à pas qui décrit comment créer une activité Azure Databricks à l’aide de l’interface Data Factory.

Prérequis

Pour commencer, vous devez remplir les conditions préalables suivantes :

- Un compte locataire avec un abonnement actif. Créez un compte gratuitement.

- Un espace de travail est créé.

Configurer une activité Azure Databricks

Pour utiliser une activité Azure Databricks dans un pipeline, procédez comme suit :

Configurer une connexion

Créez un pipeline dans votre espace de travail.

Sélectionnez Ajouter une activité de pipeline et recherchez Azure Databricks.

Vous pouvez également rechercher Azure Databricks dans le volet Activités du pipeline, puis sélectionnez-le pour l’ajouter au canevas du pipeline.

Sélectionnez la nouvelle activité Azure Databricks sur le canevas si elle n’est pas déjà sélectionnée.

Reportez-vous aux instructions relatives aux paramètres Général pour configurer l’onglet Paramètres Général .

Configurer des clusters

Sélectionnez l’onglet Cluster. Vous pouvez créer une connexion Azure Databricks ou choisir une connexion existante, puis choisir un nouveau cluster de travaux, un cluster interactif existant ou un pool d’instances existant.

Selon ce que vous choisissez pour le cluster, renseignez les champs correspondants comme indiqué.

- Sous le nouveau cluster de travaux et le pool d’instances existant, vous avez également la possibilité de configurer le nombre de workers et d’activer des instances spot.

Vous pouvez également spécifier d’autres paramètres de cluster , tels que la stratégie de cluster, la configuration Spark, les variables d’environnement Spark et les balises personnalisées, comme requis pour le cluster auquel vous vous connectez. Les scripts init Databricks et le chemin de destination du journal de cluster peuvent également être ajoutés sous les paramètres de cluster supplémentaires.

Remarque

Toutes les propriétés de cluster avancées et expressions dynamiques prises en charge dans le service lié Azure Databricks Azure Databricks sont désormais également prises en charge dans l’activité Azure Databricks dans Microsoft Fabric, sous la section « Configuration de cluster supplémentaire » de l’interface utilisateur. Comme ces propriétés sont désormais incluses dans l’interface utilisateur d’activité, elles peuvent être utilisées avec une expression (contenu dynamique) sans avoir besoin de la spécification JSON avancée.

L’activité Azure Databricks prend désormais également en charge la prise en charge de la stratégie de cluster et du catalogue Unity.

- Sous paramètres avancés, vous pouvez choisir la stratégie de cluster pour spécifier les configurations de cluster autorisées.

- En outre, sous paramètres avancés, vous pouvez configurer le mode d’accès au catalogue Unity pour renforcer la sécurité. Les types de mode d’accès disponibles sont les suivants :

- Mode d’accès utilisateur unique Ce mode est conçu pour les scénarios où chaque groupement est utilisé par un seul utilisateur. Il garantit que l’accès aux données au sein du groupement est limité uniquement à cet utilisateur. Ce mode est utile pour les tâches qui nécessitent une isolation et une gestion individuelle des données.

- Mode d’accès partagé : dans ce mode, plusieurs utilisateurs peuvent accéder au même groupement. Il combine la gouvernance des données du catalogue Unity avec les listes de contrôle d’accès aux tables héritées (ACL). Ce mode permet l’accès aux données collaboratives tout en conservant les protocoles de gouvernance et de sécurité. Toutefois, il présente certaines limitations, telles que la prise en charge de Databricks Runtime ML, des travaux Spark-submit et des API Spark spécifiques et des UDF.

- Aucun mode d’accès Ce mode désactive l’interaction avec le catalogue Unity, ce qui signifie que les clusters n’ont pas accès aux données gérées par Unity Catalog. Ce mode est utile pour les charges de travail qui ne nécessitent pas les fonctionnalités de gouvernance du catalogue Unity.

Configurer des paramètres

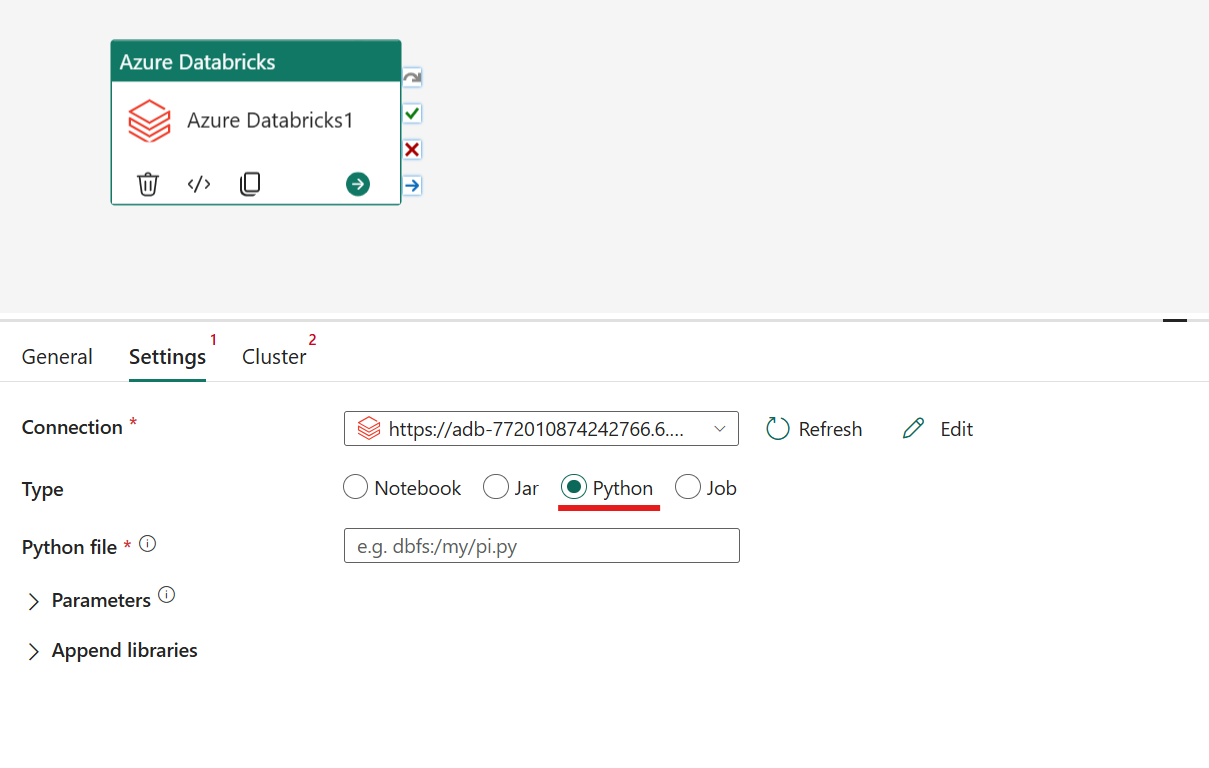

En sélectionnant l’onglet Paramètres , vous pouvez choisir entre 4 options parmi lesquelles le type Azure Databricks que vous souhaitez orchestrer.

Orchestrer le type notebook dans l’activité Azure Databricks :

Sous l’onglet Paramètres, vous pouvez choisir la case d’option Notebook pour exécuter un notebook. Vous devez spécifier le chemin d’accès du notebook à exécuter sur Azure Databricks, les paramètres de base facultatifs à passer au notebook et toutes les bibliothèques supplémentaires à installer sur le cluster pour exécuter le travail.

Orchestrer le type Jar dans l’activité Azure Databricks :

Sous l’onglet Paramètres, vous pouvez choisir la case d’option Jar pour exécuter un fichier Jar. Vous devez spécifier le nom de classe à exécuter sur Azure Databricks, les paramètres de base facultatifs à passer au fichier Jar, ainsi que toutes les bibliothèques supplémentaires à installer sur le cluster pour exécuter le travail.

Orchestrer le type Python dans l’activité Azure Databricks :

Sous l’onglet Paramètres, vous pouvez choisir la case d’option Python pour exécuter un fichier Python. Vous devez spécifier le chemin d’accès dans Azure Databricks vers un fichier Python à exécuter, des paramètres de base facultatifs à passer et toutes les bibliothèques supplémentaires à installer sur le cluster pour exécuter le travail.

Orchestrer le type de travail dans l’activité Azure Databricks :

Sous l’onglet Paramètres , vous pouvez choisir la case d’option Travail pour exécuter un travail Databricks. Vous devez spécifier le travail à l’aide de la liste déroulante à exécuter sur Azure Databricks et tous les paramètres de travail facultatifs à passer. Vous pouvez exécuter des travaux serverless avec cette option.

Bibliothèques prises en charge pour l’activité Azure Databricks

Dans la définition d’activité Databricks ci-dessus, vous pouvez préciser ces types de bibliothèques : jar, egg, whl, maven, pypi et cran.

Pour plus d’informations, consultez la documentation Databricks pour les types de bibliothèques.

Transférer des paramètres entre l’activité Azure Databricks et les pipelines

Vous pouvez passer des paramètres à des notebooks à l’aide de la propriété baseParameters dans l’activité Databricks.

Parfois, vous devrez peut-être retourner des valeurs d’un notebook au service pour le contrôle du flux ou à utiliser dans les activités en aval (avec une limite de taille de 2 Mo).

Dans votre bloc-notes, par exemple, vous pouvez appeler dbutils.notebook.exit(« returnValue ») et le « returnValue » correspondant est retourné au service.

Vous pouvez utiliser la sortie dans le service en utilisant une expression telle que

@{activity('databricks activity name').output.runOutput}.

Enregistrer et exécuter ou planifier le pipeline

Après avoir configuré toutes les autres activités requises pour votre pipeline, basculez vers l’onglet Accueil en haut de l’éditeur de pipeline et sélectionnez le bouton Enregistrer pour enregistrer votre pipeline. Sélectionnez Exécuter pour l'exécuter directement ou Planifier pour le planifier. Vous pouvez également afficher l'historique d'exécution ici ou configurer d'autres paramètres.