Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Dans ce guide de démarrage rapide, vous allez découvrir comment les flux de données et les pipelines fonctionnent ensemble pour créer une solution Data Factory puissante. Vous allez nettoyer les données à l'aide de flux de données et les transférer avec des pipelines.

Conditions préalables

Avant de commencer, vous avez besoin des éléments suivants :

- Un compte de locataire avec un abonnement actif. Créer un compte gratuit.

- Un espace de travail Microsoft Fabric activé : configurez un espace de travail qui n’est pas l’espace de travail par défaut appelé "Mon espace de travail".

- Une base de données Azure SQL avec des données de table.

- Compte Stockage Blob.

Comparer les flux de données et les pipelines

Dataflow Gen2 fournit une interface low-code avec plus de 300 transformations basées sur l'IA et les données. Vous pouvez facilement nettoyer, préparer et transformer des données avec flexibilité. Les pipelines offrent des fonctionnalités d’orchestration de données enrichies pour composer des flux de travail de données flexibles répondant aux besoins de votre entreprise.

Dans un pipeline, vous pouvez créer des regroupements logiques d’activités qui effectuent une tâche. Cela peut inclure l’appel d’un dataflow pour nettoyer et préparer vos données. Bien que certaines fonctionnalités se chevauchent entre les deux, votre choix varie selon que vous avez besoin des fonctionnalités complètes des pipelines ou que vous pouvez utiliser les fonctionnalités plus simples des flux de données. Pour plus d’informations, consultez le Guide de Décision Fabric.

Transformer des données avec des dataflows

Suivez ces étapes pour configurer votre dataflow.

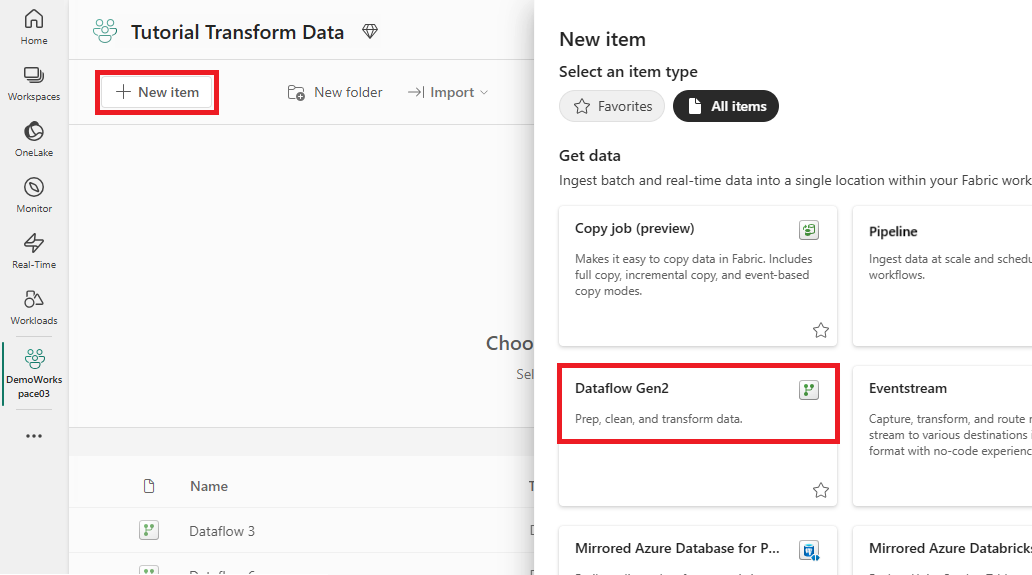

Créer un flux de données

Sélectionnez votre espace de travail avec Infrastructure, puis Nouveau, puis choisissez Dataflow Gen2.

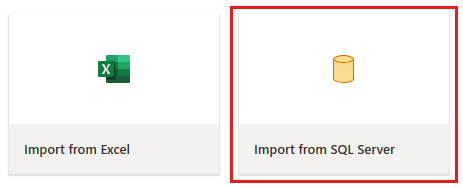

Dans l’éditeur de flux de données, sélectionnez Importer à partir de SQL Server.

Obtenir des données

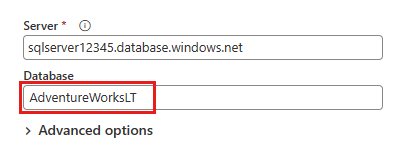

Dans la boîte de dialogue Se connecter à la source de données , entrez les détails de votre base de données Azure SQL, puis sélectionnez Suivant. Utilisez l’exemple de base de données AdventureWorksLT à partir des prérequis.

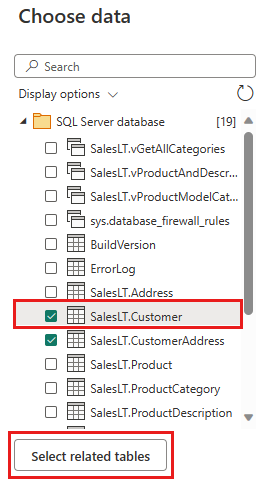

Sélectionnez les données à transformer, telles que SalesLT.Customer, et utilisez sélectionner des tables associées pour inclure des tables associées. Sélectionnez Ensuite Créer.

Transformer vos données

Sélectionnez la vue Diagramme dans la barre d’état ou le menu Affichage dans l’éditeur Power Query.

Sélectionnez avec le bouton droit votre requête SalesLT Customer , ou sélectionnez les points de suspension verticaux à droite de la requête, puis sélectionnez Fusionner les requêtes.

Configurez la fusion avec SalesLTOrderHeader en tant que table de droite, CustomerID comme colonne de jointure et jointure externe gauche comme type de jointure. Cliquez sur OK.

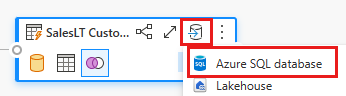

Ajoutez une destination de données en sélectionnant le symbole de base de données avec une flèche. Choisissez la base de données Azure SQL comme type de destination.

Fournissez les détails de votre connexion de base de données Azure SQL où la requête de fusion doit être publiée. Dans cet exemple, nous utilisons également la base de données AdventureWorksLT que nous avons utilisée comme source de données pour la destination.

Choisissez une base de données pour stocker les données, puis fournissez un nom de table, puis sélectionnez suivant .

Acceptez les paramètres par défaut dans la boîte de dialogue Choisir les paramètres de destination , puis sélectionnez Enregistrer les paramètres.

Sélectionnez Publier dans l’éditeur de flux de données pour publier le flux de données.

Déplacer des données avec des pipelines

Maintenant que vous avez créé un Dataflow Gen2, vous pouvez l’utiliser dans un pipeline. Dans cet exemple, vous copiez les données générées à partir du flux de données dans le format texte dans un compte stockage Blob Azure.

Créer un pipeline

Dans votre espace de travail, sélectionnez Nouveau, puis Pipeline.

Nommez votre pipeline et sélectionnez Créer.

Configurer votre dataflow

Ajoutez une activité de flux de données à votre pipeline en sélectionnant Dataflow sous l’onglet Activités .

Sélectionnez le flux de données sur le canevas du pipeline, accédez à l’onglet Paramètres , puis choisissez le flux de données que vous avez créé précédemment.

Sélectionnez Enregistrer, puis Exécuter pour remplir la table de requête fusionnée.

Ajouter une activité Copy

Sélectionnez Copier des données sur le canevas ou utilisez l’Assistant Copie sous l’onglet Activités .

Choisissez Azure SQL Database comme source de données, puis sélectionnez Suivant.

Créez une connexion à votre source de données en sélectionnant Créer une connexion. Renseignez les informations de connexion requises dans le panneau et entrez AdventureWorksLT pour la base de données, où nous avons généré la requête de fusion dans le flux de données. Sélectionnez ensuite suivant.

Sélectionnez la table que vous avez générée à l’étape de flux de données précédemment, puis sélectionnez suivant.

Pour votre destination, choisissez Azure Blob Storage, puis sélectionnez Suivant.

Créez une connexion à votre destination en sélectionnant Créer une connexion. Fournissez les détails de votre connexion, puis sélectionnez suivant .

Sélectionnez le chemin d’accès de votre dossier et fournissez un nom de fichier , puis sélectionnez suivant.

Sélectionnez Suivant à nouveau pour accepter le format de fichier par défaut, le délimiteur de colonne, le délimiteur de ligne et le type de compression, y compris éventuellement un en-tête.

Finalisez vos paramètres. Ensuite, passez en revue et sélectionnez Enregistrer + Exécuter pour terminer le processus.

Concevez votre pipeline et sauvegardez pour exécuter et charger des données

Pour exécuter l’activité de copie après l’activité de flux de données, faites glisser l’activité Réussite de l’activité de flux de données vers l’activité de copie. L’activité Copier s’exécute uniquement une fois que l’activité flux de données réussit.

Sélectionnez Enregistrer pour enregistrer votre pipeline. Sélectionnez Ensuite Exécuter pour exécuter votre pipeline et charger vos données.

Planifier l’exécution du pipeline

Une fois que vous avez terminé le développement et le test de votre pipeline, vous pouvez le planifier automatiquement.

Sous l’onglet Accueil de la fenêtre de l’éditeur de pipeline, sélectionnez Planification.

Configurez la planification en fonction des besoins. L’exemple ci-dessous planifie l’exécution quotidienne du pipeline à 18h00 jusqu’à la fin de l’année.

Contenu connexe

Cet exemple vous montre comment créer et configurer un Dataflow Gen2 pour créer une requête de fusion et le stocker dans une base de données Azure SQL, puis copier des données de la base de données dans un fichier texte dans stockage Blob Azure. Vous avez appris à :

- Créez un dataflow.

- Transformez des données avec le dataflow.

- Créez un pipeline à l’aide du flux de données.

- Ordonner l’exécution des étapes dans le pipeline.

- Copiez des données avec l’Assistant Copie.

- Exécutez et planifiez votre pipeline.

Ensuite, avancez pour en savoir plus sur la supervision des exécutions de votre pipeline.