Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Les blocs-notes Microsoft Fabric prennent en charge une interaction transparente avec les données Lakehouse à l'aide de Pandas, la bibliothèque Python la plus populaire pour l'exploration et le traitement des données. Dans un bloc-notes, vous pouvez rapidement lire des données à partir de vos ressources Lakehouse et les réécrire dans différents formats de fichiers. Ce guide fournit des exemples de code pour vous aider à démarrer dans votre propre bloc-notes.

Prérequis

Obtenir un abonnement Microsoft Fabric. Ou, inscrivez-vous pour un essai gratuit de Microsoft Fabric.

Connectez-vous à Microsoft Fabric.

Basculez vers Fabric à l’aide du sélecteur d’expérience situé en bas à gauche de votre page d’accueil.

- Suivez les étapes décrites dans Préparer votre système pour les didacticiels de science des données pour créer un bloc-notes et y attacher un Lakehouse. Pour cet article, suivez les étapes de création d’un bloc-notes plutôt que d’importer un bloc-notes existant.

Charger les données de Lakehouse dans un bloc-notes

Remarque

Vous avez besoin de certaines données dans votre Lakehouse pour suivre les étapes décrites dans cette section. Si vous n’avez pas de données, suivez les étapes décrites dans Télécharger le jeu de données et chargez sur lakehouse pour ajouter le fichier churn.csv à votre Lakehouse.

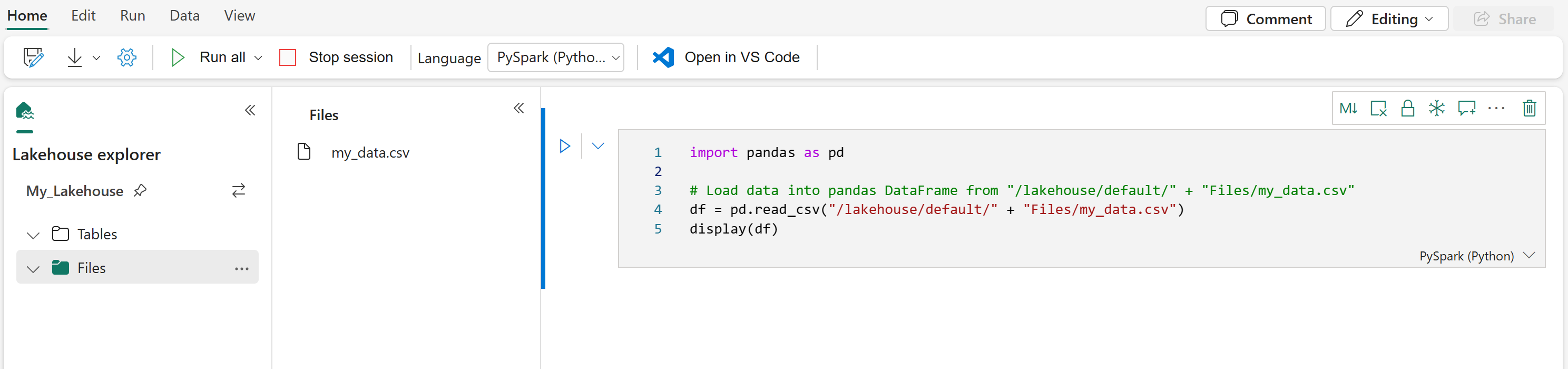

Une fois que vous avez attaché un Lakehouse à votre bloc-notes Microsoft Fabric, vous pouvez explorer les données stockées sans quitter la page et la lire dans votre bloc-notes en quelques étapes. La sélection d’un fichier Lakehouse affiche des options pour « Charger des données » dans un DataFrame Spark ou Pandas. Vous pouvez également copier le chemin ABFS complet du fichier ou un chemin d'accès relatif convivial.

La sélection de l’une des invites « Charger des données » génère une cellule de code qui charge le fichier dans un DataFrame dans votre notebook.

Conversion d'un DataFrame Spark en un DataFrame Pandas

Pour référence, cette commande montre comment convertir un DataFrame Spark en DataFrame Pandas :

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Lecture et écriture de divers formats de fichiers

Remarque

La modification de la version d’un package spécifique peut potentiellement interrompre d’autres packages qui en dépendent. Par exemple, la rétrogradation azure-storage-blob peut entraîner des problèmes avec Pandas et diverses autres bibliothèques qui s’appuient sur Pandas, y compris mssparkutils, fsspec_wrapperet notebookutils.

Vous pouvez afficher la liste des packages préinstallés et leurs versions pour chaque runtime ici.

Ces exemples de code illustrent les opérations Pandas pour lire et écrire différents formats de fichier. Ces exemples ne sont pas destinés à être exécutés séquentiellement comme dans un didacticiel, mais plutôt à copier et coller dans votre propre bloc-notes en fonction des besoins.

Remarque

Vous devez remplacer les chemins d'accès aux fichiers dans ces exemples de code. Pandas prend en charge les chemins relatifs, comme indiqué ici, et les chemins ABFS complets. Vous pouvez récupérer et copier des chemins d’accès d’un type à partir de l’interface à l’aide des étapes précédentes.

Lire les données d’un fichier CSV

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Écrire des données sous forme de fichier CSV

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Lire les données d'un fichier Parquet

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Écrire des données dans un fichier Parquet

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Lire les données d'un fichier Excel

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

# If the file is in a subfolder, add the correct file path after Files/

# For the default lakehouse attached to the notebook, use: df = pd.read_excel("/lakehouse/default/Files/FILENAME.xlsx")

df = pd.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Écrire des données sous forme de fichier Excel

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

Lire les données d'un fichier JSON

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Écrire des données sous forme de fichier JSON

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

Utilisation des tables Delta

Les tables delta sont le format de table par défaut dans Microsoft Fabric et sont stockées dans la section Tables de votre Lakehouse. Contrairement aux fichiers, les tables Delta nécessitent un processus en deux étapes pour travailler avec pandas : commencez par lire la table dans un DataFrame Spark, puis convertissez-la en dataFrame pandas.

Créer une table Delta de test

Pour suivre les étapes décrites dans cette section, vous avez besoin d’une table Delta dans votre Lakehouse. Suivez les étapes décrites dans Télécharger le jeu de données et charger sur lakehouse pour ajouter le fichier churn.csv à votre Lakehouse, puis créez une table de test à partir du fichier churn.csv en exécutant ce code dans votre bloc-notes :

import pandas as pd

# Create a test Delta table from the churn.csv file

df = pd.read_csv("/lakehouse/default/Files/churn/raw/churn.csv")

spark_df = spark.createDataFrame(df)

spark_df.write.format("delta").mode("overwrite").saveAsTable("churn_table")

Cela crée une table Delta nommée churn_table que vous pouvez utiliser pour tester les exemples ci-dessous.

Lire des données à partir d’une table Delta

# Read a Delta table from your Lakehouse into a pandas DataFrame

# This example uses the churn_table created above

spark_df = spark.read.format("delta").load("Tables/churn_table")

pandas_df = spark_df.toPandas()

display(pandas_df)

Vous pouvez également lire des tables Delta à l’aide de la syntaxe Spark SQL :

# Alternative method using Spark SQL

spark_df = spark.sql("SELECT * FROM churn_table")

pandas_df = spark_df.toPandas()

display(pandas_df)

Écrire un DataFrame pandas dans une table Delta

# Convert pandas DataFrame to Spark DataFrame, then save as Delta table

# Replace TABLE_NAME with your desired table name

spark_df = spark.createDataFrame(pandas_df)

spark_df.write.format("delta").mode("overwrite").saveAsTable("TABLE_NAME")

Vous pouvez également enregistrer dans un chemin spécifique dans la section Tables :

# Save to a specific path in the Tables section

spark_df = spark.createDataFrame(pandas_df)

spark_df.write.format("delta").mode("overwrite").save("Tables/TABLE_NAME")

Modes d’écriture pour les tables Delta

Lorsque vous écrivez dans des tables Delta, vous pouvez spécifier différents modes :

# Overwrite the entire table

spark_df.write.format("delta").mode("overwrite").saveAsTable("TABLE_NAME")

# Append new data to existing table

spark_df.write.format("delta").mode("append").saveAsTable("TABLE_NAME")

Remarque

Les tables delta créées dans la section Tables de votre Lakehouse sont détectables sans aucune inscription ou procédure de configuration supplémentaire, et peuvent être interrogées à l’aide de Spark SQL. Ils apparaissent également dans l’interface de l’explorateur Lakehouse (vous devrez peut-être actualiser l’explorateur Lakehouse pour voir les modifications récentes).

Contenu connexe

- Utilisez Data Wrangler pour nettoyer et préparer vos données

- Commencer à entraîner des modèles de ML