Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Les tests sont essentiels pour garantir que vos agents personnalisés dans Copilot Studio Kit répondent et se comportent comme prévu. Cet article explique comment créer, gérer et valider différents types de tests, notamment des scénarios à plusieurs tour, effectuer des opérations en bloc avec Excel et des jeux de tests en double.

Types de test

Vous pouvez créer plusieurs types de tests pour valider vos agents.

| Type de test | Descriptif |

|---|---|

| Correspondance de réponses | Ce test est le type de test le plus simple. Il compare la réponse de l’agent à la réponse attendue à l’aide de l’opérateur de comparaison sélectionné. Par défaut, la correspondance exacte (« égale ») est utilisée. Les autres opérateurs de comparaison disponibles sont « N'est pas égal à », « Contient », « Ne contient pas », « Commence par », « Ne commence pas par », « Se termine par » et « Ne se termine pas par ». |

| Pièces jointes (cartes adaptatives, etc.) | Compare la réponse JSON des pièces jointes de l’agent avec le JSON des pièces jointes attendues (tableau complet de pièces jointes). Par défaut, la correspondance exacte (« égale ») est utilisée. Les autres opérateurs de comparaison disponibles sont « Ne sont pas égaux », « Contains », « Ne contient pas ». Un opérateur de comparaison spécial appelé « Validation IA » utilise des modèles de langage pour valider la pièce jointe en fonction des instructions de validation fournies par le créateur, comme pour les réponses génératives. |

| Correspondance des rubriques |

Disponible uniquement lorsque l’enrichissement Dataverse (Enrichir avec les transcriptions de conversation) est configuré. Une fois l’étape d’enrichissement Dataverse terminée, ce test compare le nom de la rubrique attendue et le nom de la rubrique déclenchée. Les tests de correspondance des rubriques prennent également en charge la correspondance multi-rubriques avec des assistants personnalisés ayant l’orchestration générative activée. Dans la correspondance à plusieurs rubriques, les rubriques sont séparées par des virgules ; par exemple : « Topic1,Topic2 ». |

| Réponses génératives |

Disponible uniquement si l’enrichissement AI Builder (Analyser les réponses générées) est configuré. Utilise un modèle de langage volumineux pour évaluer si la réponse générée par l’IA est proche d’une réponse d’exemple ou respecte les instructions de validation. Lorsque l’enrichissement avec Azure Application Insights est configuré, des tests négatifs, tels que la modération ou aucun résultat de recherche, peuvent également être testés. |

| Multitours | Se compose d’un ou plusieurs cas de test d’autres types, tels que la correspondance de réponse, les pièces jointes, la correspondance de rubrique et les réponses génératives. Tous les tests enfants d’une série de tests multitours s’exécutent dans l’ordre spécifié au sein du même contexte de conversation. Utilisez des tests multitours pour tester un scénario de bout en bout et tester des agents personnalisés avec une orchestration générative. En savoir plus sur les tests à multiples étapes. |

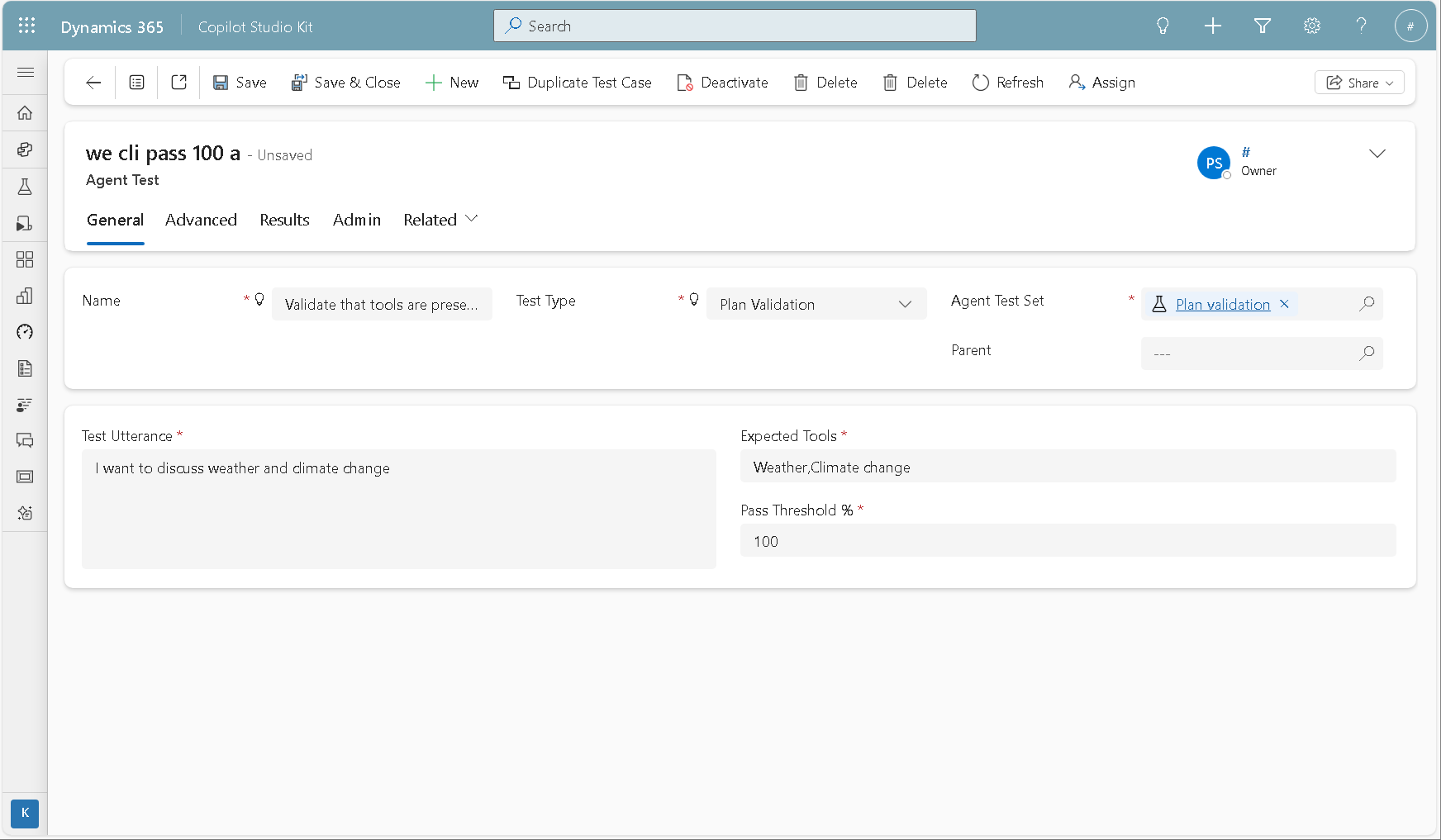

| Validation du Plan | Permet au créateur de valider que le plan dynamique de l’agent personnalisé inclut les outils attendus. Ce type de test est destiné aux agents personnalisés Copilot Studio qui ont activé l’orchestration générative. En savoir plus sur les tests de validation de plan. |

Créer un ensemble de test

Utilisez des jeux de tests pour regrouper plusieurs tests ensemble. Lorsque vous exécutez des tests, sélectionnez un ensemble de tests pour exécuter tous les tests de cet ensemble.

- Accédez à l’application Copilot Studio Kit.

- Accédez aux jeux de tests.

- Créez un enregistrement d’ensemble de tests d’assistant.

- Saisissez un Nom.

- Cliquez sur Enregistrer.

Créer un test

Après avoir créé un jeu de tests, vous pouvez y ajouter des tests. Dans le sous-réseau Tests, sélectionnez + Nouveau test de l’agent.

Le tableau suivant décrit les champs.

| Nom de colonne | Obligatoire | Descriptif |

|---|---|---|

| Nom | Oui | Nom du test. Ce nom peut être un ID de référence interne, tel que TST-001. |

| Jeu de test pour agent | Oui | Ensemble de tests parent pour le test. |

| Test Type | Oui | Un des types de test disponibles. |

| Envoyer un événement startConversation | Non | Si cette option est activée, l’agent reçoit l’événement startConversation afin qu’il démarre de manière proactive la conversation et que l’énoncé de test soit envoyé après. Ce paramètre est généralement requis lorsque la rubrique Démarrer de conversation inclut une logique qui doit s’exécuter avant de répondre à l’utilisateur ou à tester l’énoncé. |

| Position attendue du message de réponse | Non | Ne définissez pas de valeur si vous n’êtes pas sûr. Cette option vous permet de capturer une réponse d’agent spécifique lorsqu’elle envoie plusieurs messages. Par exemple, si l’agent dit d’abord « Hello », puis « Comment puis-je vous aider ? » et que vous souhaitez tester le deuxième message, définissez la valeur sur 1. L’ordre est basé sur 0, de sorte que le premier message est indexé en tant que 0, la deuxième réponse en tant que 1, et ainsi de suite. |

| Énoncé de test | Oui | Message que vous souhaitez envoyer à l’agent dans le cadre du test. |

| Réponse attendue | Dépend de | Obligatoire pour le type de test Response Match. Réponse attendue de l’agent. Pour un test Generative Answers, définissez un exemple de réponse ou vos propres instructions de validation pour le modèle de langage volumineux. |

| Variables externes JSON | Non | Enregistrement JSON pour toute valeur externe ou contextuelle que vous souhaitez transmettre à l’agent dans le cadre du test. Par exemple : { "Language": "fr" } |

| Secondes avant d’obtenir la réponse | Non | Nombre de secondes à attendre avant d’évaluer la réponse du bot. Dans la plupart des cas, vous pouvez laisser cette valeur vide, mais il est utile dans les situations où l’agent appelle une API et que la réponse peut prendre plus de temps que d’habitude. |

| Résultat des réponses génératives attendues | Dépend de | Obligatoire pour le type de test Generative Answers. Doit être soit répondu ou non répondu. Lorsque l’enrichissement d’Azure Application Insights est activé, vous pouvez choisir Modéré ou Aucun résultat de recherche. |

| Nom de la rubrique attendue | Dépend de | Obligatoire pour le type de test Topic Match. Nom de la rubrique que vous vous attendez à être déclenchée. La correspondance multi-rubriques est prise en charge pour les assistants personnalisés avec l’orchestration générative activée. Pour la correspondance multi-rubriques, utilisez une liste séparée par des virgules ; par exemple : « Topic1,Topic2 ». N’ajoutez pas d’espace blanc supplémentaire. La correspondance à plusieurs rubriques garantit que les rubriques attendues figurent parmi les rubriques du plan. |

| Pièces jointes prévues en JSON | Dépend de | Obligatoire pour le type de test concernant les pièces jointes (cartes adaptatives, etc.). Tableau JSON de pièces jointes complètes que vous attendez de la réponse de l’assistant. |

| Outils attendus | Dépend de | Obligatoire pour le type de test de validation du plan. Liste séparée par des virgules des outils attendus (outils, actions et agents connectés). N’ajoutez pas d’espace blanc supplémentaire. L’ordre n’est pas pertinent. Exemple : « Météo, Changement climatique » |

| Passer le seuil % | Dépend de | Obligatoire pour le type de test de validation du plan. Pourcentage d’outils attendus qui doivent figurer dans le plan dynamique pour que le test réussisse. Si le pourcentage est de 100, tous les outils attendus doivent être dans le plan dynamique pour que le test réussisse. Les outils supplémentaires du plan dynamique n’affectent pas le résultat du test. |

Tests en plusieurs étapes

Pour le type de test multitour, vous pouvez spécifier un ou plusieurs tests enfants de types standard. Chaque test enfant a un ordre et une criticité. L’ordre définit l’ordre d’exécution dans le même contexte de conversation (dans le cas de test à plusieurs tours). La criticité définit si l’incident de test enfant doit réussir pour que l’exécution du test multitour se poursuive.

Tous les tests enfants qui nécessitent une évaluation post-test, tels que la correspondance de rubrique ou les réponses génératives, sont laissés dans un état en attente et l’exécution des tests se poursuit indépendamment du statut de criticité. Si l’un des tests critiques échoue, l’exécution du test multitour est interrompue et son résultat est considéré comme ayant échoué. Si tous les incidents de test enfants critiques réussissent, le résultat du multitour est également réussi.

Utilisez des incidents de test enfants non critiques pour transmettre des informations à des assistants personnalisés avec une orchestration générative. Vous pouvez également utiliser ces cas de test lorsque la réponse n’a pas d’importance et que vous souhaitez effectuer des tests critiques.

Test de validation de plan

La validation de plan se concentre sur l’exactitude des outils. Au lieu d’évaluer ce que dit l’agent, ce type de test vérifie si les outils attendus ont été utilisés pendant le plan.

Lors de la définition d’un test de validation de plan, vous spécifiez :

- Énoncé de test

- Liste séparée par des virgules des outils attendus à inclure dans le plan dynamique

- Seuil de passage, qui représente la quantité d’écart à tolérer à partir de la liste

Ce test utilise des transcriptions de conversation et est évalué après l’exécution réelle du test en tant qu’activité d’enrichissement.

Notez ce qui suit :

Outils attendus : vous pouvez inclure des outils, des actions et des agents connectés dans la liste séparée par des virgules. Aucun espace blanc supplémentaire n’est autorisé, et l’ordre n’a pas d’importance.

Pass Threshold %: le seuil de réussite spécifie la partie requise des outils attendus qui doivent se trouver dans le plan dynamique pour que le test réussisse.

La validation de plan est un test déterministe : elle calcule l'écart entre les outils réels et les outils attendus, puis le compare au seuil de passage. Si l’écart se trouve dans le seuil, le test réussit ; sinon, elle échoue.

En savoir plus : Orchestrer le comportement de l’agent avec l’IA générative.

Utiliser Excel pour créer ou mettre à jour des tests en bloc

Après avoir créé un jeu de tests, vous pouvez utiliser Excel pour créer ou mettre à jour des tests en bloc.

- À partir de l’enregistrement de votre jeu de tests, basculez la vue de sous-grille depuis Tests vers Exportation/Importation.

- Sélectionnez Exporter des tests d’agent dans Excel Online.

- Ajoutez et modifiez des tests en fonction des besoins.

- Cliquez sur Enregistrer.

Si vous importez des tests enfants multitours, vous devez préalablement créer ou importer le test parent mulltitour. Ensuite, importez les cas de test enfants.

En savoir plus sur l’importation et l’exportation Excel dans les applications basées sur des modèles Power Apps.

Tests en double et jeux de tests

Vous pouvez dupliquer les jeux de tests et les tests individuels.

Pour dupliquer un cas de test unique, ouvrez l’enregistrement de test de l’agent et sélectionnez Cas de test dupliqué. Cette action est utile lorsque vous créez des variantes d’un cas de test, telles que la modification de l’emplacement, de l’heure ou de la quantité.

Pour dupliquer un jeu de tests entier, ouvrez l’enregistrement du jeu de tests et sélectionnez Dupliquer le jeu de tests dans la barre de commandes. Cette action crée une copie du jeu de tests et de tous ses tests enfants.