Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Le clustering de basculement Windows Server prend en charge plusieurs modèles d’architecture de stockage qui fournissent une haute disponibilité et une résilience pour les rôles en cluster. Cet article traite des architectures de stockage, notamment san, NAS, hyperconverged, espaces de stockage désagrégés direct et topologies mixtes.

Les architectures de stockage décrites ici reflètent la mise à l’échelle des composants de calcul et de stockage, ainsi que la façon dont les volumes partagés de cluster (CSV) ou les espaces de stockage direct (S2D) sont utilisés. Cet article ne décrit pas toutes les configurations d’architecture de stockage possibles ou les cas de périphérie rares.

Comparaison d’architecture

| Architecture | Emplacement du stockage | Caractéristiques de mise à l’échelle |

|---|---|---|

| Stockage SAN ou NAS | Stockage partagé externe (partages de fichiers SAN, NAS ou SMB 3.0) accessibles sur le réseau par un cluster de calcul. | Mise à l’échelle du calcul et du stockage indépendamment (ajoutez des nœuds de calcul sans ajouter de stockage ; la croissance du stockage est spécifique au fournisseur). |

| Hyperconverged | Disques locaux dans chaque nœud de cluster mis en pool par S2D ; données répliquées entre les nœuds ; Les CSV présentent un stockage uniforme. | Mise à l’échelle symétrique : chaque nœud ajoute simultanément des capacités de calcul et de stockage ; le cluster est pris en charge jusqu'au nombre maximal de nœuds documentés pour Storage Spaces Direct (S2D). |

| Hyperconverged avec stockage SAN | Pool S2D local (CSV ReFS) et volumes SAN externes (CSV NTFS) dans le même cluster ; les jeux de disques restent séparés. | Double mise à l’échelle : ajoutez des nœuds (calcul + stockage S2D) ou développez san indépendamment. |

| Espaces de stockage directs désagrégés | Un cluster de calcul distinct accède au stockage fourni par un cluster de stockage S2D distinct sur le réseau. | Mise à l’échelle du calcul et du stockage indépendamment (ajoutez uniquement des nœuds de calcul ou de cluster de stockage uniquement). |

| Prise en charge d’architectures mixtes | Combinaison d’un stockage SAN/NAS désagrégé et d’un stockage basé sur S2D consommé par le même cluster de calcul. | Flexible : mélangez des stratégies de mise à l’échelle indépendantes et symétriques par charge de travail. |

Toutes les architectures s’appuient sur les fonctionnalités de cluster (quorum, surveillance de l’intégrité, basculement) décrites dans la vue d’ensemble. Les détails de l’utilisation csv (synchronisation des métadonnées, E/S redirigées) sont disponibles dans la vue d’ensemble du fichier CSV. Pour connaître les considérations relatives au réseau SAN et au NAS (multipath, isolation), consultez la configuration matérielle requise pour le clustering. Le serveur de fichiers en mode Scale-Out et ses fonctionnalités actives-actives sont expliquées dans sa présentation.

Stockage SAN ou NAS

Le stockage SAN ou NAS désagrégé (y compris les partages SMB 3.0) place le stockage sur une structure distincte. Les nœuds de cluster accèdent au stockage sur le réseau. La mise à l’échelle du calcul et du stockage se fait indépendamment.

Les principales caractéristiques d’un modèle SAN ou NAS désagrégé sont les suivantes :

Prend en charge le basculement pour les machines virtuelles, le Serveur de fichiers Scale-Out, SQL Server (sur SMB) et d'autres applications en cluster.

La plateforme SAN ou NAS fournit la disponibilité et la résilience du stockage. Utilisez l’association d’E/S multipath ou de carte réseau pour éliminer les points de défaillance uniques (consultez la configuration matérielle requise).

Les partages SMB peuvent bénéficier des technologies SMB Multichannel et SMB Direct pour améliorer leur performance et leur résilience.

Mise à l’échelle indépendante : ajoutez le calcul (PROCESSEUR/RAM) sans stockage ou développez le stockage seul.

Les clusters prennent en charge jusqu’à 64 nœuds.

Avant de déployer ou de développer un cluster de basculement soutenu par SAN ou NAS, passez en revue les considérations de planification suivantes :

La mise à l’échelle et les performances sont spécifiques au fournisseur. Consultez les conseils de votre plateforme.

Maintenir la cohérence des microprogrammes et des pilotes pour les protocoles de bloc (Fibre Channel, iSCSI). Vérifiez la redondance du réseau pour SMB.

Isolez le trafic de stockage des chemins d’accès client et de gestion pour réduire la contention.

Planifiez la disponibilité et la redondance du chemin réseau pour qu’elles correspondent à la résilience de votre plateforme de stockage.

Appliquez des ACL de partage de fichiers afin que seuls les nœuds de cluster accèdent aux ressources partagées.

Choisissez ce modèle lorsque le cycle de vie ou la croissance du stockage diffère du calcul, ou lorsque le stockage partagé centralisé doit servir plusieurs clusters. La mise à l’échelle du cluster de stockage est spécifique au fournisseur. Contactez vos fournisseurs pour comprendre comment la solution de stockage qu'ils offrent peut évoluer.

Hyperconverged

Dans cette configuration hyperconvergée, Storage Spaces Direct regroupe les lecteurs locaux de chaque nœud de cluster dans un pool de stockage partagé, présente les volumes sous forme de volumes partagés de cluster (CSV), et réplique les données entre les nœuds de cluster pour garantir la fiabilité. La capacité de calcul (PROCESSEUR et RAM) et la capacité de stockage augmentent à mesure que vous ajoutez des nœuds de cluster.

Caractéristiques clés d’un modèle hyperconvergé :

Prend en charge les charges de travail en cluster telles que les machines virtuelles, les données d’application Scale-Out serveur de fichiers, les bases de données SQL Server (sur SMB et CSV) et les applications conteneurisées.

Le basculement du cluster permet aux machines virtuelles et à d’autres rôles en cluster de se déplacer ou de se redémarrer sur n’importe quel nœud du cluster.

Les périphériques NVMe, SSD et HDD locaux sont mis en pool, et les volumes sont exposés en tant que CSVs pour un espace de noms uniforme.

La résilience des données utilise la mise en miroir, la parité ou la résilience imbriquée, et les données sont répliquées sur d’autres nœuds. Pour plus d’informations sur la tolérance de panne pour l’espace de stockage direct, consultez Tolérance de panne et efficacité du stockage.

La mise à l’échelle symétrique, ce qui signifie que chaque nœud ajouté contribue à la fois au calcul et au stockage.

Les clusters prennent en charge entre 1 et 16 nœuds à l’aide d’espaces de stockage direct.

La mise en réseau est-ouest à faible latence et, lorsqu’elle est configurée, RDMA (RoCE ou iWARP) améliore le débit et réduit la surcharge du processeur.

Considérations relatives à la planification avant de déployer ou de développer des clusters hyperconvergés :

Gardez les versions du microprogramme et du pilote cohérentes entre les cartes de stockage et les lecteurs.

Validez la configuration réseau (QoS, priorité RDMA et contrôle de flux) pour éviter la congestion et garantir une latence prévisible.

Dimensionner les niveaux de cache et de capacité (NVMe, SSD et HDD) à l’aide de conseils publiés pour maintenir les ratios recommandés pour les performances.

Réservez la capacité de reconstruction afin que le cluster puisse tolérer en toute sécurité les défaillances de lecteur ou de nœud et éviter de fonctionner avec une utilisation proche de 100 %.

Surveillez proactivement l’état de santé du disque, du boîtier et de la réplication.

Espaces de stockage directs désagrégés

Les espaces de stockage désagrégés séparent directement le calcul et le stockage en clusters distincts. Un cluster de calcul (exécutant des charges de travail telles que des machines virtuelles, des rôles serveur de fichiers Scale-Out, des bases de données SQL Server ou des applications conteneurisées) accède au stockage fourni par un cluster direct d’espaces de stockage distinct sur SMB 3.0.

Principales caractéristiques d’une architecture désagrégée des espaces de stockage direct :

Mise à l’échelle indépendante : ajoutez uniquement des nœuds de calcul pour plus de ressources processeur et RAM ou ajoutez uniquement des nœuds de stockage pour la capacité et les performances. Les taux de croissance peuvent différer.

Prend en charge les mêmes charges de travail en cluster que les modèles hyperconvergés lorsqu’elles sont exposées via des partages SMB ou CSV.

Le cluster de stockage utilise la mise en miroir, la parité ou la résilience imbriquée et les données sont répliquées sur d’autres nœuds. Pour en savoir plus sur la tolérance de panne pour l’espace de stockage direct, consultez Tolérance de panne et efficacité du stockage.

Isolation de maintenance : vous pouvez corriger ou redémarrer des nœuds de stockage séparément des nœuds de calcul.

Plusieurs clusters de calcul peuvent consommer des partages à partir d’un cluster de stockage (sous réserve de la capacité et de la planification des performances).

Les clusters de calcul prennent en charge entre 1 et 64 nœuds.

Les clusters de stockage prennent en charge entre 1 et 16 nœuds.

Nécessite une mise en réseau est-ouest fiable à faible latence (éventuellement RDMA) entre les clusters pour des performances prévisibles.

Considérations relatives à la planification avant de déployer ou de développer des espaces de stockage désagrégés direct :

Aligner les cadences de mise à jour du microprogramme, des pilotes et du système d’exploitation sur les nœuds de stockage. Évitez les versions de pilotes mixtes.

Validez la configuration réseau (QoS, priorité RDMA et contrôle de flux) pour éviter la congestion et garantir une latence prévisible.

Prévoyez une croissance divergente (PROCESSEUR, RAM, capacité et IOPS) et définissez des seuils pour quand mettre à l’échelle chaque cluster indépendamment.

Appliquez l’accès avec privilèges minimum. Limitez l’accès administratif entre les clusters de calcul et de stockage, à l’aide de listes de contrôle d’accès de partage de fichiers aux nœuds de cluster requis.

Surveillez l’intégrité du lecteur, du boîtier et de la réplication de manière proactive dans le cluster de stockage afin que le calcul indépendant ne soit pas affecté par la disponibilité du stockage.

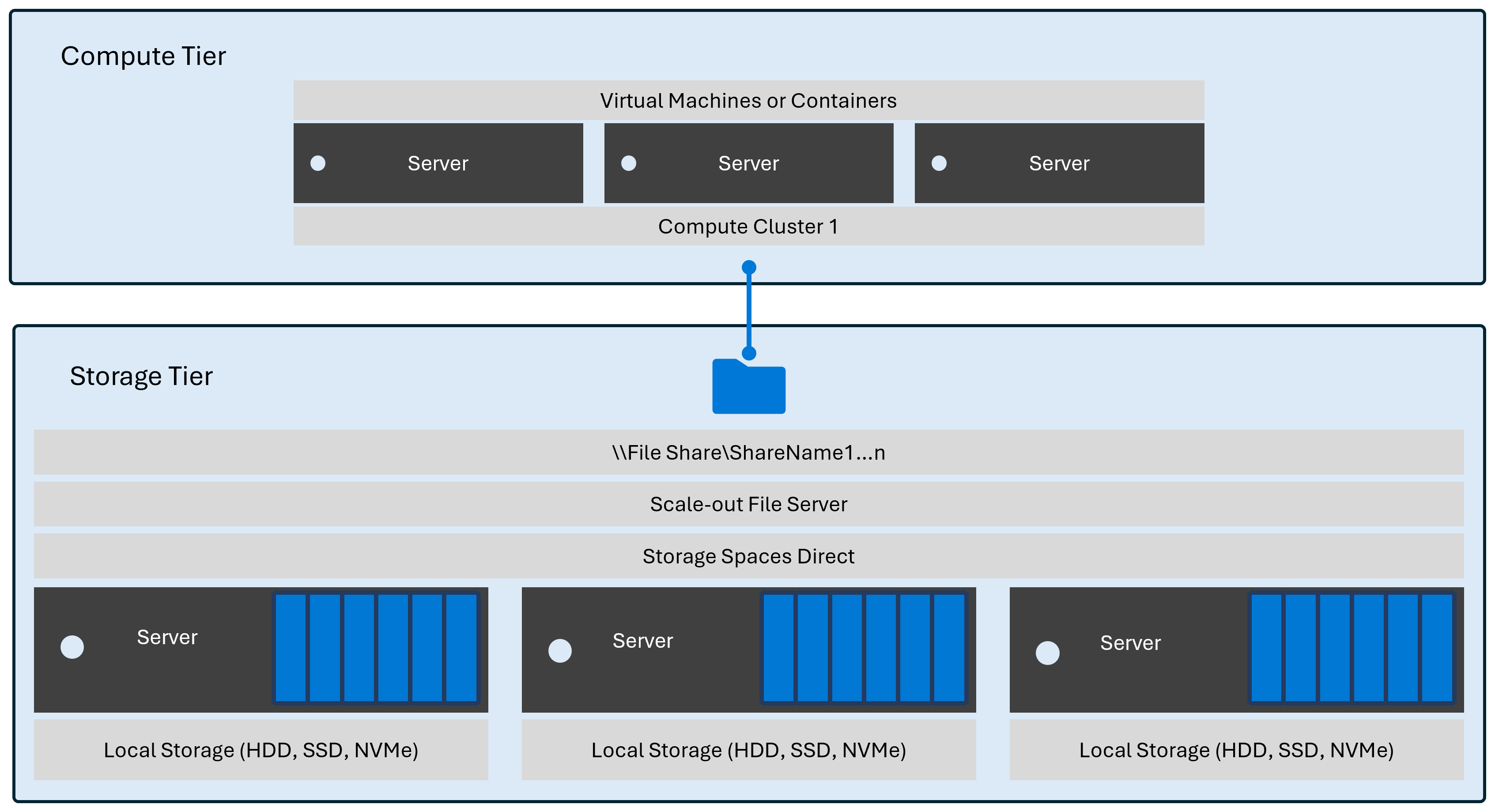

Le diagramme suivant montre un déploiement désagrégé avec un cluster de calcul et un cluster de stockage.

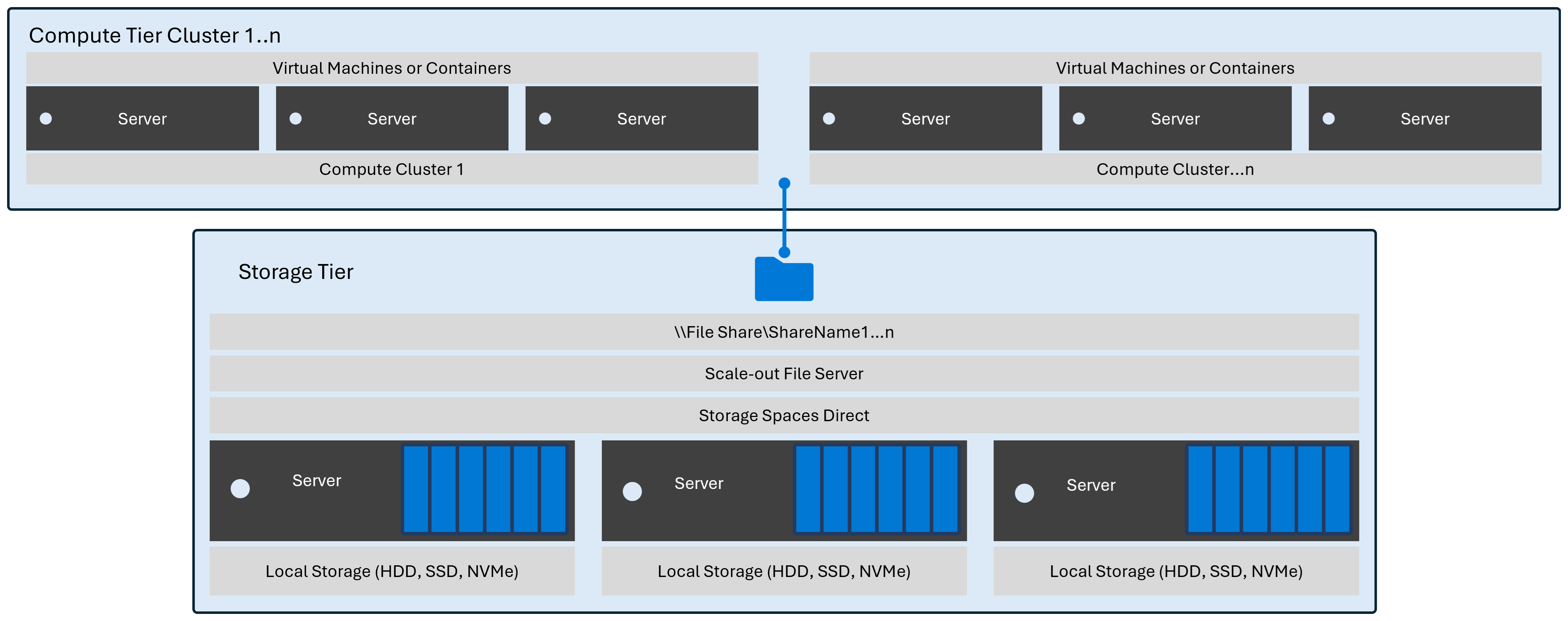

Lorsque vous ajoutez d’autres ressources de calcul, vous pouvez ajouter un nouveau nœud au cluster de calcul existant ou ajouter un nouveau cluster. Le diagramme suivant montre ce qui se passe pour le déploiement simple si vous ajoutez un nouveau cluster à celui-ci sans ajouter plus de stockage.

Lorsque vous ajoutez d’autres ressources de stockage pour l’hébergement de données sans ajouter de ressources de calcul supplémentaires, vous pouvez ajouter un nouveau nœud au cluster de stockage existant ou ajouter un nouveau cluster. Le diagramme suivant montre à quoi ressemble le déploiement simple lorsque vous ajoutez un nouveau cluster sans ajouter de ressources de calcul telles que l’UC ou la RAM.

Hyperconverged avec stockage SAN

À compter de Windows Server 2022, vous pouvez intégrer Storage Spaces Direct hyperconvergé avec du stockage SAN externe dans le même cluster de basculement. Cette architecture combine un cluster Storage Spaces Direct hyperconvergé (disques locaux mis en pool et exposés en tant que CSV soutenus par ReFS) avec un stockage SAN externe présenté au même cluster et ajouté en tant que CSV soutenus par NTFS. Les deux sources de stockage coexistent, mais restent séparées.

Caractéristiques clés d’un modèle combiné hyperconvergé et SAN :

Coexistence : les CSV S2D et les CSV SAN fonctionnent parallèlement dans le même cluster de basculement.

Séparation stricte : les disques SAN ne doivent jamais être ajoutés au pool d’espaces de stockage direct et sont gérés indépendamment.

Configuration requise pour la mise en forme :

Mettez en forme les volumes SAN comme NTFS avant de les convertir en volumes partagés de cluster.

Formatez les volumes de Storage Spaces Direct en tant que ReFS avant de les convertir en volumes partagés de cluster.

La connectivité SAN prise en charge inclut Fibre Channel, iSCSI et cible iSCSI.

Flexibilité du placement des charges de travail : placez les charges de travail sensibles à la latence ou optimisées pour ReFS (telles que les grands ensembles VHDX ou les couches de conteneur) sur les volumes S2D. Placez des charges de travail nécessitant des fonctionnalités NTFS spécifiques ou des outils de gestion SAN existants sur des volumes SAN.

Extension de capacité indépendante : ajoutez des nœuds hyperconvergés (ajoute le calcul et le stockage) ou développez la capacité SAN (ajoute uniquement le stockage) sans affecter l’autre.

Les domaines d’erreur restent distincts : S2D gère les défaillances de lecteur et de nœud via des jeux de résilience. SAN gère la disponibilité par le biais de son propre contrôleur, de sa structure ou de sa conception multipathe.

Les Clusters Storage Spaces Direct prennent en charge entre 1 et 16 nœuds.

Considérations relatives à la planification avant de déployer ou de développer une architecture hyperconvergée combinée plus SAN :

La mise à l’échelle et les performances SAN sont spécifiques au fournisseur : consultez les conseils de plateforme.

N’essayez pas d’ajouter des disques fournis par SAN dans des pools de stockage S2D.

Conservez des versions cohérentes du microprogramme et du pilote pour les sous-systèmes de stockage (adaptateurs S2D et cartes réseau SAN).

Établissez des directives pour le placement des charges de travail (par exemple, pour une évaluation de haute intensité ou une déduplication) et documentez le type de CSV à utiliser.

Surveillez séparément les tendances de capacité : utilisation du pool S2D par rapport à l’utilisation du réseau SAN pour prévoir les mises à niveau.

Aligner les stratégies de sauvegarde et de récupération d’urgence ; Les captures instantanées SAN et les sauvegardes de volume basées sur S2D peuvent suivre différentes planifications et outils.

Vérifier l’isolation des performances ; les E/S SAN intensives ne doivent pas congestionner le trafic de réplication S2D est-ouest.

Vous devez planifier la disponibilité et la redondance des chemins d’accès réseau et SAN pour garantir qu'elles répondent aux besoins de disponibilité de chaque plateforme de stockage.

Prise en charge d’architectures mixtes

Hyper-V prend en charge la combinaison des architectures suivantes dans le même cluster de calcul :

Hyper-V avec Storage Spaces Direct désagrégé

Hyper-V désagrégé avec SAN

Hyper-V désagrégé avec NAS

Le diagramme suivant illustre un exemple de déploiement avec un cluster de calcul contenant une combinaison de stockage SAN désagrégé et NAS.

Protocoles de stockage réseau

Windows Server prend en charge les protocoles de stockage de fichiers réseau suivants :

Windows Server prend également en charge les protocoles de stockage de blocs réseau suivants :

iSCSI

Fibre Channel

InfiniBand

Note

Les spécificités de configuration déterminent finalement si votre déploiement prend en charge ces protocoles. Par exemple, les déploiements qui utilisent le commutateur virtuel Hyper-V ne prennent pas en charge InfiniBand. Toutefois, ils peuvent prendre en charge les appareils InfiniBand lorsqu’ils ne sont pas liés au commutateur virtuel.

Microsoft fournit également un initiateur iSCSI basé sur logiciel intégré pour le stockage de blocs réseau.

Vous pouvez également utiliser un client fournisseur de stockage pour n’importe quel appareil disponible dans le catalogue Windows Server.