この記事では、AI アプリとそれらがやり取りするデータを保護するための機能の使用方法について説明します。

- ユーザー プロンプトと AI 生成データにおける機密データを保護

- プロンプト インジェクションのような新たな脅威からの防御

これは、シリーズの 3 番目の記事です。 「AI セキュリティの準備」と「AI アプリとデータの検出」のタスクを完了していない場合は、これらの記事から始めて、本記事で説明されている機能を導入する準備をしてください。

本記事は、このリソースと併せてご利用ください:

- AI のためのクラウド導入フレームワーク (CAF) — AI を保護するプロセス

Microsoft は、AI アプリとデータを保護する幅広い機能を提供しています。 本記事では、データ保護と脅威に対する保護の 2 つのカテゴリに分けて説明します。

次の 2 つの表では、この図を説明するとともに、これらの機能の実装手順を順を追って説明します。

表 1 - データ保護機能

| ステップ | タスク | Scope |

|---|---|---|

| 1 | SharePoint のオーバーシェアリング制御を適用して、AI アプリの対象範囲から機密性の高いサイトやデータを素早く除外します。 | Microsoft 365 環境内のサイトとファイル。 |

| 2 | データ セキュリティ態勢管理 (DSPM) を使用して、オーバーシェアリングがどこで行われているかを AI に学習させ、機密性ラベルや DLP ポリシーに対する適用範囲のギャップを見つけます。 |

サポートされている AI サイトを含む、サードパーティの大きな言語モジュール (LLM) を使用する副操縦士、エージェント、その他の AI アプリ。 Purview SDK を使用した他のクラウド プロバイダーの AI アプリ。 |

| 3 | 機密ラベルとデータ損失防止 (DLP) ポリシーの改善を継続します。 | Microsoft 365 環境内のサイト、ファイル、デバイス。 Defender for Cloud Apps と統合されている場合の SaaS アプリ。 Purview SDK を使用した Azure および他のクラウド プロバイダーの AI アプリ。 |

| 4 | インサイダー リスク管理 (IRM) 内で、AI アプリにおけるリスクのある行動を特定するために、リスクのある AI 使用向けテンプレートを適用します。 | 生成的なAIウェブサイト。 Microsoft 365 Copilot、Microsoft Copilot、Copilot Studio、Azure AI サービス。 Purview SDK を使用した他のクラウド プロバイダーの AI アプリ。 |

| 5 | インサイダー リスク管理のために適応型保護を構成し、ユーザーのリスクに応じてデータ保護を強化する | Microsoft 365 環境内のサイト、ファイル、デバイス。 |

表 2 - 脅威保護機能

| ステップ | タスク | Scope |

|---|---|---|

| 1 | Defender for Cloud アプリを使用すると、新しい AI アプリが使用された際にアラートを表示したり、AI アプリのリスク スコアを計算したり、環境内のこれらのアプリを許可またはブロックしたりすることができます。 Defender for Cloud アプリは、Microsoft 365 Copilot に追加の保護機能を提供します。 | SaaS AI アプリ |

| 2 | Defender for Cloud Microsoft Defender for Cloud を使用して、環境内に展開された AI ワークロードを発見し、セキュリティに関する分析情報を得る |

Azure AI ベースのカスタム ビルド AI アプリケーション |

AI データの保護

これらの機能により、データのオーバーシェアリング、機密データの使用、ユーザーの危険な行動に関連する主なリスクについて効率的に学習し、リスクを軽減することができます。 これらの機能は、貴社の環境における AI アプリとデータの保護に限定されています。

手順 1 - SharePoint のオーバーシェア コントロールを適用する

SharePoin のオーバーシェアリング制御には、対象範囲を限定したアクセス背許可など、SharePoint に組み込まれた制御や、Microsoft Copilot の展開においてコンテンツ ガバナンスを強化する SharePoint 詳細管理のアドオン機能が含まれます。 SharePoint のオーバーシェアリング制御は以下のように役立ちます:

- Copilot の検索を一時的に、指定したサイトの一覧のみに限定する (SharePoint 検索の制限)。

- オーバーシェアリング データや機密性の高いコンテンツを含む可能性のあるサイトを迅速に特定する (データ アクセス ガバナンス レポート)。

- ユーザーが Copilot または組織全体の検索でサイトを見つけられないように、サイトにフラグを付ける (SharePoint 詳細管理のコンテンツ検出の制限)。

- 非アクティブ サイト ポリシーを作成し、非アクティブ サイトを自動的に管理および削減する (SharePoint 詳細管理)。

- SharePoint と OneDrive のサイトへのアクセスを特定のグループのユーザーに制限する (SharePoint の詳細管理でアクセス制御ポリシーを制限)。

次のリソースを使用して、オーバーシェアリング制御を開始します。

| タスク | 推奨リソース |

|---|---|

| Microsoft 365 Copilot で使用できるオーバーシェアリング制御の図解と説明の確認 | Microsoft 365 Copilot におけるデータ保護と監査アーキテクチャ |

| オーバーシェアリングを防ぐためのダウンロード可能なブループリント | オーバーシェアリング用 Microsoft 365 Copilot ブループリント |

| SharePoint の詳細管理について学習する | Microsoft SharePoint プレミアム - SharePoint 詳細管理の概要 |

手順 2- AI 用の DSPM を使用してデータを保護する

DSPM を使用して、オーバーシェアリングがどこで行われているかを AI に学習させ、機密ラベルや DLP ポリシーに対する適用範囲のギャップを見つけます。

まずは、その週のアセスメント レポートから始めるのが良いでしょう。

各レポートを詳細に確認することで、オーバーシェアリング制御、ラベル、DLP ポリシーにどのようなギャップがあるかを把握し、これらの問題を迅速に修正できます。

各レポートごとに、AI 対応の DSPM がデータ セキュリティを改善するための推奨事項を提示します。 [すべての推奨事項を表示] リンク、またはナビゲーション ペインの [推奨事項] を使用して、テナントに対して利用可能なすべての推奨事項とそのステータスを確認できます。

AI 対応 DSPM で AI アプリとデータを保護するには、以下のリソースをご利用ください。

| タスク | 推奨リソース |

|---|---|

| AI の DSPM についての詳細 | AI 対応 DSPM の使用方法 |

| 前提条件と、ワンクリック ポリシーと既定のポリシーのしくみについて説明します | AI 用の DSPM に関する考慮事項 |

| 他のクラウド プロバイダーの AI アプリの場合は、Purview SDK を使用して、AI 用 DSPM との統合をテストする方法について説明します | Purview SDK と統合された AI アプリケーションをテストする方法 |

手順 3—機密ラベルと DLP ポリシーのギャップを継続的に特定する

「AI セキュリティの準備」では、Microsoft Purview のデータ セキュリティ態勢管理ツールである DSPM と AI 対応 DSPM を使用して、機密データの保護に優先順位を付けました。 これらのツールを継続的に見直し、ポリシー適用範囲のギャップを特定するとともに、機密ラベルと DLP ポリシーの適用に今後も投資が必要な領域を特定してください。 また、Defender for Cloud アプリを使用することで、機密ラベルと DLP ポリシーを SaaS アプリに拡張できます。

Microsoft Purview を使いこなすには、以下のリソースをご活用ください。

| タスク | 推奨リソース |

|---|---|

| 情報保護のための推奨展開戦略を学ぶ | Microsoft Purview を使用して情報保護ソリューションを展開する |

| Defender for Cloud アプリを使用して、機密ラベルと DLP ポリシーを SaaS アプリに拡張する | SaaS アプリの情報保護を展開する |

| 組織のデータを保護するための機密ラベルとポリシーを定義する |

機密ラベルの使用を開始する 機密ラベルとそのポリシーの作成と構成 秘密度ラベルを使用してコンテンツへのアクセスを制限し、暗号化を適用する |

| Microsoft 365 のアプリとサービスのためのデータのラベル付けと保護 |

Office アプリ内での機密ラベルの管理 SharePoint および OneDrive ファイルの機密ラベルを有効化する |

| DLP ポリシーの調整 | データ損失防止 (DLP) ポリシーを作成して展開する |

| Azure または他のクラウド プロバイダーで開発された AI アプリの場合は、Purview SDK を使用して秘密度ラベルと DLP ポリシーを適用する方法について説明します |

Purview SDK とは Microsoft Graph Purview API の使用 Purview SDK と統合された AI アプリケーションをテストする方法 |

手順 4—インサイダー リスク管理 (IRM) において、リスクのある AI 使用に対応するテンプレートを適用する

Microsoft Purview インサイダー リスク管理 (IRM) には、リスクのある AI 使用など、貴社の環境に適用できる定義済みのポリシー テンプレートが含まれています。 IRM テンプレートは、ポリシーで使用されるリスク指標の種類とリスク スコアリング モデルを設定する、定義済みのポリシー条件です。

危険な AI の使用ポリシーは、組織内の AI ツール全体でプロンプトと応答のリスク スコアリングを検出して有効にするのに役立ちます。 IRM は、AI に関連するリスク活動の調査と対策を支援します。

インサイダー リスク管理を開始し、リスクのある AI 使用ポリシー テンプレートを適用するには、以下のリソースを使用してください。

| タスク | 推奨リソース |

|---|---|

| インサイダー リスク管理を開始し、組織に有益なトップ シナリオを学ぶ | インサイダー リスク管理の詳細 |

| リスクのある AI 使用向けのテンプレートを適用する | インサイダー リスク管理ポリシー テンプレートの詳細|Microsoft Learn |

| AI の主なシナリオについて学び、レポートの例を見る | インサイダー リスク管理は、リスクのある AI の使用状況を可視化し、セキュリティ調査を強化する。 |

| Purview SDK で開発された AI アプリの場合は、Insider Risk Management の統合をテストします | Purview SDK と統合された AI アプリケーションをテストする方法 |

手順 5—インサイダー リスク管理のための適応型保護の構成

Microsoft Purview インサイダーリスク管理の適応型保護では、ユーザーに対してリスク レベルが動的に割り当てられ、作成したポリシーは、リスクが中程度または高リスクのユーザーに適用されます。 ポリシーは、データ損失防止アクションの強化、削除されたコンテンツの保存、より高い条件付きアクセス要件の強制などを行うことができます。

次のリソースを使用して、適応型保護の使用を開始します。

| タスク | 推奨リソース |

|---|---|

| インサイダー リスク管理を開始し、組織に有益なトップ シナリオを学ぶ | インサイダー リスク管理の詳細 |

| AI の主なシナリオについて学び、レポートの例を見る | インサイダー リスク管理は、リスクのある AI の使用状況を可視化し、セキュリティ調査を強化する。 |

| リスクのある AI 使用向けのテンプレートを適用する | インサイダー リスク管理ポリシーのテンプレートについて学ぶ |

| インサイダー リスク活動の調査とそれへの対応 |

インサイダー リスク管理活動を調査する インサイダー リスク管理事例に対処する |

AI の脅威保護を最大限に活用する

Defender for Cloud アプリと Defender for Cloud には、新しい AI アプリの使用状況を常に把握できるようにし、適切なコントロールを適用する機能が含まれています。

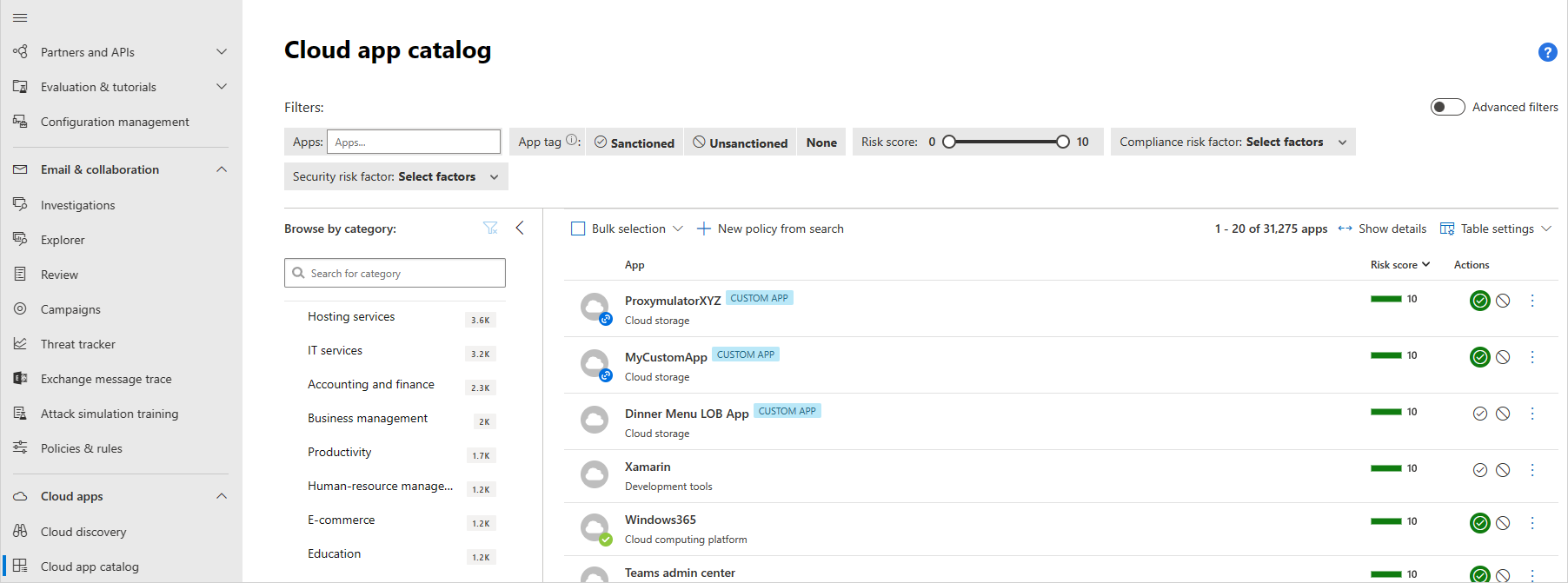

手順 1—Defender for Cloud アプリを使用して、AI アプリの使用を分類・評価し、保護する。

このシリーズの前回の記事「AI アプリとデータの検出」では、Defender for Cloud アプリを使用して環境内の AI アプリを検出することに焦点を当てていました。 この記事では、Defender for Cloud アプリを活用し、新しい AI アプリの使用を把握・管理することを推奨しています。そのために、アプリが環境にもたらすリスクを評価し、アプリを承認またはブロックし、アプリにセッション制御を適用するといった対策を講じることが推奨されています。

まず、新しい生成 AI アプリが組織で使用される際に、自動的にアラートをトリガーするポリシーを作成します。

次に、新たに検出されたアプリのリスク スコアを評価します。 リスク スコアをカスタマイズすることも可能です。 たとえば、規制の厳しい組織では、リスク スコアにおける特定の属性の重みを調整したいと考える場合があります。 リスク スコアを上書きすることも可能です。

各アプリを承認するか、ブロックするかを決定します。 組織は様々な理由で、アプリの使用のブロックを選択する場合があります。 機密データが知らず知らずのうちにアプリケーションと共有され、後に組織外の聴衆に公開されることを懸念する声もあります。 そのため、組織は管理されていないすべての AI アプリの使用をブロックする可能性があります。 一方、SOC2 や HIPAA といった異なる基準に準拠していることを、使用中のすべてのアプリについて確認する必要がある組織も存在します。

最後に、承認済のアプリに対して、制御と可視性を強化する目的でセッション ポリシーを適用するかどうかを決定します。 セッション ポリシーを使用すると、組織におけるクラウド アプリの使用方法に対してパラメータを設定できます。 たとえば、AI アプリへのアクセスをマネージド デバイスのみに許可するセッション ポリシーを構成できます。 より単純な例としては、アンマネージド デバイスのトラフィックを監視するポリシーを構成し、そのリスクを分析した上で、より厳格なポリシーを適用することができます。

この図では:

- 組織内のユーザーやデバイスから承認されたクラウド アプリへのアクセスは、セッション ポリシーを特定のアプリに適用できる Defender for Cloud アプリを通じてルーティングされます。

- 承認していない、または明示的に承認されていないクラウド アプリは影響を受けません。

Defender for Cloud アプリはさらに、Microsoft 365 Copilot 専用の検出機能を提供します。 セキュリティ チームは、ユーザーの Copilot との不審なやり取りを検出し、脅威に対応し、それを緩和することができます。 たとえば、ユーザーが危険な IP アドレスから Copilot 経由で機密データにアクセスした場合、Defender for Cloud アプリはアラートをトリガーして、この疑わしいアクティビティにフラグを付け、MITRE の攻撃手法、IP アドレス、セキュリティ チームがこのアラートをさらに調査するために使用できるその他のフィールドなどの重要な詳細を表示します。

次のステップとして、以下のリソースをご活用ください。

| タスク | 推奨リソース |

|---|---|

| この Defender for Cloud アプリ導入フローの手順 5 ~ 8 を確認してください。 | クラウド アプリの検出と管理 |

| アプリの管理に関するビデオ チュートリアルを確認する | Defender for Cloud アプリを使用して、貴社の環境で使用されている生成 AI アプリを検出しましょう - YouTube |

| アプリ検出ポリシーを作成する | クラウド検出ポリシーの作成 |

| 新たに検出されたアプリのリスク スコアを評価します。 | クラウド アプリ カタログとリスク スコア |

| 新しいアプリを承認またはブロックする | 検出されたアプリの管理 |

| AI アプリの制御と可視性を向上させるためにセッション ポリシーを適用する | セッション ポリシーの作成 |

| Microsoft 365 Copilot の脅威保護の使用方法について説明します。 | Microsoft Copilot for Microsoft 365 向けの新しい脅威検出 |

手順 2—Defender for Cloud でAI 保護を適用する

このシリーズの前回の記事、「AI アプリとデータの検出」では、貴社の環境内で実行されている生成 AI のワークロードとモデルの検出に焦点を当てていました。 本記事では、カスタム AI アプリを構築して使用する際の、アプリケーション ライフサイクル全体を通しての生成 AI アプリケーションの保護に焦点を当てます。

組織は新しい生成 AI アプリケーションの開発や、既存のアプリケーションに AI を組み込むことによって、ビジネスの効率と生産性を高める選択をしています。 攻撃者は、プロンプト インジェクション、ウォレット攻撃、モデルの窃盗、データ ポイズニングといった新たな攻撃によって、AI モデルの設計目的を変更し、アプリケーションを悪用しようとする傾向を強めています。同時に、データ侵害やサービス拒否といった既知のリスクに対する脆弱性も高まっています。 セキュリティ チームは、新たな脅威の状況に対応した AI アプリケーションと検知のための適切なセキュリティ管理を確実に整え、準備する必要があります。

Microsoft Defender for Cloud は、コードからクラウドまで、ハイブリッド環境やマルチクラウド環境のセキュリティ確保を支援します。 Defender for cloud は、企業が構築した生成 AI アプリケーションをアプリケーション ライフサイクル全体を通して保護することができるセキュリティ態勢と脅威保護機能を備えています。

- コードからクラウドに至るまで、生成 AI アプリケーション コンポーネントと AI アーティファクトを継続的に検出します。

- セキュリティ態勢を強化するための推奨事項が組み込まれた生成 AI アプリケーションのリスクを調査し、是正します。

- 攻撃パス分析を使用して、生成 AI アプリケーションの有害な組み合わせを特定し、修復します。

- Azure AI Content Safety のプロンプト シールド、Microsoft の脅威インテリジェンス シグナル、およびコンテキストに基づくアクティビティ モニタリングを活用して強化された生成 AI アプリケーションを対象に、リスクのあるアクティビティを検出します。

- Microsoft Defender との組み込み統合により、生成 AI アプリへの攻撃を検出・調査できます。

Defender クラウド セキュリティ態勢管理 (CSPM) の AI セキュリティ態勢管理機能から始めましょう。 Defender CSPM は、Azure OpenAI Service、Azure Machine Learning、Amazon Bedrock などの AI サービス全体で使用されている AI モデル、SDK、テクノロジの存在と構成について、エージェントレスできめ細かく可視化することで、展開された AI ワークロードを自動的かつ継続的に検出します。

CSPMは、状況に即したセキュリティ問題を継続的に明らかにし、AI ワークロード全体でクリティカルなギャップに優先順位を付けるよう調整された、リスクベースのセキュリティ推奨事項を提示します。 関連するセキュリティ推奨事項は、Azure ポータルの Azure OpenAI リソース自体にも表示されるため、開発者やワークロード所有者は推奨事項に直接アクセスすることができ、迅速な修復が可能になります。

攻撃経路分析機能は、AI ワークロードに対する高度なリスクを特定できます。たとえば、基盤データや微調整用データが横方向の移動によってインターネットにさらされ、データ ポイズニングの影響を受けやすくなるといったデータ セキュリティシナリオを検出することも可能です。

次に、AI ワークロードのための脅威保護で実行時の安全性を維持します。 Defender for Cloud には、AI ワークロード用の脅威保護が含まれています。 AI 向けの脅威保護は、ネイティブ統合の Azure OpenAI Service、Azure AI Content Safety プロンプト シールド、Microsoft 脅威インテリジェンスを使用して、状況に即した実用的なセキュリティ アラートを提供します。 AI ワークロードのための脅威保護により、セキュリティ チームは、直接的および間接的なプロンプト インジェクション攻撃、機密データの漏えい、データ ポイズニング、ウォレットの不正使用やサービス拒否攻撃に関連する悪意のあるアクティビティについて、Azure OpenAI 搭載アプリケーションを実行中に監視することができます。

次のステップのために、以下のリソースをご活用ください。

| タスク | 推奨リソース |

|---|---|

| このブログで紹介したトップ シナリオを見直す | Microsoft Defender for Cloud で生成 AI アプリケーションを保護する |

| CSPM を使用して環境内の AI リスクを可視化する |

Defender CSPM を使用してリソースを保護する データと AI のセキュリティ ダッシュボードを確認する (プレビュー) |

| AI ワークロードへの脅威に対する保護を有効にする (プレビュー) | AI ワークロードへの脅威に対する保護を有効にする (プレビュー) AI ワークロードのためのアラート (プレビュー) |

AI 保護のための次のステップ

組織内で AI アプリとデータを保護したら、次のステップは、規制コンプライアンス要件を満たすために AI アプリを管理することです。

- 規制に対するコンプライアンス態勢を評価し、強化します。

- AI アプリとデータの使用を管理するためのコントロールを導入します。

このシリーズの次の記事をご覧ください: コンプライアンスを確保しながら AI を適切に管理するには?

![Microsoft Defenderの [アプリ検出ポリシーの作成] ページを示すスクリーンショット。](media/create-app-discovery-policy.png)