Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Funkcja ai.embed używa generatywnej sztucznej inteligencji do przekształcania tekstu w wektorowe osadzenia. Te wektory umożliwiają sztucznej inteligencji zrozumienie relacji między tekstami, dzięki czemu można wyszukiwać, grupować i porównywać zawartość na podstawie znaczenia, a nie dokładnego sformułowania. Za pomocą pojedynczego wiersza kodu można wygenerować wektorowe osadzania z kolumny w ramce danych.

Uwaga / Notatka

- W tym artykule opisano używanie ai.embed z PySpark. Aby użyć pliku ai.embed z biblioteką pandas, zobacz ten artykuł.

- Zobacz inne funkcje sztucznej inteligencji w tym artykule przeglądu.

- Dowiedz się, jak dostosować konfigurację funkcji sztucznej inteligencji.

Przegląd

Funkcja ai.embed jest dostępna dla ramek danych platformy Spark. Musisz określić nazwę istniejącej kolumny wejściowej jako parametr.

Funkcja zwraca nową ramkę danych zawierającą osadzanie dla każdego wiersza tekstu wejściowego w kolumnie wyjściowej.

Składnia

df.ai.embed(input_col="col1", output_col="embed")

Parametry

| Name | Description |

|---|---|

input_col Required |

Ciąg zawierający nazwę istniejącej kolumny z wartościami tekstowymi wejściowymi do użycia na potrzeby osadzania danych obliczeniowych. |

output_col Opcjonalnie |

Ciąg zawierający nazwę nowej kolumny do przechowywania osadzonych elementów obliczeniowych dla każdego wiersza tekstu wejściowego. Jeśli nie ustawisz tego parametru, domyślna nazwa zostanie wygenerowana dla kolumny wyjściowej. |

error_col Opcjonalnie |

Ciąg zawierający nazwę nowej kolumny, która przechowuje wszelkie błędy openAI wynikające z przetwarzania każdego wiersza tekstu wejściowego. Jeśli nie ustawisz tego parametru, domyślna nazwa zostanie wygenerowana dla kolumny błędu. Jeśli wiersz wejściowy nie zawiera błędów, ta kolumna ma wartość null. |

Zwraca

Funkcja zwraca ramkę danych platformy Spark zawierającą nową kolumnę zawierającą wygenerowane osadzanie dla każdego wiersza tekstu wejściowego. Osadzania są typu [pyspark.ml.linalg.DenseVector])https://spark.apache.org/docs/latest/api/python/reference/api/pyspark.ml.linalg.DenseVector.html#densevector). Liczba elementów w narzędziu DenseVector zależy od wymiarów modelu osadzania, które można konfigurować w funkcjach sztucznej inteligencji

Example

# This code uses AI. Always review output for mistakes.

# Read terms: https://azure.microsoft.com/support/legal/preview-supplemental-terms/.

df = spark.createDataFrame([

("This duvet, lovingly hand-crafted from all-natural fabric, is perfect for a good night's sleep.",),

("Tired of friends judging your baking? With these handy-dandy measuring cups, you'll create culinary delights.",),

("Enjoy this *BRAND NEW CAR!* A compact SUV perfect for the professional commuter!",)

], ["descriptions"])

embed = df.ai.embed(input_col="descriptions", output_col="embed")

display(embed)

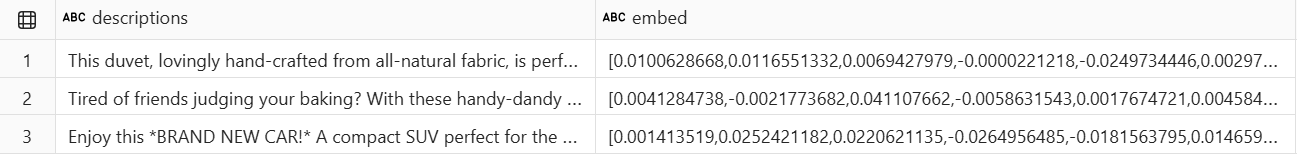

Ta przykładowa komórka kodu udostępnia następujące dane wyjściowe:

Treści powiązane

Użyj ai.embed z pandas.

Wykrywanie emocji z ai.analyze_sentiment.

Kategoryzuj tekst za pomocą ai.classify.

Wyodrębnij jednostki przy użyciu ai_extract.

Popraw gramatykę za pomocą ai.fix_grammar.

Odpowiadaj na niestandardowe zapytania użytkownika za pomocą ai.generate_response.

Oblicz podobieństwo za pomocą funkcji ai.similarity.

Podsumuj tekst za pomocą pliku ai.summarize.

Tłumaczenie tekstu za pomocą pliku ai.translate.

Dowiedz się więcej o pełnym zestawie funkcji sztucznej inteligencji.

Dostosowywanie konfiguracji funkcji sztucznej inteligencji.

Czy brakowało nam potrzebnej funkcji? Zaproponuj to na forum Fabric Ideas.