Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Szanowna społeczność,

Dzięki ciągłemu współtworzeniu środowiska ONNX i środowiska uruchomieniowego ONNX ułatwiliśmy współdziałanie w ekosystemie struktury sztucznej inteligencji oraz dostęp do wysokiej wydajności, międzyplatformowych możliwości wnioskowania zarówno dla tradycyjnych modeli uczenia maszynowego, jak i głębokich sieci neuronowych. W ciągu ostatnich kilku lat mieliśmy zaszczyt opracowywać takie kluczowe projekty uczenia maszynowego typu open source, w tym zestaw narzędzi Microsoft Cognitive Toolkit, który umożliwił swoim użytkownikom wykorzystanie rozwoju w całej branży w uczeniu głębokim na dużą skalę.

Dzisiejsza wersja 2.7 będzie ostatnią główną wersją CNTK. Możemy mieć kilka kolejnych wersji pomocniczych poprawek błędów, ale będą one oceniane w poszczególnych przypadkach. W tej wersji nie ma planów dotyczących tworzenia nowych funkcji.

Wersja CNTK 2.7 ma pełną obsługę ONNX 1.4.1 i zachęcamy tych, którzy starają się zoperacjonalizować swoje modele CNTK, aby korzystać z ONNX i środowiska uruchomieniowego ONNX. W przyszłości użytkownicy mogą nadal korzystać ze zmieniających się innowacji ONNX za pośrednictwem liczby platform, które go obsługują. Na przykład użytkownicy mogą natywnie eksportować modele ONNX z biblioteki PyTorch lub konwertować modele TensorFlow na ONNX za pomocą konwertera TensorFlow-ONNX.

Jesteśmy niezwykle wdzięczni za wszystkie wsparcie otrzymane od współautorów i użytkowników od czasu początkowej wersji open source CNTK. CNTK umożliwiło zespołom firmy Microsoft i użytkownikom zewnętrznym wykonywanie złożonych i dużych obciążeń we wszystkich aplikacjach uczenia głębokiego, takich jak historyczne przełomy w rozpoznawaniu mowy osiągnięte przez badaczy usługi Microsoft Speech, twórców platformy.

Ponieważ ONNX jest coraz częściej wykorzystywany w obsłudze modeli używanych w produktach firmy Microsoft, takich jak Bing i Office, jesteśmy dedykowani do synchronizowania innowacji z badań z rygorystycznymi wymaganiami produkcji w celu rozwoju ekosystemu.

Przede wszystkim naszym celem jest wprowadzanie innowacji w uczeniu głębokim w obrębie stosów oprogramowania i sprzętu tak otwartych i dostępnych, jak to możliwe. Będziemy ciężko pracować, aby przynieść zarówno istniejące mocne strony CNTK, jak i nowe najnowocześniejsze badania nad innymi projektami open source, aby naprawdę poszerzyć zasięg takich technologii.

Z wdzięcznością,

-- Zespół CNTK

Najważniejsze informacje o tej wersji

- Przeniesiono do interfejsu CUDA 10 dla systemów Windows i Linux.

- Obsługa zaawansowanej pętli RNN w eksporcie ONNX.

- Eksportuj modele większe niż 2 GB w formacie ONNX.

- Obsługa akcji trenowania skryptu mózgu FP16.

Obsługa CNTK dla CUDA 10

CnTK obsługuje teraz cuda 10. Wymaga to aktualizacji środowiska kompilacji do programu Visual Studio 2017 w wersji 15.9 dla systemu Windows.

Aby skonfigurować środowisko kompilacji i środowiska uruchomieniowego w systemie Windows:

- Zainstaluj program Visual Studio 2017. Uwaga: w przyszłości dla cuda 10 i nowszych nie jest już wymagane zainstalowanie i uruchomienie z określonymi narzędziami VC w wersji 14.11.

- Instalowanie nvidia CUDA 10

- W programie PowerShell uruchom polecenie: DevInstall.ps1

- Uruchom program Visual Studio 2017 i otwórz CNTK.sln.

Aby skonfigurować środowisko kompilacji i środowiska uruchomieniowego w systemie Linux przy użyciu platformy Docker, skompiluj obraz platformy Dobuntu 16.04 platformy Docker przy użyciu plików Dockerfiles tutaj. W przypadku innych systemów Linux zapoznaj się z plikami Dockerfile, aby skonfigurować biblioteki zależne dla bibliotek CNTK.

Obsługa zaawansowanej pętli RNN w eksporcie ONNX

Modele CNTK z cyklicznych pętli można eksportować do modeli ONNX za pomocą operacji skanowania.

Eksportowanie modeli większych niż 2 GB w formacie ONNX

Aby wyeksportować modele większe niż 2 GB w formacie ONNX, użyj cntk. Interfejs API funkcji: save(self, nazwa pliku, format=ModelFormat.CNTKv2, use_external_files_to_store_parameters=False) z wartością "format" ustawioną na Wartość ModelFormat.ONNX i use_external_files_to_store_parameters ustawioną na wartość True. W takim przypadku parametry modelu są zapisywane w plikach zewnętrznych. Eksportowane modele są używane z zewnętrznymi plikami parametrów podczas oceny modelu przy użyciu parametrów onnxruntime.

2018-11-26.

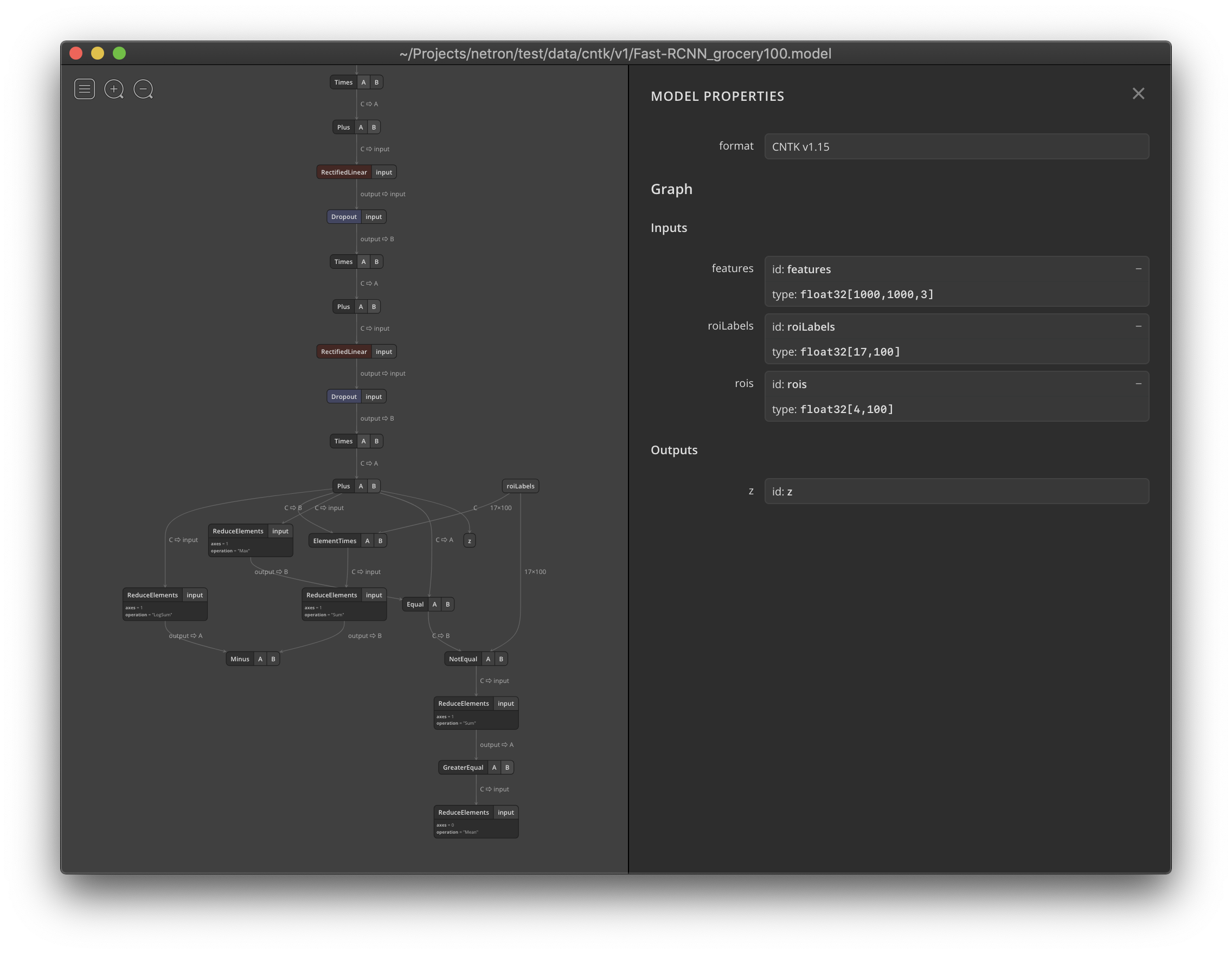

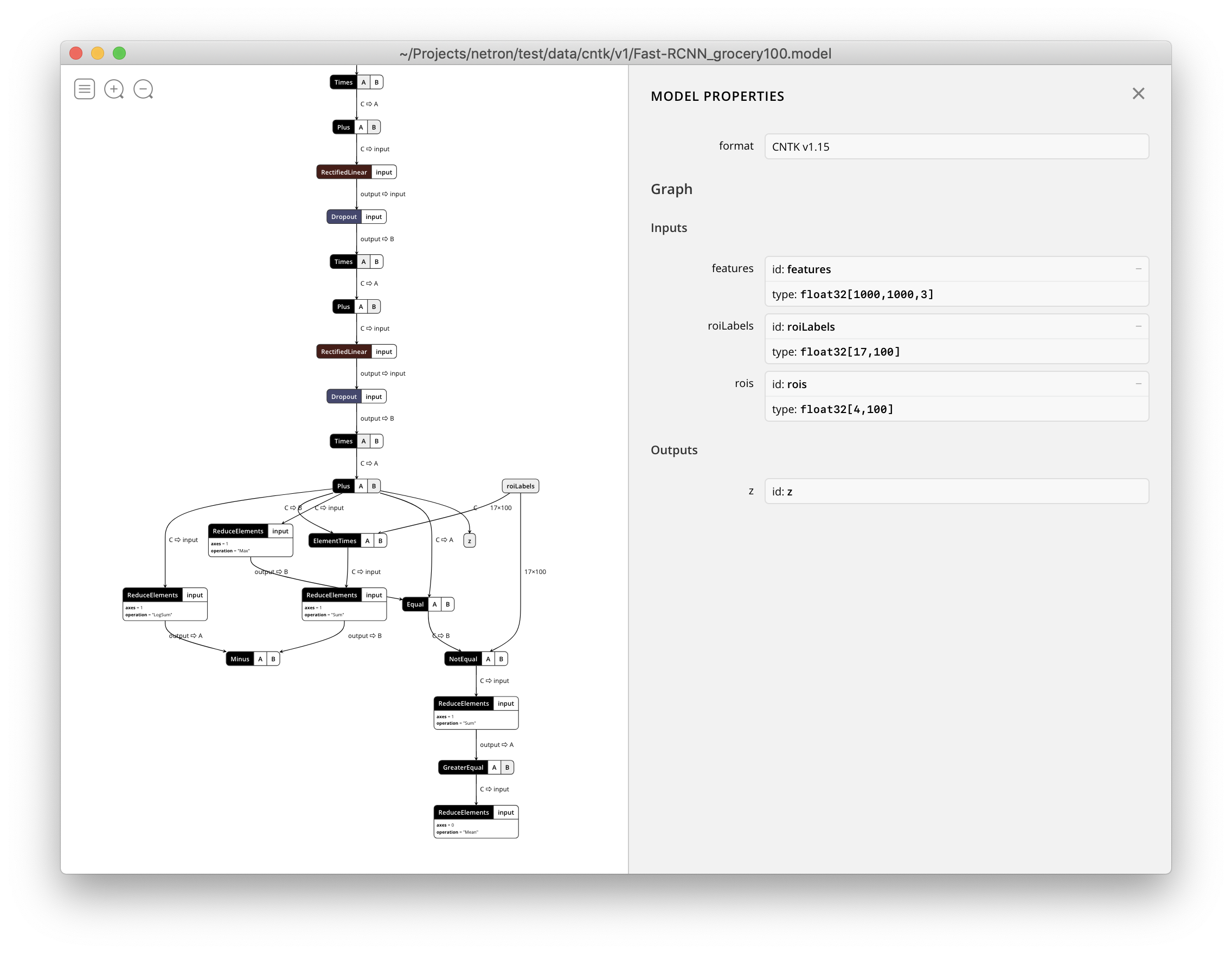

netron obsługuje teraz wizualizowanie plików .model CNTK v1 i CNTK v2.