Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Generatywna sztuczna inteligencja (GenAI) jest wdrażana w bezprecedensowym tempie, ponieważ organizacje aktywnie angażują się w GenAI lub eksperymentują z GenAI w różnych zakresach. Zespoły ds. zabezpieczeń mogą skuteczniej ograniczyć ryzyko i zarządzać nimi, proaktywnie uzyskując wgląd w użycie sztucznej inteligencji w organizacji i wdrażając odpowiednie mechanizmy kontroli. W tym artykule opisano sposób odnajdywania użycia aplikacji sztucznej inteligencji w organizacji, w tym oceny ryzyka dla poufnych danych.

Jest to drugi artykuł z serii. Przed rozpoczęciem korzystania z tego artykułu upewnij się, że wykonano zadania opisane w artykule Przygotowanie do zabezpieczeń sztucznej inteligencji w celu przygotowania środowiska z funkcjami opisanymi w tym artykule.

Firma Microsoft udostępnia narzędzia ułatwiające uzyskanie wglądu w dane, dostęp, użytkownika i zagrożenia aplikacji dla utworzonej i używanej sztucznej inteligencji. Te możliwości pomagają aktywnie rozwiązywać luki w zabezpieczeniach podczas tworzenia silnego poziomu zabezpieczeń dla sztucznej inteligencji.

W poniższej tabeli opisano ilustrację, a także przedstawiono kroki wdrażania tych funkcji.

| Krok | Zadanie | Zakres |

|---|---|---|

| 1 | Uzyskaj wgląd we wszystkie tożsamości agentów utworzone w programie Microsoft Copilot Studio i usłudze Azure AI Foundry przy użyciu identyfikatora agenta Entra firmy Microsoft. | Agenci utworzeni w narzędziu Microsoft Copilot Studio i Azure AI Foundry |

| 2 | Uzyskaj wgląd w użycie sztucznej inteligencji za pomocą usługi Microsoft Purview Data Security Posture Management (DSPM) dla sztucznej inteligencji. Stosowanie zasad w celu ochrony poufnych danych. | Copilotsi, agenci i inne aplikacje sztucznej inteligencji, które korzystają z dużych modeli językowych innych firm (LLM), w tym Obsługiwane witryny AI. |

| 3 | Odnajdywanie, akceptowanie i blokowanie aplikacji sztucznej inteligencji za pomocą usługi Microsoft Defender for Cloud Apps | Aplikacje SaaS AI |

| 4 | Odnajdywanie wdrożonych obciążeń sztucznej inteligencji w środowisku i uzyskiwanie szczegółowych informacji o zabezpieczeniach za pomocą usługi Microsoft Defender for Cloud Security Posture Management (CSPM) | Niestandardowe aplikacje sztucznej inteligencji oparte na sztucznej inteligencji na platformie Azure |

Krok 1. Zyskaj wgląd w agentów za pomocą Entra Agent ID (wersja próbna)

Gdy organizacje tworzą i wdrażają agentów sztucznej inteligencji, trudno jest śledzić te nieludzkie podmioty. To, co sprawia, że ci agenci są potężni — ich zdolność do autonomicznego obsługiwania złożonych zadań i działania jak wirtualni koledzy z zespołu — również budzi obawy. Dlatego ważne jest śledzenie tożsamości agentów, zarządzanie ich cyklem życia i uprawnieniami oraz dokładne zabezpieczanie dostępu do zasobów organizacji.

Identyfikator agenta Microsoft Entra (wersja zapoznawcza) udostępnia ujednolicony katalog wszystkich tożsamości agentów utworzonych w programie Microsoft Copilot Studio i usłudze Azure AI Foundry. Jest to pierwszy krok w zapewnianiu jeszcze większej widoczności, ochrony i zapewniania ładu szybko rosnącej liczby agentów w organizacjach.

| Zadanie | Zalecane zasoby |

|---|---|

| Wyświetlanie wszystkich agentów w organizacji | zaloguj się do centrum administracyjnego firmy Microsoft Entra i przejdź do aplikacji dla przedsiębiorstw. Na pasku filtru w górnej części widoku listy ustaw listę rozwijaną Typ aplikacji na Agent ID (wersja zapoznawcza). Natychmiast lista aplikacji przedsiębiorstwa zawęzi się, aby wyświetlić agentów sztucznej inteligencji (utworzonych za pośrednictwem Copilot Studio lub Azure AI Foundry), które są zarejestrowane w Twojej dzierżawie. |

| Dowiedz się więcej, przeglądając ten blog | Ogłoszenie Microsoft Entra Agent ID: Bezpieczne zarządzanie Twoimi agentami AI |

Krok 2. Uzyskiwanie wglądu w użycie sztucznej inteligencji za pomocą zarządzania stanem zabezpieczeń danych (DSPM) dla sztucznej inteligencji

Rozwiązanie Microsoft Purview Data Security Posture Management (DSPM) dla sztucznej inteligencji koncentruje się na tym, jak sztuczna inteligencja jest używana w organizacji, szczególnie w jaki sposób dane współdziałają z narzędziami sztucznej inteligencji. Współpracuje ona z witrynami związanymi z generatywną sztuczną inteligencją. DSPM dla sztucznej inteligencji zapewnia głębszy wgląd dla Microsoft Copilots oraz zewnętrznych aplikacji SaaS, takich jak ChatGPT Enterprise i Google Gemini.

Na poniższym diagramie przedstawiono jeden z zagregowanych widoków wpływu użycia sztucznej inteligencji na dane: wrażliwe interakcje przypadające na generatywną aplikację AI.

DSPM dla sztucznej inteligencji oferuje zestaw możliwości, które ułatwiają bezpieczne wdrażanie sztucznej inteligencji bez konieczności wyboru między produktywnością a ochroną:

- Szczegółowe informacje i analiza aktywności sztucznej inteligencji w organizacji

- Zasady gotowe do użycia w celu ochrony danych i zapobiegania utracie danych w monitach dotyczących sztucznej inteligencji

- Oceny ryzyka danych w celu identyfikowania, korygowania i monitorowania potencjalnego nadmiernego udostępniania danych

- Zalecane działania na podstawie danych Twojej dzierżawy

- Mechanizmy kontroli zgodności w celu zastosowania optymalnych polityk obsługi i przechowywania danych

Aby monitorować interakcje z witrynami sztucznej inteligencji innych firm, urządzenia muszą być dołączone do usługi Microsoft Purview. Jeśli wykonano kroki opisane w artykule Przygotowanie do zabezpieczeń sztucznej inteligencji, urządzenia zostały zarejestrowane do zarządzania w usłudze Microsoft Intune, a następnie dołączono te urządzenia do usługi Defender for Endpoint. Dołączanie urządzeń jest wspólne dla Microsoft 365 (w tym Microsoft Purview) i Microsoft Defender for Endpoint (MDE).

Skorzystaj z poniższych zasobów, aby odnaleźć aplikacje i dane sztucznej inteligencji za pomocą platformy DSPM dla sztucznej inteligencji.

| Zadanie | Zalecane zasoby |

|---|---|

| Upewnij się, że urządzenia są dołączone do usługi Microsoft Purview. | Jeśli urządzenia nie zostały jeszcze dołączone do usługi Defender dla punktu końcowego, istnieje kilka metod umożliwiających ich dołączanie. Zobacz Dołączanie urządzeń z systemem Windows do platformy Microsoft 365. |

| Informacje o wymaganiach wstępnych i sposobie działania platformy DSPM dla sztucznej inteligencji | Zagadnienia dotyczące wdrażania zarządzania stanem zabezpieczeń danych usługi Microsoft Purview dla sztucznej inteligencji |

| Rozpoczynanie korzystania z platformy DSPM dla sztucznej inteligencji | Jak używać zarządzania stanem zabezpieczeń danych dla sztucznej inteligencji |

| Przeglądanie obsługiwanych witryn sztucznej inteligencji | Obsługiwane witryny sztucznej inteligencji firmy Microsoft Purview na potrzeby zabezpieczeń danych i ochrony zgodności |

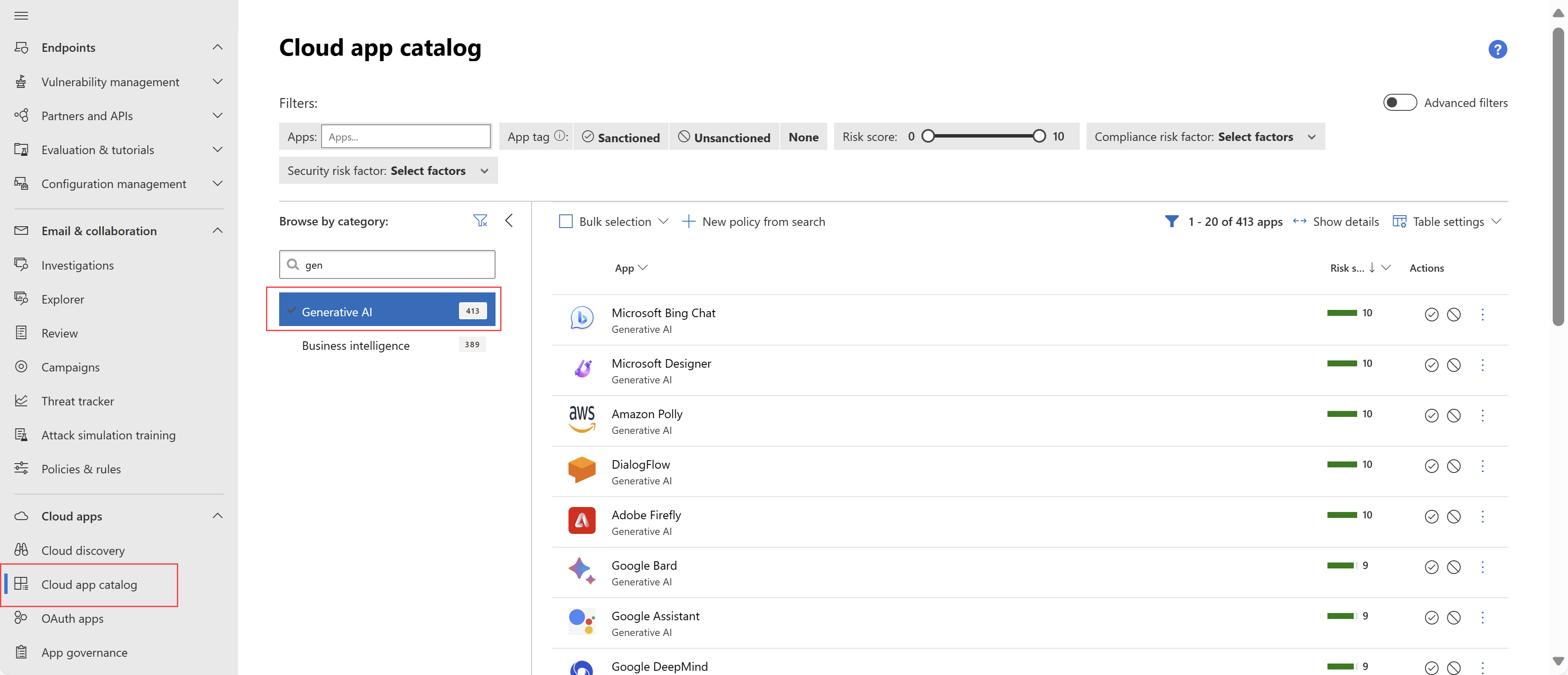

Krok 3. Odnajdywanie, akceptowanie i blokowanie aplikacji sztucznej inteligencji za pomocą usługi Microsoft Defender for Cloud Apps

Usługa Microsoft Defender for Cloud Apps ułatwia zespołom ds. zabezpieczeń odnajdywanie aplikacji i użycia usługi SaaS GenAI.

Katalog aplikacji Usługi Defender for Cloud Apps zawiera kategorię Generowanie sztucznej inteligencji dla dużych aplikacji modelu językowego (LLM), takich jak Microsoft Bing Chat, Google Bard, ChatGPT i nie tylko. Usługa Defender for Cloud Apps dodała do katalogu ponad tysiąc generacyjnych aplikacji związanych ze sztuczną inteligencją, zapewniając wgląd w sposób, w jaki generujące aplikacje sztucznej inteligencji są używane w organizacji i ułatwiają bezpieczne zarządzanie nimi.

Usługa Defender for Cloud Apps umożliwia:

- Filtr dla aplikacji sztucznej inteligencji generatywnej

- Odnajdywanie aplikacji sztucznej inteligencji używanych w organizacji

- Zapoznaj się z wbudowanymi ocenami ryzyka dla każdej aplikacji, w tym 90 czynnikami ryzyka w zakresie zabezpieczeń i zgodności z przepisami

- Akceptowanie lub odrzucanie (blokowanie) użycia określonych aplikacji

- Utwórz zasady, które będą nadal odnajdywać aplikacje sztucznej inteligencji na podstawie określonych kryteriów, w tym oceny ryzyka, liczby użytkowników dziennie i innych. Możesz nawet automatycznie usunąć aplikacje spełniające kryteria.

Aby wykonać następne kroki, skorzystaj z poniższych zasobów.

| Zadanie | Zalecane zasoby |

|---|---|

| Pilotaż i wdrażanie usługi Defender for Cloud Apps | Jak przeprowadzić pilotaż i wdrożyć usługę Microsoft Defender for Cloud Apps? |

| Zapoznaj się z tym samouczkiem wideo | Odkrywanie, które aplikacje generujące sztuczną inteligencję są używane w twoim środowisku przy użyciu usługi Defender for Cloud Apps |

| Wyświetlanie odnalezionych aplikacji | Wyświetlanie odnalezionych aplikacji za pomocą pulpitu nawigacyjnego rozwiązania Cloud Discovery |

| Znajdowanie aplikacji w chmurze i obliczanie oceny ryzyka | Wykaz aplikacji w chmurze i oceny ryzyka — Microsoft Defender for Cloud Apps |

| Zarządzanie odnalezioną aplikacją | Zarządzanie odnalezionymi aplikacjami — Microsoft Defender for Cloud Apps |

Krok 4. Odnajdywanie wdrożonych obciążeń sztucznej inteligencji w środowisku i uzyskiwanie szczegółowych informacji o zabezpieczeniach za pomocą usługi Microsoft Defender for Cloud

Plan zarządzania stanem zabezpieczeń w chmurze (CSPM) w usłudze Microsoft Defender for Cloud zapewnia możliwości zarządzania stanem zabezpieczeń sztucznej inteligencji, począwszy od odnajdywania aplikacji sztucznej inteligencji wbudowanych w środowiska:

- Odkrywanie zestawienia materiałów dla generatywnej sztucznej inteligencji (AI BOM), w tym składników aplikacji, danych i artefaktów sztucznej inteligencji od kodu po chmurę.

- Wzmocnienie poziomu zabezpieczeń aplikacji generujących sztuczną inteligencję dzięki wbudowanym rekomendacjom oraz eksplorowaniu i korygowaniu zagrożeń bezpieczeństwa.

- Korzystanie z analizy ścieżki ataku w celu identyfikowania i korygowania zagrożeń.

Użyj eksploratora zabezpieczeń w chmurze, aby zidentyfikować generowanie obciążeń i modeli sztucznej inteligencji działających w danym środowisku. Eksplorator zabezpieczeń w chmurze obejmuje wstępnie skonfigurowane zapytania:

- Obciążenia i modele sztucznej inteligencji w użyciu

- Repozytoria z podatnym kodem generowanym przez AI dla usługi Azure OpenAI

- Kontenery uruchamiające obrazy kontenerów ze znanymi lukami w zabezpieczeniach związanych z generatywną sztuczną inteligencją.

Możesz również skonfigurować własne zapytania.

Aby wykonać następne kroki, skorzystaj z poniższych zasobów.

| Zadanie | Zalecane zasoby |

|---|---|

| Dowiedz się więcej o zarządzaniu stanem zabezpieczeń sztucznej inteligencji | Zarządzanie stanem zabezpieczeń sztucznej inteligencji za pomocą usługi Defender for Cloud |

| Odnajdywanie obciążeń sztucznej inteligencji | Obciążenia i modele sztucznej inteligencji w użyciu |

| Eksplorowanie czynników ryzyka w celu wstępnego wdrażania artefaktów sztucznej inteligencji | Zagrożenia związane z artefaktami sztucznej inteligencji przed wdrożeniem |

Następny krok zabezpieczania sztucznej inteligencji

Po odnalezieniu użycia sztucznej inteligencji w organizacji następnym krokiem jest zastosowanie ochrony:

- Ochrona poufnych danych używanych w aplikacjach sztucznej inteligencji

- Implementowanie ochrony przed zagrożeniami specjalnie na potrzeby użycia sztucznej inteligencji

Zobacz następny artykuł z tej serii: Jak mogę chronić organizację podczas korzystania z aplikacji sztucznej inteligencji?