Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Este tutorial sem código de 5 minutos apresenta a IA generativa no Azure Databricks. Você usará o Playground de IA para fazer o seguinte:

- Consultar LLMs (modelos de linguagem grandes) e comparar lado a lado os resultados

- Protótipo de um agente de IA que aciona ferramentas

- Exportar seu agente para código

- Opcional: protótipo de um chatbot de resposta a perguntas usando RAG (geração aumentada de recuperação)

Antes de começar

Certifique-se de que seu espaço de trabalho pode acessar o seguinte:

- Modelos de base. Consulte a disponibilidade de recursos de serviço do Modelo.

- Catálogo do Unity Consulte Introdução ao Catálogo do Unity.

- Estrutura de agente do Mosaic AI. Consulte Recursos com disponibilidade regional limitada.

Etapa 1: Consultar LLMs usando o AI Playground

Use o Playground de IA para consultar LLMs em uma interface de chat.

- Em seu workspace, selecione Playground.

- Digite uma pergunta como "O que é RAG?".

Adicione uma nova LLM para comparar as respostas lado a lado:

- No canto superior direito, selecione + para adicionar um modelo para comparação.

- No novo painel, selecione um modelo diferente usando o seletor suspenso.

- Selecione as caixas de seleção Sincronizar para sincronizar as consultas.

- Experimente um novo prompt, como "O que é um sistema de IA composto?" para ver as duas respostas lado a lado.

Continue testando e comparando diferentes LLMs para ajudar a decidir qual é o melhor para criar um agente de IA.

Continue testando e comparando diferentes LLMs para ajudar a decidir qual é o melhor para criar um agente de IA.

Etapa 2: Prototipar um agente de IA para acionamento de ferramentas

As ferramentas permitem que as LLMs façam mais do que gerar idioma. As ferramentas podem consultar dados externos, executar código e executar outras ações. O AI Playground oferece uma opção sem código para prototipar agentes que acionam ferramentas.

No Playground, escolha um modelo rotulado ferramentas habilitadas.

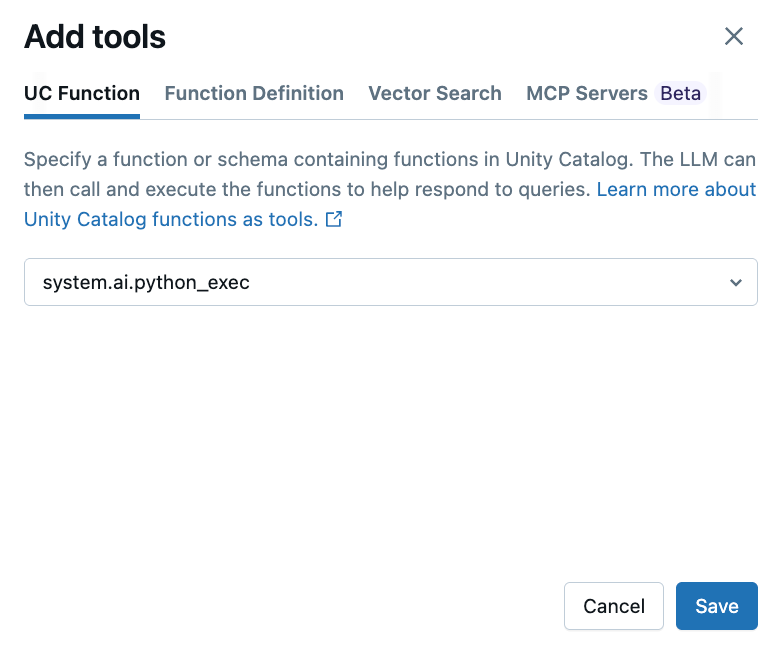

Selecione Ferramentas>+ Adicionar ferramenta e selecione a função interna do Catálogo do Unity.

system.ai.python_execEssa função permite que seu agente execute código Python arbitrário.

Faça uma pergunta que envolva a geração ou a execução do código Python. Você pode tentar diferentes variações na formulação do prompt. Se você adicionar várias ferramentas, o LLM selecionará a ferramenta apropriada para gerar uma resposta.

Prototipe o LLM com a ferramenta de funções hospedadas

Etapa 3: Exportar seu agente para o código

Depois de testar seu agente no AI Playground, clique em Obter código>Criar bloco de anotações do agente para exportar seu agente para um notebook Python.

O notebook Python contém código que define o agente e o implanta em um endpoint de serviço do modelo.

Opcional: protótipo de um bot de resposta a perguntas do RAG

Se você tiver um índice de pesquisa de vetor configurado em seu workspace, poderá criar um protótipo de um bot de resposta a perguntas. Esse tipo de agente usa documentos em um índice de pesquisa de vetor para responder perguntas com base nesses documentos.

Clique em Ferramentas>+ Adicionar ferramenta. Em seguida, selecione o índice de Pesquisa de Vetor.

Faça uma pergunta relacionada aos seus documentos. O agente pode usar o índice de vetor para pesquisar informações relevantes e citará todos os documentos usados em sua resposta.

Para configurar um índice de pesquisa de vetor, consulte Criar um índice de pesquisa de vetor

Próximas etapas

Use o Agent Framework para desenvolver agentes avançados programaticamente. Confira Criar agentes de IA no código.

Saiba como criar um aplicativo RAG. Consulte o guia do RAG.