Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Este guia de início rápido explica como criar uma Definição de Tarefa Spark que contém código Python com o Spark Structured Streaming para carregar dados num lakehouse e, em seguida, servi-los por meio de um endpoint de análise SQL. Depois de concluíres este início rápido, terás uma definição de tarefa do Spark que é executada continuamente, e o ponto de extremidade de análise SQL poderá exibir os dados de entrada.

Criar um script Python

Utilize o seguinte script Python para criar uma tabela Delta de streaming num armazém de dados em nuvem utilizando o Apache Spark. O script lê um fluxo de dados gerados (uma linha por segundo) e grava-o no modo de acréscimo em uma tabela Delta chamada streamingtable. Ele armazena os dados e as informações do ponto de verificação na casa do lago especificada.

Use o seguinte código Python que usa o streaming estruturado do Spark para obter dados em uma tabela lakehouse.

from pyspark.sql import SparkSession if __name__ == "__main__": # Start Spark session spark = SparkSession.builder \ .appName("RateStreamToDelta") \ .getOrCreate() # Table name used for logging tableName = "streamingtable" # Define Delta Lake storage path deltaTablePath = f"Tables/{tableName}" # Create a streaming DataFrame using the rate source df = spark.readStream \ .format("rate") \ .option("rowsPerSecond", 1) \ .load() # Write the streaming data to Delta query = df.writeStream \ .format("delta") \ .outputMode("append") \ .option("path", deltaTablePath) \ .option("checkpointLocation", f"{deltaTablePath}/_checkpoint") \ .start() # Keep the stream running query.awaitTermination()Salve seu script como arquivo Python (.py) em seu computador local.

Criar uma casa no lago

Use as seguintes etapas para criar uma casa no lago:

Inicie sessão no portal do Microsoft Fabric.

Navegue até o espaço de trabalho desejado ou crie um novo, se necessário.

Para criar uma Lakehouse, selecione Novo item no espaço de trabalho e, em seguida, selecione Lakehouse no painel que se abre.

Digite o nome da sua casa do lago e selecione Criar.

Criar uma definição de trabalho do Spark

Use as seguintes etapas para criar uma definição de trabalho do Spark:

No mesmo espaço de trabalho em que você criou uma casa no lago, selecione Novo item.

No painel que se abre, em Obter Dados, selecione Definição de Tarefa do Spark.

Digite o nome da sua Definição de Trabalho do Spark e selecione Criar.

Selecione Upload e selecione o arquivo Python que você criou na etapa anterior.

Em Lakehouse Reference escolhe a lakehouse que criaste.

Definir política de repetição para definição de tarefas do Spark

Use as seguintes etapas para definir a política de repetição para sua definição de trabalho do Spark:

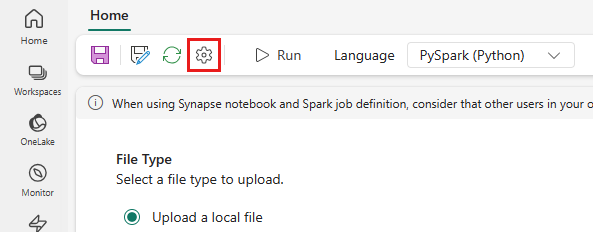

No menu superior, selecione o ícone Configuração .

Abra o separador Otimização e defina o gatilho Política de Retentativa como Ativado.

Defina o máximo de tentativas ou marque Permitir tentativas ilimitadas.

Especifique o tempo entre cada tentativa de repetição e selecione Aplicar.

Nota

Há um limite vitalício de 90 dias para a configuração da política de novas tentativas. Quando a política de repetição estiver ativada, o trabalho será reiniciado de acordo com a política dentro de 90 dias. Após esse período, a política de repetição deixará automaticamente de funcionar e o trabalho será encerrado. Os usuários precisarão reiniciar manualmente o trabalho, o que, por sua vez, reativará a política de repetição.

Executar e monitorar a definição de trabalho do Spark

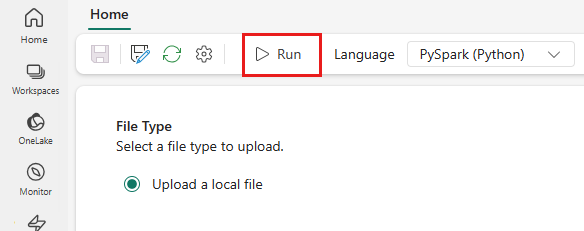

No menu do topo, selecione o ícone Executar.

Verifique se a definição do Spark Job foi enviada com êxito e está em execução.

Visualizar dados utilizando um endpoint de análise SQL

Após a execução do script, uma tabela chamada streamingtable com as colunas timestamp e valor é criada no lakehouse. Você pode visualizar os dados usando o endpoint de análise SQL.

No espaço de trabalho, abra a sua Lakehouse.

Mude para o ponto de extremidade de análise SQL no canto superior direito.

No painel de navegação esquerdo, expanda Schemas > dbo >Tables, selecione streamingtable para visualizar os dados.