Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

A atividade do Azure Databricks no Data Factory for Microsoft Fabric permite orquestrar os seguintes trabalhos do Azure Databricks:

- Bloco de Notas

- Frasco

- Python

- Tarefa

Este artigo fornece um passo a passo que descreve como criar uma atividade do Azure Databricks usando a interface do Data Factory.

Pré-requisitos

Para começar, você deve preencher os seguintes pré-requisitos:

- Uma conta de locatário com uma assinatura ativa. Crie uma conta gratuitamente.

- Um espaço de trabalho é criado.

Configurando uma atividade do Azure Databricks

Para usar uma atividade do Azure Databricks em um pipeline, conclua as seguintes etapas:

Configurando a conexão

Crie um novo pipeline em seu espaço de trabalho.

Selecione Adicionar atividade de pipeline e procure por Azure Databricks.

Como alternativa, pode pesquisar o Azure Databricks no painel Atividades do pipeline e selecioná-lo para o adicionar à área de trabalho do pipeline.

Selecione a nova atividade do Azure Databricks na tela, se ainda não estiver selecionada.

Consulte as orientações de configurações gerais para configurar a guia Configurações gerais.

Configuração de clusters

Selecione a guia Cluster. Em seguida, você pode escolher uma conexão existente ou criar uma nova conexão do Azure Databricks e, em seguida, escolher um novo cluster de trabalho, um cluster interativo existente ou um pool de instâncias existente.

Dependendo do que você escolher para o cluster, preencha os campos correspondentes conforme apresentado.

- No novo cluster de trabalho e pool de instâncias já existente, também tens a capacidade de configurar o número de workers e ativar instâncias spot.

Você também pode especificar outras configurações de cluster, como política de cluster, configuração do Spark, variáveis de ambiente do Spark e tags personalizadas, conforme necessário para o cluster ao qual você está se conectando. Os scripts de inicialização do Databricks e o caminho de destino do log do cluster também podem ser adicionados nas configurações adicionais do cluster.

Nota

Todas as propriedades avançadas de clusters e expressões dinâmicas suportadas no serviço vinculado do Azure Databricks no Azure Data Factory agora também têm suporte na atividade do Azure Databricks no Microsoft Fabric, na secção 'Configuração de cluster adicional' da interface do utilizador. Como estas propriedades agora estão incluídas na interface do utilizador da atividade, podem ser usadas com uma expressão (conteúdo dinâmico) sem a necessidade da especificação JSON avançada.

A Atividade do Azure Databricks agora também oferece suporte à Política de Clusters e ao Catálogo de Unidade.

- Em configurações avançadas, você pode escolher a Diretiva de Cluster para especificar quais configurações de cluster são permitidas.

- Além disso, em configurações avançadas, você pode configurar o Modo de Acesso ao Catálogo Unity para maior segurança. Os tipos de modo de acesso disponíveis são:

- Modo de acesso de usuário único Este modo foi projetado para cenários em que cada cluster é usado por um único usuário. Ele garante que o acesso aos dados dentro do cluster seja restrito apenas a esse usuário. Este modo é útil para tarefas que exigem isolamento e tratamento de dados individuais.

- Modo de acesso compartilhado Nesse modo, vários usuários podem acessar o mesmo cluster. Ele combina a governança de dados do Unity Catalog com as ACLs (listas de controle de acesso à tabela) herdadas. Este modo permite o acesso colaborativo aos dados, mantendo os protocolos de governança e segurança. No entanto, ele tem certas limitações, como não suportar o Databricks Runtime ML, trabalhos de envio do Spark e APIs e UDFs específicas do Spark.

- Modo Sem Acesso Esse modo desabilita a interação com o Catálogo Unity, o que significa que os clusters não têm acesso aos dados gerenciados pelo Catálogo Unity. Esse modo é útil para cargas de trabalho que não exigem os recursos de governança do Unity Catalog.

Definindo configurações

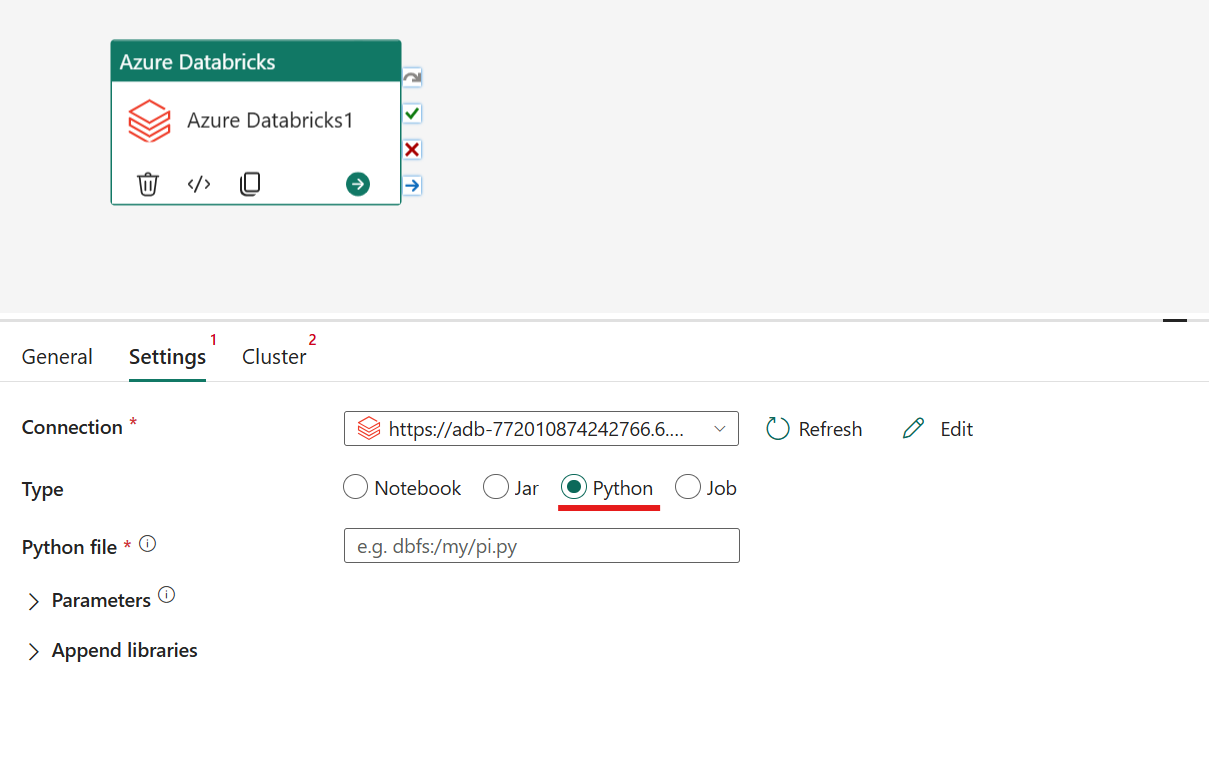

Selecionando a guia Configurações , você pode escolher entre 4 opções do tipo Azure Databricks que você gostaria de orquestrar.

Orquestrando o tipo de Bloco de Anotações na atividade do Azure Databricks:

Na aba Configurações, você pode escolher o botão de opção rádio Notebook para executar um Notebook. Você precisa especificar o caminho do bloco de anotações a ser executado no Azure Databricks, parâmetros básicos opcionais a serem passados para o bloco de anotações e quaisquer bibliotecas extras a serem instaladas no cluster para executar o trabalho.

Orquestrando o tipo Jar na atividade do Azure Databricks:

Na guia Configurações, você pode escolher o botão de opção Jar para executar um Jar. Você precisa especificar o nome da classe a ser executada no Azure Databricks, parâmetros básicos opcionais a serem passados para o Jar e quaisquer bibliotecas adicionais a serem instaladas no cluster para executar o trabalho.

Orquestrando o tipo Python na atividade do Azure Databricks:

Na guia Configurações, pode escolher o botão de rádio Python para executar um ficheiro Python. Você precisa especificar o caminho dentro do Azure Databricks para um arquivo Python a ser executado, parâmetros básicos opcionais a serem passados e quaisquer bibliotecas adicionais a serem instaladas no cluster para executar o trabalho.

Orquestrando o tipo de trabalho na atividade do Azure Databricks:

Na guia Configurações, pode escolher o botão de opção Job para executar um Job do Databricks. Você precisa especificar Job usando a lista suspensa a ser executada no Azure Databricks e quaisquer parâmetros opcionais de Job a serem passados. Você pode executar trabalhos sem servidor com essa opção.

Bibliotecas suportadas para a atividade do Azure Databricks

Na definição de atividade do Databricks acima, pode-se especificar estes tipos de biblioteca: jar, egg, whl, maven, pypi, cran.

Para obter mais informações, consulte a documentação do Databricks para tipos de biblioteca.

Passando parâmetros entre uma atividade do Azure Databricks e as pipelines

Você pode passar parâmetros para blocos de anotações usando a propriedade baseParameters na atividade Databricks.

Às vezes, pode ser necessário retornar valores de um notebook para o serviço para controle de fluxo ou uso em atividades a jusante (com um limite de tamanho de 2 MB).

Em seu bloco de anotações, por exemplo, você pode chamar dbutils.notebook.exit("returnValue") e o "returnValue" correspondente será retornado ao serviço.

Você pode consumir a saída no serviço usando expressões como

@{activity('databricks activity name').output.runOutput}.

Guarde e execute ou agende o pipeline

Depois de configurar quaisquer outras atividades necessárias para o pipeline, alterne para a guia Página Inicial na parte superior do editor de pipeline e selecione o botão Salvar para salvar o pipeline. Selecione Executar para executá-lo diretamente ou Agendar para agendá-lo. Você também pode visualizar o histórico de execução aqui ou definir outras configurações.