Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Os testes são essenciais para garantir que seus agentes personalizados no Copilot Studio Kit respondam e se comportem conforme o esperado. Este artigo explica como criar, gerenciar e validar diferentes tipos de testes, incluindo cenários de várias voltas, executar operações em massa com o Excel e duplicar conjuntos de testes.

Tipos de teste

Você pode criar vários tipos de testes para validar seus agentes.

| Tipo de Ensaio | Description |

|---|---|

| Correspondência de Resposta | Este teste é o tipo de teste mais simples. Ele compara a resposta do agente com a resposta esperada usando o operador de comparação selecionado. Por padrão, a correspondência exata ("igual") é usada. Outros operadores de comparação disponíveis são "Não é igual", "Contém", "Não contém", "Começa com", "Não começa com", "Termina com" e "Não termina com". |

| Anexos (cartões adaptáveis, etc.) | Compara a resposta JSON dos anexos do agente com os anexos esperados JSON (matriz completa de anexos). Por padrão, a correspondência exata ("igual") é usada. Outros operadores de comparação disponíveis são "Não é igual", "Contém", "Não contém". Um operador de comparação especial chamado "AI Validation" usa modelos de linguagem para validar o anexo com base em instruções de validação fornecidas pelo fabricante, semelhantes a respostas generativas. |

| Correspondência de tópicos |

Disponível apenas quando o enriquecimento do Dataverse (Enriquecer com Transcrições de Conversações) estiver configurado. Quando a etapa de enriquecimento do Dataverse for concluída, esse teste compara o nome do tópico esperado e o nome do tópico acionado. O teste de correspondência de tópicos também oferece suporte à correspondência de vários tópicos com agentes personalizados que têm orquestração generativa habilitada. Na correspondência multitópico, os tópicos são separados por vírgula; por exemplo: "Topic1,Topic2". |

| Respostas generativas |

Disponível apenas se o enriquecimento do AI Builder (Analisar respostas geradas) estiver configurado. Usa um modelo de linguagem grande para avaliar se a resposta gerada pela IA está próxima de uma resposta de amostra ou respeita as instruções de validação. Quando o Enrich With Azure Application Insights é configurado, testes negativos, como moderação ou ausência de resultados de pesquisa, também podem ser testados. |

| Várias voltas | Consiste num ou mais casos de teste de outros tipos, como correspondência de resposta, anexos, correspondência de tópico e respostas generativas. Todos os testes subordinados num teste de várias voltas são executados no mesmo contexto de conversação na ordem especificada. Utilize testes de várias voltas para testar um cenário de ponto a ponto e para testar agentes personalizados com orquestração generativa. Saiba mais em Testes em múltiplas fases. |

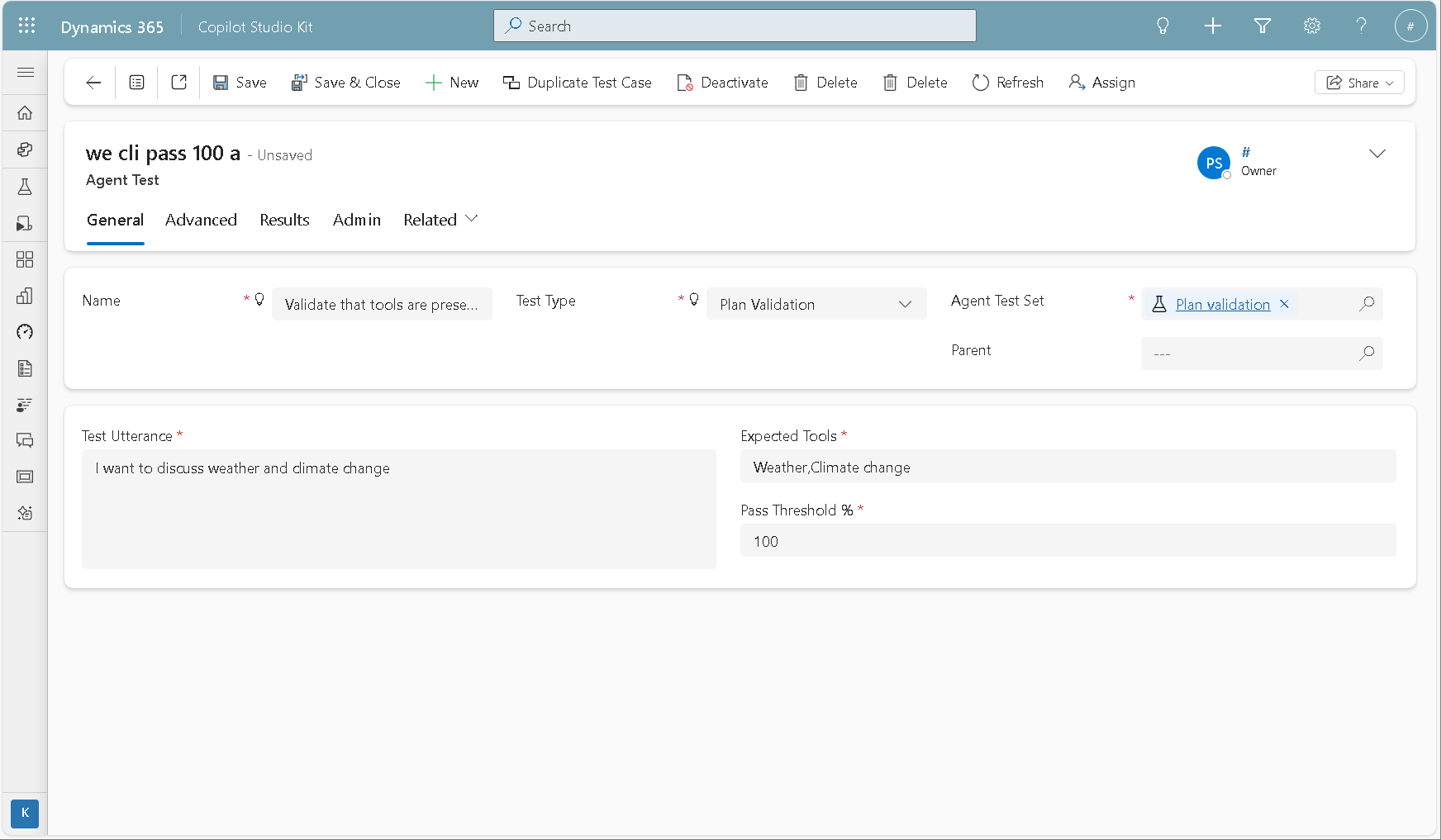

| Validação do plano | Permite que o criador valide se o plano dinâmico do agente personalizado inclui as ferramentas esperadas. Esse tipo de teste destina-se a agentes personalizados do Copilot Studio que têm orquestração generativa habilitada. Saiba mais em Teste de validação de plano. |

Criar um novo conjunto de testes

Use conjuntos de teste para agrupar vários testes. Ao executar testes, selecione um conjunto de testes para executar todos os testes nesse conjunto.

- Aceda à aplicação Copilot Studio Kit.

- Vá para Conjuntos de teste.

- Crie um novo registo do Conjunto de Testes do Agente.

- Insira um Nome.

- Selecione Guardar.

Criar um novo teste

Depois de criar um conjunto de testes, você pode adicionar testes a ele. Na subgrelha Testes, selecione + Novo Teste de Agente.

A tabela seguinte descreve os campos.

| Nome da coluna | Obrigatório | Description |

|---|---|---|

| Nome | Yes | Nome do ensaio. Esse nome pode ser um ID de referência interno, como TST-001. |

| Conjunto de Testes de Agentes | Yes | Conjunto de testes principal para o teste. |

| Tipo de Ensaio | Yes | Um dos tipos de teste disponíveis. |

| Enviar evento startConversation | Não | Se habilitado, o agente recebe o evento startConversation para iniciar proativamente a conversa e o enunciado de teste é enviado depois. Essa configuração geralmente é necessária quando o tópico Início da conversa inclui lógica que deve ser executada antes de responder ao usuário ou testar a declaração. |

| Posição esperada da mensagem de resposta | Não | Não defina um valor se não tiver certeza. Essa opção permite capturar uma resposta específica do agente quando ele envia várias mensagens. Por exemplo, se o agente primeiro disser "Olá" e depois "Como posso ajudá-lo?", e você quiser testar a segunda mensagem, defina o valor como 1. A ordem é baseada em 0, portanto, a primeira mensagem é indexada como 0, a segunda resposta como 1 e assim por diante. |

| Enunciado de teste | Yes | A mensagem que você deseja enviar ao agente como parte do teste. |

| Resposta esperada | Depends | Obrigatório para o tipo de teste Response Match. Resposta esperada do agente. Para um teste de Respostas Generativas, defina uma amostra de resposta ou suas próprias instruções de validação para o modelo de linguagem grande. |

| Variáveis externas JSON | Não | Registro JSON para qualquer valor externo ou contextual que você queira passar para o agente como parte do teste. Por exemplo: { "Language": "fr" } |

| Segundos antes de obter resposta | Não | Número de segundos a aguardar antes de avaliar a resposta do bot. Na maioria dos casos, você pode deixar esse valor vazio, mas é útil em situações em que o agente chama uma API e a resposta pode levar mais tempo do que o normal. |

| Resultados Esperados de Respostas Generativas | Depends | Obrigatório para o tipo de teste Respostas Generativas. Deve ser respondido ou não respondido. Quando o enriquecimento do Azure Application Insights está habilitado, você pode escolher Moderado ou Sem Resultados de Pesquisa. |

| Nome do tópico esperado | Depends | Obrigatório para o tipo de teste Topic Match. Nome do tópico que você espera que seja acionado. A correspondência de vários tópicos é suportada para agentes personalizados que têm orquestração generativa ativada. Para correspondência de vários tópicos, use uma lista separada por vírgula; por exemplo: "Topic1,Topic2". Não adicione espaço em branco extra. A correspondência de vários tópicos garante que os tópicos esperados estejam entre os tópicos do plano. |

| JSON de anexos esperados | Depends | Obrigatório para o tipo de teste Anexos (Cartões Adaptativos, etc.). Matriz JSON de anexos completos que você espera da resposta do agente. |

| Ferramentas esperadas | Depends | Obrigatório para o tipo de teste de validação de plano. Lista separada por vírgulas de ferramentas esperadas (ferramentas, ações e agentes conectados). Não adicione espaço em branco extra. A ordem não é relevante. Exemplo: "Meteorologia,Alterações climáticas" |

| Limiar de Passagem % | Depends | Obrigatório para o tipo de teste de validação de plano. A porcentagem de ferramentas esperadas que devem estar no plano dinâmico para que o teste seja aprovado. Se a porcentagem for 100, todas as ferramentas esperadas precisam estar no plano dinâmico para que o teste seja bem-sucedido. Ferramentas extras no plano dinâmico não afetam o resultado do teste. |

Testes em múltiplos ciclos

Para o tipo de teste de várias voltas, pode especificar um ou mais testes secundários de tipos regulares. Cada teste subordinado tem uma ordem e criticidade. A ordem define a ordem de execução dentro do mesmo contexto de conversação (dentro do caso de teste de várias voltas). A criticidade define se o caso de teste subordinado deve passar para que a execução do teste de várias voltas continue.

Todos os testes subordinados que exigem avaliação pós-teste, como Correspondência de Tópicos ou Respostas Gerativas, são deixados no estado pendente e a execução do teste continua independentemente da criticidade. Se algum dos testes críticos falhar, a execução do teste de várias voltas é interrompida e o seu resultado é considerado reprovado. Se todos os casos de teste subordinados críticos forem bem-sucedidos, o resultado de várias voltas também será êxito.

Utilize casos de teste secundários não críticos para fornecer informações a agentes personalizados com orquestração generativa. Você também pode usar esses casos de teste quando a resposta não importa e você deseja criar testes críticos.

Planejar testes de validação

A Validação de Planos concentra-se na corretude das ferramentas. Em vez de avaliar o que o agente diz, esse tipo de teste verifica se as ferramentas esperadas foram usadas durante o plano.

Ao definir um teste de Validação de Plano, você especifica:

- Um enunciado de teste

- Uma lista separada por vírgulas das ferramentas esperadas a serem incluídas no plano dinâmico

- Um limiar de aprovação, que representa o desvio a tolerar em relação à lista

Este teste usa transcrições de conversação e é avaliado após a execução do teste real como uma atividade de enriquecimento.

Tenha em atenção o seguinte:

Ferramentas esperadas: você pode incluir ferramentas, ações e agentes conectados na lista separada por vírgula. Nenhum espaço em branco extra é permitido, e a ordem não importa.

Limite de aprovação %: O limite de aprovação especifica a parte necessária de ferramentas esperadas que precisam estar no plano dinâmico para que o teste seja bem-sucedido.

A validação do plano é um teste determinístico: calcula o desvio das ferramentas reais das ferramentas esperadas e compara-o com o limiar de aprovação. Se o desvio estiver dentro do limiar, o teste é aprovado; caso contrário, falha.

Saiba mais: Orquestre o comportamento do agente com IA generativa.

Usar o Excel para criar ou atualizar testes em massa

Depois de criar um conjunto de testes, você pode usar o Excel para criar ou atualizar testes em massa.

- No registo do conjunto de testes, alterne a vista de subgrelha de Testes para Vista de Exportação/Importação.

- Selecione Exportar testes de agente no Excel Online.

- Adicione e modifique testes conforme necessário.

- Selecione Guardar.

Se estiver a importar testes secundários de várias voltas, deve primeiro criar ou importar o teste principal real de várias voltas. Em seguida, importe os casos de teste secundários.

Saiba mais sobre a importação e exportação do Excel em aplicações orientadas por modelos do Power Apps.

Testes duplicados e conjuntos de testes

Você pode duplicar conjuntos de teste e testes individuais.

Para duplicar um único caso de teste, abra o registro de teste do agente e selecione Duplicar caso de teste. Essa ação é útil quando você cria variantes de um caso de teste, como alterar o local, a hora ou a quantidade.

Para duplicar um conjunto de teste inteiro, abra o registro do conjunto de teste e selecione Duplicar conjunto de teste na barra de comandos. Esta ação cria uma cópia do conjunto de testes e de todos os testes secundários.