Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Utilize o Azure Synapse Link para ligar os seus dados do Microsoft Dataverse ao Azure Synapse Analytics para explorar os seus dados e acelerar o tempo até às informações. Este artigo mostra como executar pipelines do Azure Synapse ou do Azure Data Factory para copiar dados do Azure Data Lake Storage Gen2 para um Banco de Dados SQL do Azure com o recurso de atualizações incrementais habilitado no Azure Synapse Link.

Observação

O Azure Synapse Link para Microsoft Dataverse era anteriormente conhecido como Exportar para data lake. O serviço mudou de nome em maio de 2021 e continuará a exportar dados para o Azure Data Lake, bem como para o Azure Synapse Analytics. Este modelo é um exemplo de código. Recomendamos que você use esse modelo como orientação para testar a funcionalidade de recuperação de dados do Azure Data Lake Storage Gen2 para o Banco de Dados SQL do Azure usando o pipeline fornecido.

Pré-requisitos

- Azure Synapse Link para Dataverse. Este guia pressupõe que você já tenha atendido aos pré-requisitos para criar um Azure Synapse Link com o Azure Data Lake. Para obter mais informações: Pré-requisitos para um Azure Synapse Link for Dataverse com seu Azure Data Lake

- Crie um Azure Synapse Workspace ou Azure Data Factory no mesmo inquilino do Microsoft Entra que o seu inquilino do Power Apps.

- Crie um Azure Synapse Link for Dataverse com a atualização de pasta incremental habilitada para definir o intervalo de tempo. Para obter mais informações: Consultar e analisar as atualizações incrementais

- O fornecedor Microsoft.EventGrid precisa de ser registado para o acionador. Para obter mais informações: Portal do Azure. Observação: se você estiver usando esse recurso no Azure Synapse Analytics, verifique se sua assinatura também está registrada no provedor de recursos do Data Factory, caso contrário, você receberá um erro informando que a criação de uma "Assinatura de Evento" falhou.

- Crie um banco de dados SQL do Azure com a propriedade Permitir que os serviços e recursos do Azure acessem este servidor habilitada. Para obter mais informações: O que devo saber ao configurar meu Banco de Dados SQL do Azure (PaaS)?

- Crie e configure um Integration Runtime do Azure. Para mais informações: Criar runtime de integração para Azure - Azure Data Factory & Azure Synapse

Importante

O uso deste modelo pode incorrer em custos adicionais. Esses custos estão relacionados ao uso do Azure Data Factory ou do pipeline de espaço de trabalho Synapse e são cobrados mensalmente. O custo do uso de pipelines depende principalmente do intervalo de tempo para atualizações incrementais e dos volumes de dados. Para planejar e gerenciar o custo do uso desse recurso, vá para: Monitore os custos no nível do pipeline com análise de custos

É importante levar esses custos adicionais em consideração ao decidir usar esse modelo, pois eles não são opcionais e devem ser pagos para continuar usando esse recurso.

Usar o modelo de solução

- Vá para o portal do Azure e abra o espaço de trabalho Azure Synapse.

- Selecione Integrar>Explorar galeria.

- Selecione Copiar dados do Dataverse para o SQL do Azure usando o Synapse Link na galeria de integração.

Configurar o modelo de solução

Crie um serviço vinculado ao Azure Data Lake Storage Gen2, que está conectado ao Dataverse usando o tipo de autenticação apropriado. Para fazer isso, selecione Testar conexão para validar a conectividade e, em seguida, selecione Criar.

Semelhante às etapas anteriores, crie um serviço vinculado ao Banco de Dados SQL do Azure onde os dados do Dataverse serão sincronizados.

Depois que as entradas estiverem configuradas, selecione Usar este modelo.

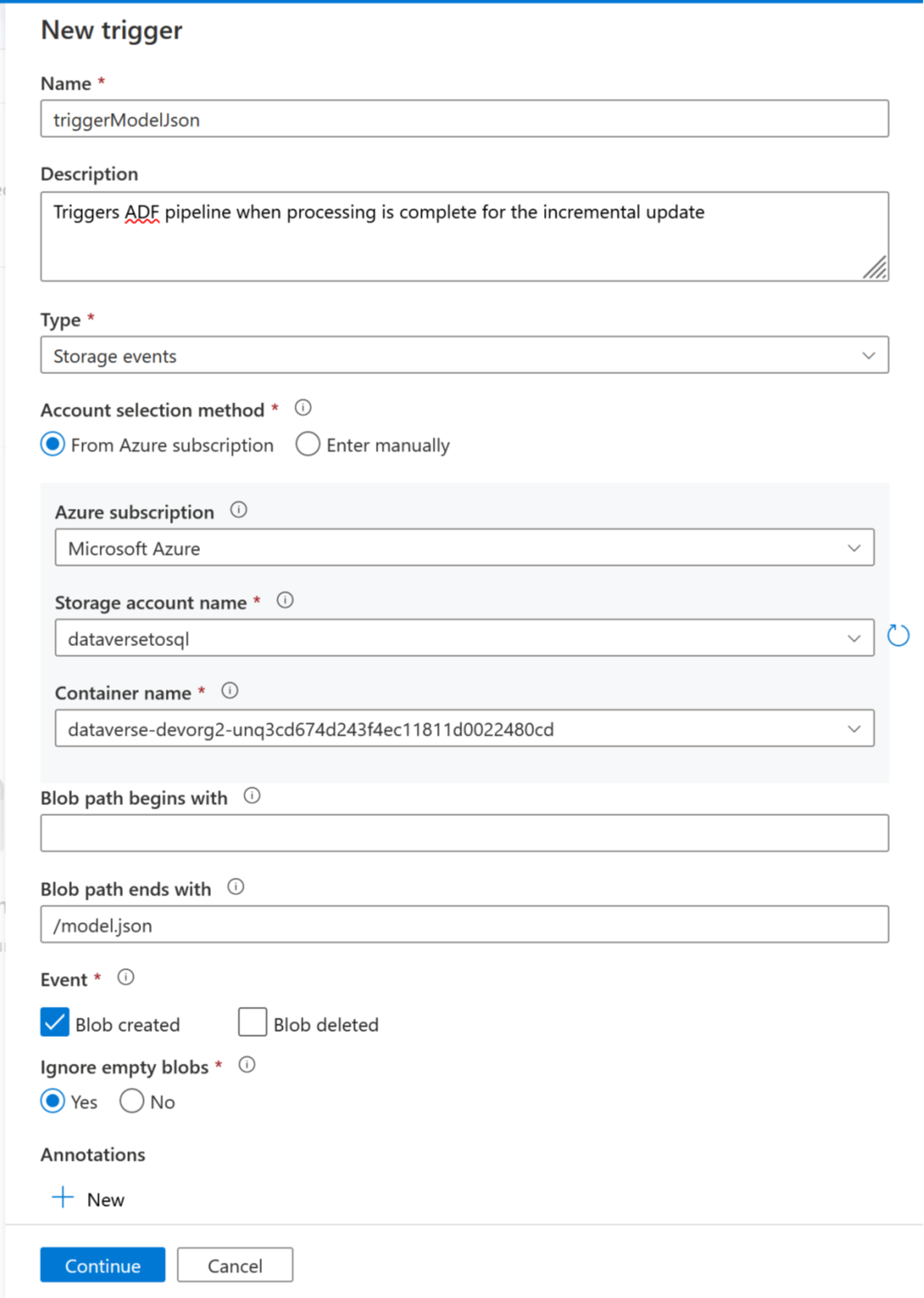

Agora, é possível adicionar um acionador para automatizar este pipeline, para que o pipeline possa sempre processar ficheiros quando as atualizações incrementais são concluídas periodicamente. Vá para Gerenciar>gatilho e crie um gatilho usando as seguintes propriedades:

- Nome: insira um nome para o gatilho, como triggerModelJson.

- Tipo: Eventos de armazenamento.

- Assinatura do Azure: selecione a assinatura que tem o Azure Data Lake Storage Gen2.

- Nome da conta de armazenamento: selecione o armazenamento que tem dados do Dataverse.

- Nome do contêiner: selecione o contêiner criado pelo Azure Synapse Link.

- O caminho do blob termina com: /model.json

- Evento: Blob criado.

- Ignorar bolhas vazias: Sim.

- Iniciar acionador: ative Iniciar acionador aquando da criação.

Selecione Continuar para prosseguir para a próxima tela.

Na próxima tela, o gatilho valida os arquivos correspondentes. Selecione OK para criar o gatilho.

Associe o gatilho a um pipeline. Vá para o pipeline importado anteriormente e selecione Adicionar desencadeador>Novo/Editar.

Selecione o gatilho na etapa anterior e, em seguida, selecione Continuar para prosseguir para a próxima tela onde o gatilho valida os arquivos correspondentes.

Selecione Continuar para prosseguir para a próxima tela.

Na seção Trigger Run Parameter, insira os parâmetros abaixo e selecione OK.

-

Contentor:

@split(triggerBody().folderPath,'/')[0] -

Pasta:

@split(triggerBody().folderPath,'/')[1]

-

Contentor:

Depois de associar o gatilho ao pipeline, selecione Validar tudo.

Quando a validação for bem-sucedida, selecione Publicar tudo.

Selecione Publicar para publicar todas as alterações.

Adicionar um filtro de subscrição de evento

Para garantir que o acionador só é acionado quando a criação de model.json estiver concluída, é necessário atualizar os filtros avançados para a subscrição de eventos do acionador. Um evento é registrado na conta de armazenamento na primeira vez que o gatilho é executado.

Quando a execução de um gatilho for concluída, vá para a conta de armazenamento >Eventos>Assinaturas de Eventos.

Selecione o evento que foi registrado para o gatilho model.json.

Selecione o separador Filtros e, em seguida, selecione Adicionar novo filtro.

Crie o filtro:

- Chave: assunto

- Operador: String não termina com

- Valor: /blobs/model.json

Remova o parâmetro CopyBlob da matriz data.apiValue .

Selecione Salvar para implantar o filtro adicional.