測試對於確保 Copilot Studio Kit 中的自訂代理程式按預期回應和行為至關重要。 本文說明如何建立、管理和驗證不同類型的測試,包括多回合案例、使用 Excel 執行大量作業,以及重複測試集。

測試類型

您可以建立數種類型的測試來驗證代理程式。

| 測試類型 | Description |

|---|---|

| 回應比對 | 此測試是最簡單的測試類型。 它使用選取的比較運算子將客服專員回應與預期回應進行比較。 預設會使用完全相符比對 (「等於」)。 其他可用的比較運算子包括「不等於」、「包含」、「不包含」、「以…開頭」、「不以…開頭」、「以…結尾」和「不以…結尾」。 |

| 附件 (調適型卡片等) | 將代理程式附件 JSON 回應與預期的附件 JSON (完整的附件陣列) 進行比較。 預設會使用完全相符比對 (「等於」)。 其他可用的比較運算子包括「不等於」、「包含」、「不包含」。一種名為「AI Validation」的特殊比較運算子使用語言模型根據製作者提供的驗證指令來驗證附件,類似於生成答案。 |

| 主題匹配 |

只有在設定了 Dataverse 擴充 (使用交談記錄擴充) 時才可用。 當 Dataverse 擴充步驟完成時,此測試會比較預期的主題名稱和觸發的主題名稱。 主題比對測試也支援與已啟用生成式協調流程的自訂代理程式進行 多主題比對 。 在多主題比對中,主題以逗號分隔;例如:「Topic1,Topic2」。 |

| 生成式答案 |

只有在設定 AI Builder 擴充 (分析產生的答案) 時才可用。 使用大型語言模型來評估 AI 生成的答案是否接近示例答案或遵守驗證指令。 設定使用 Azure Application Insights 擴充時,也可以測試陰性測試,例如審核或無搜尋結果。 |

| 多回合 | 由一或多個其他類型的測試案例組成,例如回應比對、附件、主題比對和生成式答案。 在多重回合測試中,所有子測試都會在相同的交談內容中,依照指定的順序執行。 使用多回合測試來端對端測試案例,並使用生成式協調流程測試自訂代理程式。 在 多回合測試中瞭解更多資訊。 |

| 計劃驗證 | 允許製作者驗證自訂代理程式的動態計劃是否包含預期的工具。 此測試類型適用於已啟用生成式協調流程的 Copilot Studio 自訂代理程式。 在 計劃驗證測試中深入瞭解。 |

建立新的測試集

使用測試集將多個測試分組在一起。 當您執行測試時,請選取測試集以執行該集中的所有測試。

- 存取 Copilot Studio 套件應用程式。

- 移至 測試集。

- 建立新的測試代理程式集記錄。

- 輸入名稱。

- 選取 [儲存]。

建立新的測試

建立測試集之後,您可以將測試新增至其中。 從 [測試] 子方格中,選取 [+ 新增代理程式測試]。

下表說明這些欄位。

| 欄位名稱 | 為必填項目 | Description |

|---|---|---|

| 名稱 | Yes | 測試的名稱。 此名稱可以是內部參考 ID,例如 TST-001。 |

| 代理程式測試集 | Yes | 測試的父測試組。 |

| 測試類型 | Yes | 可用的 測試類型之一。 |

| 傳送 startConversation 事件 | 否 | 如果啟用,代理程式會收到 startConversation 事件,因此會 主動啟動交談,並在之後傳送測試語句。 當 交談開始 主題包含在回應使用者或測試話語之前必須執行的邏輯時,通常需要此設定。 |

| 回應訊息的預期位置 | 否 | 如果您不確定,請不要設定值。 此選項可讓您在傳送多則訊息時擷取特定客服專員回應。 例如,如果客服專員先說「您好」,然後說「我該如何幫忙?」,而您想要測試第二則訊息,請將值設定為 1。 順序是從 0 開始的,因此第一則訊息會索引為 0,第二則回應會索引為 1,依此類推。 |

| 測試語句 | Yes | 您要在測試過程中傳送給客服專員的訊息。 |

| 預期回應 | 視情況而定 | 回應比對測試類型的必須項目。 客服專員的預期回應。 對於生成式答案測試,請為大型語言模型設定範例答案或您自己的驗證指示。 |

| 外部變數JSON | 否 | JSON 記錄,用於您想要在測試過程中傳遞給代理程式的任何 外部或內容值 。 例如:{ "Language": "fr" } |

| 在得到答案之前的幾秒鐘 | 否 | 評估機器人回應之前等待的秒數。 在大多數情況下,您可以將此值保留空白,但在代理呼叫 API 且回應可能需要比平常更長的時間的情況下,它很有用。 |

| 預期的生成式答案結果 | 視情況而定 | 對於生成式答案測試類型,這是必填的。 應該是已回答或未回答。 啟用 Azure Application Insights 擴充時,您可以選擇 [已審核] 或 [無搜尋結果]。 |

| 預期主題名稱 | 視情況而定 | 主題比對測試類型是必要項目。 您預期觸發的主題名稱。 已啟用生成式協調流程的自訂 Agent 支援多主題比對。 對於多主題匹配,請使用逗號分隔的列表;例如:「Topic1,Topic2」。 不要添加額外的空白。 多主題匹配可確保預期主題在計劃中的主題中。 |

| 預期附件JSON | 視情況而定 | 附件 (調適型卡片等) 測試類型的必要項目。 您預期從 Agent 回覆中取得的完整附件 JSON 陣列。 |

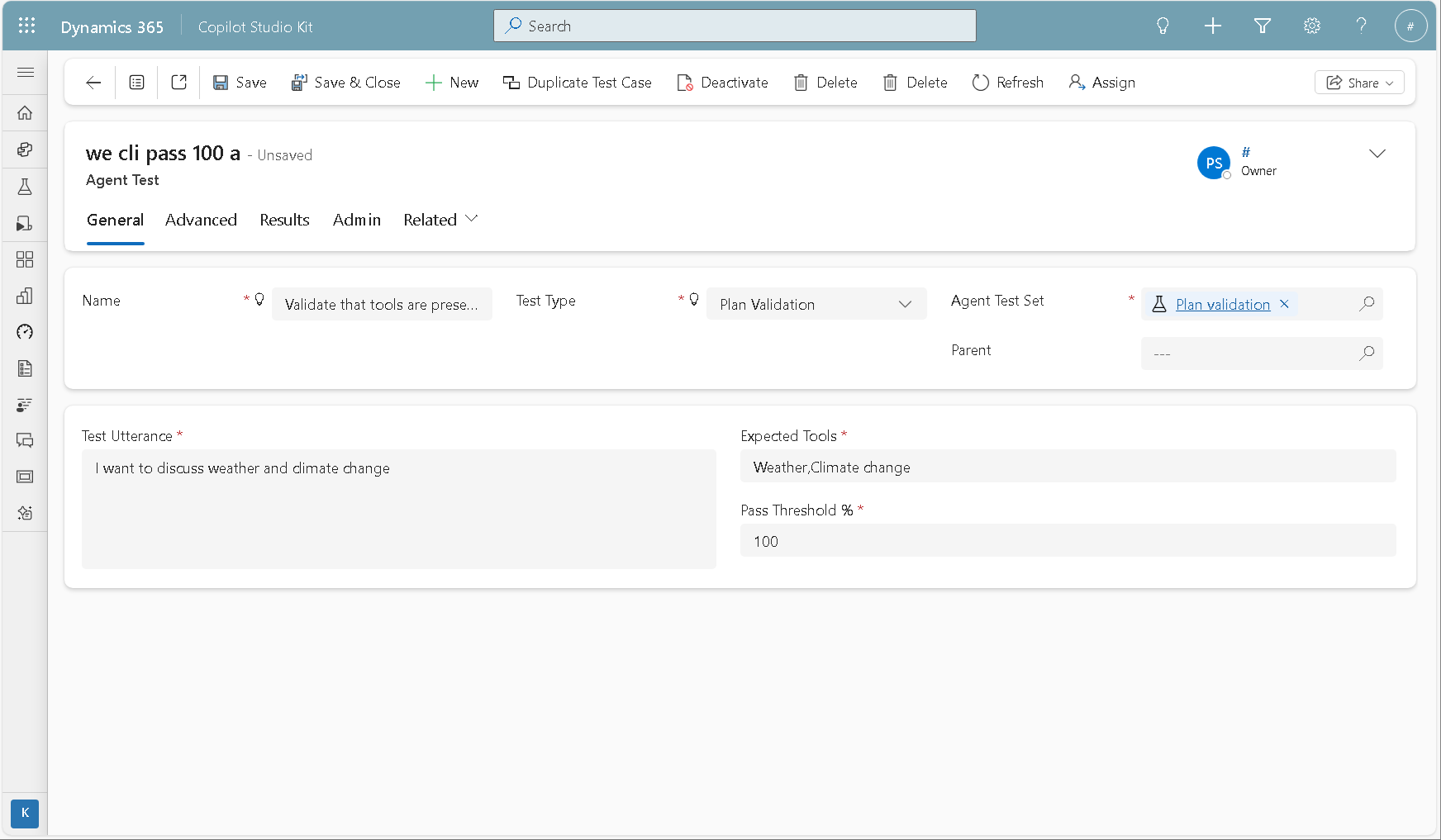

| 預期工具 | 視情況而定 | 方案驗證測試類型的強制項目。 以逗號分隔的預期工具清單 (工具、動作和連線的代理程式)。 不要添加額外的空白。 順序無關緊要。 範例:「天氣、氣候變遷」 |

| 通過門檻百分比 | 視情況而定 | 計劃驗證測試類型必須包含的一項。 測試通過所需動態方案中必須存在之預期工具的百分比。 如果百分比為 100,則所有預期的工具都必須位於動態計劃中,測試才能成功。 動態計劃中的額外工具不會影響測試結果。 |

多回合測試

對於多回合測試類型,您可以指定一或多個 一般 類型的子測試。 每個子測試都有其順序和重要性。 順序定義相同交談內容 (在多回合測試案例中) 的執行順序。 重要性定義子測試案例是否必須通過,才能讓多回合測試執行繼續。

任何需要測試後評估的子測試 (例如主題比對或生成式答案) 都會保留為擱置狀態,且無論重要性狀態為何,測試執行都會繼續執行。 如果任何關鍵測試失敗,則會停止執行多輪測試,其結果會被視為失敗。 如果所有重要子測試案例都通過,則多回合測試的結果也是成功的。

使用非關鍵子測試案例,透過生成式協調流程將資訊「饋送」給自訂代理程式。 您也可以在回應不重要時使用這些測試案例,並逐步過渡到關鍵測試。

計劃驗證測試

計劃驗證著重於工具的正確性。 此測試類型不是評估客服專員所說的內容,而是檢查計劃期間是否使用了預期的工具。

定義「計劃驗證」測試時,您可以指定:

- 測試語句

- 逗號分隔的預期工具清單,包含在動態計劃中

- 通過閾值,表示容許與清單偏差的程度

此測試會使用交談文字記錄,並在實際測試執行後作為擴充活動進行評估。

請注意下列事項:

預期工具:您可以在逗號分隔的清單中包含工具、動作和連線的客服專員。 不允許多餘的空白,順序無關緊要。

通過閾值 %:通過閾值指定測試成功所需動態方案中必須存在之預期工具的必要份額。

計劃驗證是一種確定性測試:它計算實際工具與預期工具的偏差,並將其與通過閾值進行比較。 如果偏差在閾值內,則測試通過;否則,它會失敗。

進一步了解: 使用生成式 AI 協調客服專員行為。

使用 Excel 大量建立或更新測試

建立測試集之後,您可以使用 Excel 大量建立或更新測試。

- 從測試集記錄中,將子方格視圖從 [測試] 切換為 [匯出/匯入檢視]。

- 選取 [在 Excel Online 中匯出代理程式測試]。

- 視需要新增和修改測試。

- 選取 [儲存]。

如果您要匯入多回合子測試,則必須先建立或匯入實際的多回合父測試。 然後,匯入子測試案例。

深入瞭解 Power Apps 模型導向應用程式中的 Excel 匯入和匯出。

重複的測試和測試集

您可以複製測試集和個別測試。

若要複製單一測試案例,請開啟代理程式測試記錄,然後選取 複製測試案例。 當您建立測試案例的變體時,例如變更位置、時間或金額,此動作很有用。

若要複製整個測試集,請開啟測試集記錄,然後從命令列中選取 複製測試集 。 此動作會建立測試集及其所有子測試的複本。