Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

GILT FÜR: Alle API Management-Ebenen

Sie können KI-Modellendpunkte importieren, die in Azure OpenAI in Foundry Models bereitgestellt werden, in Ihre API-Verwaltungsinstanz als REST-API. Verwenden Sie KI-Gatewayrichtlinien und andere Funktionen in der API-Verwaltung, um die Integration zu vereinfachen, die Observierbarkeit zu verbessern und die Kontrolle über die Modellendpunkte zu verbessern.

Dieser Artikel enthält zwei Optionen zum Importieren einer Azure OpenAI-API in eine Azure API-Verwaltungsinstanz als REST-API:

Importieren einer Azure OpenAI-API direkt aus einer Bereitstellung in Microsoft Foundry (empfohlen)

Laden Sie die OpenAPI-Spezifikation für Azure OpenAI herunter und bearbeiten Sie sie, und fügen Sie sie der API-Verwaltung als OpenAPI-API hinzu.

Weitere Informationen zum Verwalten von LLM-APIs in der API-Verwaltung:

Funktionen des KI-Gateways in Azure API Management

Hinweis

API-Verwaltungsrichtlinien wie azure-openai-token-limit und azure-openai-emit-token-metric unterstützen bestimmte API-Endpunkte, die über bestimmte Azure OpenAI-Modelle verfügbar gemacht werden. Weitere Informationen finden Sie unter Unterstützte Azure OpenAI-Modelle.

Voraussetzungen

Eine bestehende API Management-Instanz. Erstellen Sie bitte eine, falls noch nicht geschehen.

(Für den Import aus Microsoft Foundry) Ein Microsoft Foundry-Projekt mit einem bereitgestellten Azure OpenAI-Modell. Weitere Informationen zur Modellbereitstellung in Azure OpenAI finden Sie im Ressourcenbereitstellungshandbuch.

Notieren Sie sich die ID (Name) der Bereitstellung. Sie benötigen sie, wenn Sie die importierte API in der API-Verwaltung testen.

Berechtigungen zum Gewähren des Zugriffs auf die Azure OpenAI-Ressource über die API Management-Instanz

Option 1: Importieren der OpenAI-API aus Microsoft Foundry

Sie können eine Azure OpenAI-Modellbereitstellung direkt aus Microsoft Foundry in die API-Verwaltung importieren. Ausführliche Informationen finden Sie unter Importieren einer Microsoft Foundry-API.

Beim Importieren der API:

- Geben Sie den Microsoft Foundry-Dienst an, der die Azure OpenAI-Modellbereitstellung hosten soll.

- Geben Sie die Azure OpenAI-Clientkompatibilitätsoption an. Diese Option konfiguriert die API-Verwaltungs-API mit einem

/openaiEndpunkt.

Option 2. Hinzufügen der OpenAPI-Spezifikation zu API Management

Alternativ können Sie die OpenAPI-Spezifikation für die Azure OpenAI REST-API manuell herunterladen und API Management als OpenAPI-API hinzufügen.

Herunterladen der OpenAPI-Spezifikation

Laden Sie die OpenAPI-Spezifikation für die Azure OpenAI REST-API herunter, z. B. die Ga-Version 2024-10-21.

Öffnen Sie in einem Text-Editor die von Ihnen heruntergeladene Spezifikationsdatei.

Ersetzen Sie im

servers-Element der Spezifikation den Namen Ihres Azure OpenAI-Endpunkts in den Platzhalterwerten vonurl- unddefault-Endpunkten. Wenn Ihr Azure OpenAI-Endpunkt beispielsweise lautetcontoso.openai.azure.com, aktualisieren Sie dasserversElement mit den folgenden Werten:-

URL:

https://contoso.openai.azure.com/openai -

Standardendpunkt :

contoso.openai.azure.com

[...] "servers": [ { "url": "https://contoso.openai.azure.com/openai", "variables": { "endpoint": { "default": "contoso.openai.azure.com" } } } ], [...]-

URL:

Notieren Sie sich den Wert der API

versionin der Spezifikation. Sie benötigen sie, um die API zu testen. Beispiel:2024-10-21.

Importieren der OpenAPI-Spezifikation in API Management

- Wechseln Sie im Azure-Portal zu Ihrer API-Verwaltungsinstanz.

- Wählen Sie im linken Menü APIs>+ API hinzufügen aus.

- Wählen Sie unter Neue API definieren die Option OpenAPI aus. Geben Sie einen Anzeigenamen und einen Namen für die API ein.

- Geben Sie ein API-URL-Suffix ein, das mit

/openaiendet, um auf die Azure OpenAI-API-Endpunkte in Ihrer API Management-Instanz zuzugreifen. Beispiel:my-openai-api/openai. - Klicken Sie auf Erstellen.

API-Verwaltung importiert die API und zeigt Vorgänge aus der OpenAPI-Spezifikation an.

Konfigurieren der Authentifizierung bei der Azure OpenAI-API

Um sich bei der Azure OpenAI-API zu authentifizieren, stellen Sie einen API-Schlüssel bereit, oder verwenden Sie eine verwaltete Identität. Wenn Sie die Azure OpenAI-API direkt aus microsoft Foundry importiert haben, wird die Authentifizierung mithilfe der verwalteten Identität der API-Verwaltungsinstanz automatisch konfiguriert.

Wenn Sie die Azure OpenAI-API aus der OpenAPI-Spezifikation hinzugefügt haben, müssen Sie die Authentifizierung konfigurieren. Weitere Informationen zum Konfigurieren der Authentifizierung mithilfe von API-Verwaltungsrichtlinien finden Sie unter Authentifizieren und Autorisieren von LLM-APIs.

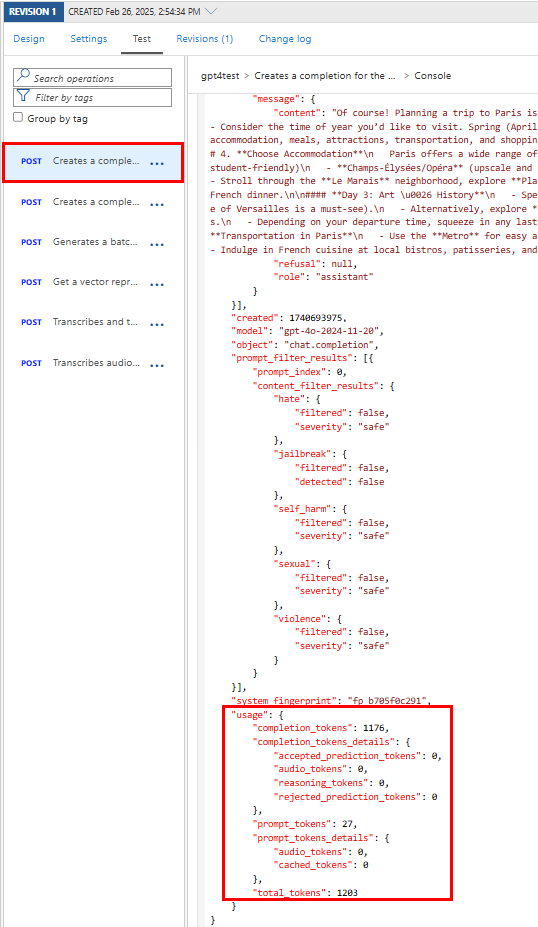

Testen der Azure OpenAI-API

Um sicherzustellen, dass Ihre Azure OpenAI-API erwartungsgemäß funktioniert, testen Sie sie in der API-Verwaltungstestkonsole. Sie müssen eine Modellbereitstellungs-ID (Name) bereitstellen, die Sie in der Microsoft Foundry-Projektressource und der API-Version zum Testen der API konfiguriert haben.

Wählen Sie die API aus, die Sie im vorherigen Schritt erstellt haben.

Wählen Sie die Registerkarte Testen aus.

Wählen Sie einen Vorgang aus, der mit dem in der Azure OpenAI-Ressource implementierten Modell kompatibel ist. Auf der Seite werden Felder für Parameter und Header angezeigt.

Geben Sie in Vorlagenparameter die folgenden Werte ein:

Geben Sie bei Bedarf weitere Parameter und Header ein. Je nach Vorgang und Modell müssen Sie möglicherweise einen Anforderungstext konfigurieren oder aktualisieren. Hier ist beispielsweise ein grundlegender Anforderungstext für einen Chat-Abschlussvorgang:

{ "model": "any", "messages": [ { "role": "user", "content": "Help me plan a vacation trip to Paris." } ], "max_tokens": 100 }Hinweis

In der Testkonsole fügt die API-Verwaltung automatisch einen Ocp-Apim-Subscription-Key-Header hinzu und legt den Abonnementschlüssel für das integrierte All-Access-Abonnement fest. Dieser Schlüssel bietet Zugriff auf jede API in der API-Verwaltungsinstanz. Um optional den Ocp-Apim-Subscription-Key-Header anzuzeigen, wählen Sie das Symbol "eye" neben der HTTP-Anforderung aus.

Wählen Sie Send (Senden) aus.

Wenn der Test erfolgreich verläuft, antwortet das Back-End mit einem erfolgreichen HTTP-Antwortcode und einigen Daten. Die Antwort enthält Tokennutzungsdaten, mit denen Sie Ihre Azure OpenAI-API-Tokennutzung überwachen und verwalten können.

Zugehöriger Inhalt

- Einschränkungen beim API-Import

- Importieren einer OpenAPI-Spezifikation

- Importieren einer SOAP-API

- Importieren einer SOAP-API und Konvertieren in REST

- Importieren einer App Service-API

- Importieren einer Container-App-API

- Importieren einer WebSocket-API

- Importieren einer GraphQL-API

- Importieren eines GraphQL-Schemas und Einrichten von Feldauflösern

- Importieren einer Funktions-App-API

- Importieren einer Logik-App-API

- Tutorial: Integrieren von API Management in Service Fabric in Azure

- Importieren einer Azure AI Foundry-API

- Importieren einer Azure OpenAI-API

- Importieren einer LLM-API

- Importieren einer OData-API

- Exportieren einer REST-API als MCP-Server

- Verfügbarmachen eines vorhandenen MCP-Servers

- Importieren einer A2A-Agent-API

- Importieren von SAP OData-Metadaten

- Importieren einer gRPC-API

- Bearbeiten von APIs