Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

SE APLICA A: todos los niveles de API Management

Puede importar los puntos de conexión del modelo de IA implementados en Azure OpenAI en Foundry Models a la instancia de API Management como API REST. Use directivas de puerta de enlace de IA y otras funcionalidades de API Management para simplificar la integración, mejorar la observabilidad y mejorar el control sobre los puntos de conexión del modelo.

En este artículo se muestran dos opciones para importar una API de Azure OpenAI en una instancia de Azure API Management como UNA API REST:

Importación de una API de Azure OpenAI directamente desde una implementación en Microsoft Foundry (recomendado)

Descargue y edite la especificación de OpenAPI para Azure OpenAI y agréguela a API Management como una API de OpenAPI.

Obtenga más información sobre cómo administrar las API de LLM en API Management:

Funcionalidades de puerta de enlace de IA en Azure API Management

Nota:

Las directivas de API Management, como azure-openai-token-limit y azure-openai-emit-token-metric , admiten determinados puntos de conexión de API expuestos a través de modelos específicos de Azure OpenAI. Para más información, consulte Modelos de Azure OpenAI compatibles.

Requisitos previos

Una instancia existente de API Management. Créelo si aún no lo ha hecho.

(Para la importación desde Microsoft Foundry) Un proyecto de Microsoft Foundry con un modelo de Azure OpenAI implementado. Para más información sobre la implementación de modelos en Azure OpenAI, consulte la guía de implementación de recursos.

Anote el identificador (nombre) de la implementación. Lo necesita al probar la API importada en API Management.

Permisos para conceder acceso al recurso de Azure OpenAI desde la instancia de API Management.

Opción 1. Importación de openAI API desde Microsoft Foundry

Puede importar una implementación de modelos de Azure OpenAI directamente desde Microsoft Foundry a API Management. Para obtener más información, consulte Importación de una API de Microsoft Foundry.

Al importar la API:

- Especifique el servicio Microsoft Foundry que hospeda la implementación del modelo de Azure OpenAI.

- Especifique la opción de compatibilidad del cliente de Azure OpenAI . Esta opción configura la API de API Management con un punto de conexión

/openai.

Opción 2. Adición de una especificación de OpenAPI a API Management

Como alternativa, descargue manualmente la especificación de OpenAPI para la API de REST de Azure OpenAI y agréguela a API Management como una API de OpenAPI.

Descargar la especificación de OpenAPI

Descargue la especificación de OpenAPI para la API REST de Azure OpenAI, como la versión de disponibilidad general 2024-10-21.

En un editor de texto, abra el archivo de especificación que descargó.

En el elemento

serversde la especificación, sustituya el nombre de su punto de conexión de Azure OpenAI en los marcadores de posición de los puntos de conexiónurlydefault. Por ejemplo, si el punto de conexión de Azure OpenAI escontoso.openai.azure.com, actualice elserverselemento con los siguientes valores:-

url:

https://contoso.openai.azure.com/openai -

punto de conexión predeterminado:

contoso.openai.azure.com

[...] "servers": [ { "url": "https://contoso.openai.azure.com/openai", "variables": { "endpoint": { "default": "contoso.openai.azure.com" } } } ], [...]-

url:

Anote el valor de la API

versionen la especificación. Lo necesita para probar la API. Ejemplo:2024-10-21.

Agregar la especificación de OpenAPI a API Management

- En Azure Portal, vaya a la instancia de API Management.

- En el menú izquierdo, seleccione API>+Agregar API.

- En Definir una nueva API, seleccione OpenAPI. Escriba un Nombre para mostrar y un Nombre para la API.

- Escriba un sufijo de dirección URL de API que termine en

/openaipara acceder a los puntos de conexión de la Azure OpenAI API en su instancia de API Management. Por ejemplo:my-openai-api/openai. - Seleccione Crear.

API Management importa la API y muestra las operaciones de la especificación openAPI.

Configuración de la autenticación en Azure OpenAI API

Para autenticarse en la API de Azure OpenAI, proporcione una clave de API o use una identidad administrada. Si importó la API de Azure OpenAI directamente desde Microsoft Foundry, la autenticación mediante la identidad administrada de la instancia de API Management se configura automáticamente.

Si ha agregado la API de Azure OpenAI desde su especificación de OpenAPI, debe configurar la autenticación. Para obtener más información sobre cómo configurar la autenticación mediante directivas de API Management, consulte Autenticación y autorización a las API de LLM.

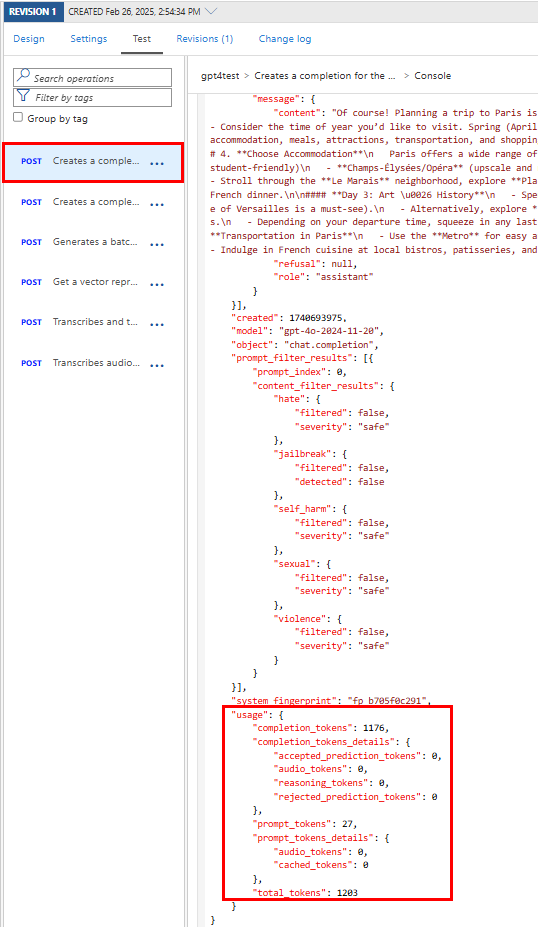

Prueba de la API de Azure OpenAI

Para asegurarse de que la API de Azure OpenAI funciona según lo previsto, pruóbela en la consola de prueba de API Management. Debe proporcionar un identificador de implementación de modelo (nombre) que configuró en el recurso del proyecto Microsoft Foundry y la versión de la API para probar la API.

Seleccione la API que creó en los pasos anteriores.

Seleccione la pestaña Prueba.

Seleccione una operación que sea compatible con el modelo que ha implementado en el recurso de Azure OpenAI. En la página se muestran los campos de los parámetros y los encabezados.

En Parámetros de plantilla, escriba los siguientes valores:

Escriba otros parámetros y encabezados según sea necesario. En función de la operación y el modelo, es posible que tenga que configurar o actualizar un cuerpo de solicitud. Por ejemplo, este es un cuerpo de solicitud básico para una operación de finalización de chat:

{ "model": "any", "messages": [ { "role": "user", "content": "Help me plan a vacation trip to Paris." } ], "max_tokens": 100 }Nota:

En la consola de prueba, API Management agrega automáticamente un encabezado Ocp-Apim-Subscription-Key y establece la clave de suscripción para la suscripción de acceso completo integrada. Esta clave proporciona acceso a todas las API de la instancia de API Management. Para mostrar opcionalmente el encabezado Ocp-Apim-Subscription-Key , seleccione el icono "ojo" junto a la solicitud HTTP.

Seleccione Enviar.

Cuando la prueba se realiza correctamente, el back-end responde con un código de respuesta HTTP correcto y algunos datos. La respuesta incluye datos de uso de tokens para ayudarle a supervisar y administrar el consumo de tokens de api de Azure OpenAI.

Contenido relacionado

- Limitaciones de importación de API

- Importación de una especificación de OpenAPI

- Importación de una API de SOAP

- Importar una API de SOAP y convertir en REST

- Importar un API de App Service

- Importación de una API de aplicación de contenedor

- Importación de WebSocket API

- Importación de GraphQL API

- Importación de un esquema GraphQL y configuración de solucionadores de campos

- Importación de una API de aplicación de funciones

- Importación de una API de aplicación lógica

- Importación de un servicio Service Fabric

- Importación de una API de Azure AI Foundry

- Importación de una API de Azure OpenAI

- Importación de una API de LLM

- Importación de una API de OData

- Exportación de una API REST como servidor MCP

- Exposición de un servidor MCP existente

- Importación de una API de agente de A2A

- Importación de metadatos de SAP OData

- Importación de una API de gRPC

- Edición de una API