適用対象: すべての API Management レベル

Foundry Models の Azure OpenAI にデプロイされた AI モデル エンドポイントを、REST API として API Management インスタンスにインポートできます。 API Management で AI ゲートウェイ ポリシーやその他の機能を使用して、統合を簡素化し、監視性を向上させ、モデル エンドポイントの制御を強化します。

この記事では、Azure OpenAI API を REST API として Azure API Management インスタンスにインポートする 2 つのオプションを示します。

Azure OpenAI の OpenAPI 仕様をダウンロードして編集し、それを OpenAPI API として API Management に追加します。

API Management での LLM API の管理の詳細については、以下を参照してください。

Azure API Management の AI ゲートウェイ機能

注

azure-openai-token-limit や azure-openai-emit-token-metric などの API Management ポリシーは、特定の Azure OpenAI モデルを介して公開される特定の API エンドポイントをサポートします。 詳細については、「 サポートされている Azure OpenAI モデル」を参照してください。

前提条件

既存の API Management インスタンスがある。 まだない場合は、作成してください。

(Microsoft Foundry からのインポートの場合)Azure OpenAI モデルがデプロイされた Microsoft Foundry プロジェクト。 Azure OpenAI でのモデルデプロイの詳細については、 リソース デプロイ ガイドを参照してください。

デプロイの ID (名前) を書き留めておきます。 API Management でインポートされた API をテストするときに必要になります。

API Management インスタンスから Azure OpenAI リソースへのアクセス権を付与するアクセス許可。

オプション 1. Microsoft Foundry から OpenAI API をインポートする

Azure OpenAI モデルのデプロイは、Microsoft Foundry から API Management に直接インポートできます。 詳細については、「 Microsoft Foundry API のインポート」を参照してください。

API をインポートする場合:

- Azure OpenAI モデルのデプロイをホストする Microsoft Foundry サービスを指定します。

-

Azure OpenAI クライアント互換性オプションを指定します。 このオプションでは、

/openaiエンドポイントを使用して API Management API を構成します。

オプション 2. OpenAPI 仕様を API Management に追加する

または、Azure OpenAI REST API の OpenAPI 仕様を手動でダウンロードし、OpenAPI API として API Management に追加します。

OpenAPI の仕様をダウンロードする

2024-10-21 GA バージョンなど、Azure OpenAI REST API の OpenAPI 仕様をダウンロードします。

テキスト エディターで、ダウンロードした仕様ファイルを開きます。

仕様の

servers要素で、azure OpenAI エンドポイントの名前を、urlエンドポイントとdefaultエンドポイントのプレースホルダー値に置き換えます。 たとえば、Azure OpenAI エンドポイントがcontoso.openai.azure.comされている場合は、servers要素を次の値で更新します。-

url:

https://contoso.openai.azure.com/openai -

既定の エンドポイント:

contoso.openai.azure.com

[...] "servers": [ { "url": "https://contoso.openai.azure.com/openai", "variables": { "endpoint": { "default": "contoso.openai.azure.com" } } } ], [...]-

url:

仕様の API

versionの値を書き留めておきます。 API をテストするために必要です。 例:2024-10-21。

OpenAPI 仕様を API Management に追加する

- Azure portal で、API Management インスタンスに移動します。

- 左側のメニューで、[API]>[+ API の追加] を選択します。

- [新しい API の定義] で、[OpenAPI] を選択します。 API の [表示名] と [名前] を入力します。

- API Management インスタンス内の Azure OpenAI API エンドポイントにアクセスするために、 で終わる

/openaiを入力します。 たとえば、my-openai-api/openaiと指定します。 - [作成] を選択します

API Management は API をインポートし、OpenAPI 仕様からの操作を表示します。

Azure OpenAI API への認証を構成する

Azure OpenAI API に対して認証するには、API キーを指定するか、マネージド ID を使用します。 Microsoft Foundry から直接 Azure OpenAI API をインポートした場合、API Management インスタンスのマネージド ID を使用した認証が自動的に構成されます。

OpenAPI 仕様から Azure OpenAI API を追加した場合は、認証を構成する必要があります。 API Management ポリシーを使用した認証の構成の詳細については、「 LLM API の認証と承認」を参照してください。

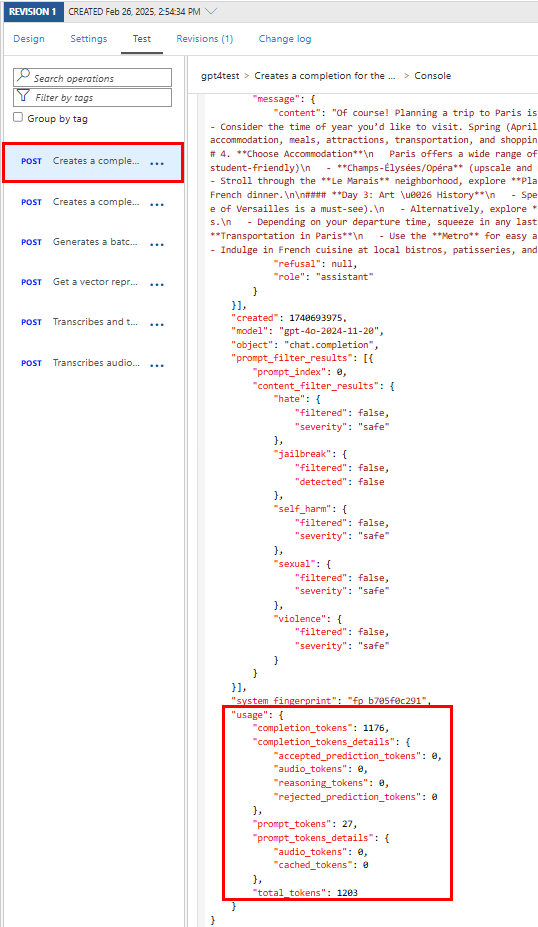

Azure OpenAI API をテストする

Azure OpenAI API が期待どおりに動作することを確認するには、API Management テスト コンソールでテストします。 Microsoft Foundry プロジェクト リソースで構成したモデル デプロイ ID (名前) と、API をテストするための API バージョンを指定する必要があります。

前の手順で作成した API を選びます。

[テスト] タブを選びます。

Azure OpenAI リソースにデプロイしたモデルと互換性のある操作を選択します。 ページにパラメーターとヘッダーのフィールドが表示されます。

[テンプレート パラメーター] に、次の値を入力します。

必要に応じて、他のパラメーターとヘッダーを入力します。 操作とモデルによっては、 要求本文の構成または更新が必要になる場合があります。 たとえば、チャット完了操作の基本的な要求本文を次に示します。

{ "model": "any", "messages": [ { "role": "user", "content": "Help me plan a vacation trip to Paris." } ], "max_tokens": 100 }注

テスト コンソールで、API Management によって Ocp-Apim-Subscription-Key ヘッダーが自動的に追加され、組み込みの オール アクセス サブスクリプションのサブスクリプション キーが設定されます。 このキーを使用すると、API Management インスタンス内のすべての API にアクセスできます。 必要に応じて 、Ocp-Apim-Subscription-Key ヘッダーを表示するには、 HTTP 要求の横にある "目" アイコンを選択します。

[Send] を選択します。

テストが成功すると、バックエンドは成功した HTTP 応答コードといくつかのデータで応答します。 応答には、Azure OpenAI API トークンの使用量を監視および管理するのに役立つトークン使用状況データが含まれます。

関連するコンテンツ

- API のインポートの制限事項

- OpenAPI 仕様のインポート

- SOAP API のインポート

- SOAP API をインポートして REST に変換する

- App Service API をインポートする

- コンテナー アプリ API をインポートする

- Websocket API のインポート

- GraphQL API のインポート

- GraphQL スキーマをインポートし、フィールド リゾルバーを設定する

- 関数アプリ API をインポートする

- ロジック アプリ API をインポートする

- Service Fabric サービスをインポートする

- Azure AI Foundry API をインポートする

- Azure OpenAI API をインポートする

- LLM API をインポートする

- OData API をインポートする

- REST API を MCP サーバーとしてエクスポートする

- 既存の MCP サーバーを公開する

- A2A エージェント API をインポートする

- SAP OData メタデータをインポートする

- gRPC API をインポートする

- API の編集