Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

DOTYCZY: Wszystkie warstwy usługi API Management

Punkty końcowe modeli AI wdrożonych w usłudze Azure OpenAI można zaimportować do instancji usługi API Management jako interfejs API typu REST. Użyj zasad bramy sztucznej inteligencji i innych funkcji w usłudze API Management, aby uprościć integrację, zwiększyć czytelność i zwiększyć kontrolę nad punktami końcowymi modelu.

W tym artykule przedstawiono dwie opcje importowania interfejsu API usługi Azure OpenAI do wystąpienia usługi Azure API Management jako interfejsu API REST:

Pobierz i edytuj specyfikację interfejsu OpenAPI dla usługi Azure OpenAI i dodaj ją do usługi API Management jako interfejs API OpenAPI.

Dowiedz się więcej o zarządzaniu interfejsami API LLM w usłudze API Management:

Funkcje bramy AI w usłudze Azure API Management

Uwaga

Zasady zarządzania API, takie jak azure-openai-token-limit i azure-openai-emit-token-metric, obsługują pewne punkty końcowe API dostępne przez określone modele Azure OpenAI. Aby uzyskać więcej informacji, zobacz Obsługiwane modele usługi Azure OpenAI.

Wymagania wstępne

Istniejąca instancja usługi API Management. Utwórz go, jeśli jeszcze tego nie zrobiono.

(W przypadku importowania z usługi Microsoft Foundry) Projekt Microsoft Foundry z wdrożonym modelem usługi Azure OpenAI. Aby uzyskać więcej informacji na temat wdrażania modelu w usłudze Azure OpenAI, zobacz przewodnik wdrażania zasobów.

Zanotuj identyfikator (nazwę) wdrożenia. Jest ona potrzebna podczas testowania zaimportowanych interfejsów API w usłudze API Management.

Uprawnienia do przyznania dostępu do zasobów Azure OpenAI z instancji zarządzania API.

Sposób 1. Importowanie interfejsu API OpenAI z witryny Microsoft Foundry

Wdrożenie modelu Usługi Azure OpenAI można zaimportować bezpośrednio z witryny Microsoft Foundry do usługi API Management. Aby uzyskać szczegółowe informacje, zobacz Importowanie interfejsu API usługi Microsoft Foundry.

Podczas importowania interfejsu API:

- Określ usługę Microsoft Foundry, która hostuje wdrożenie modelu Azure OpenAI.

- Określ opcję zgodności klienta usługi Azure OpenAI . Ta opcja umożliwia skonfigurowanie interfejsu API usługi API Management przy użyciu punktu końcowego

/openai.

Sposób 2. Dodawanie specyfikacji interfejsu OpenAPI do usługi API Management

Alternatywnie ręcznie pobierz specyfikację interfejsu OpenAPI dla interfejsu API REST usługi Azure OpenAI i dodaj ją do usługi API Management jako interfejs API OpenAPI.

Pobieranie specyfikacji interfejsu OpenAPI

Pobierz specyfikację interfejsu OpenAPI dla interfejsu API REST usługi Azure OpenAI, taką jak wersja ogólnie dostępna 2024-10-21.

W edytorze tekstów otwórz pobrany plik specyfikacji.

W elemencie

serversw specyfikacji zamień wartości zastępczeurlidefaultna nazwę punktu końcowego usługi Azure OpenAI. Przykładowo, jeśli punkt końcowy usługi Azure OpenAI tocontoso.openai.azure.com, zaktualizuj elementserversprzy użyciu następujących wartości:-

adres URL:

https://contoso.openai.azure.com/openai -

domyślny punkt końcowy:

contoso.openai.azure.com

[...] "servers": [ { "url": "https://contoso.openai.azure.com/openai", "variables": { "endpoint": { "default": "contoso.openai.azure.com" } } } ], [...]-

adres URL:

Zanotuj wartość interfejsu API

versionw specyfikacji. Potrzebujesz go do przetestowania interfejsu API. Przykład:2024-10-21.

Dodawanie specyfikacji interfejsu OpenAPI do usługi API Management

- W portalu Azure przejdź do wystąpienia usługi API Management.

- W menu po lewej stronie wybierz pozycję API>+ Dodaj API.

- W obszarze Definiowanie nowego interfejsu API wybierz pozycję OpenAPI. Wprowadź nazwę wyświetlaną i nazwę dla API.

- Wprowadź sufiks adresu URL interfejsu API kończący się na

/openai, aby uzyskać dostęp do punktów końcowych interfejsu Azure OpenAI w Twoim wystąpieniu usługi API Management. Na przykład:my-openai-api/openai. - Wybierz pozycję Utwórz.

Usługa API Management importuje interfejs API i wyświetla operacje ze specyfikacji interfejsu OpenAPI.

Konfigurowanie uwierzytelniania w interfejsie API usługi Azure OpenAI

Aby uwierzytelnić się w interfejsie API usługi Azure OpenAI, podaj klucz interfejsu API lub użyj tożsamości zarządzanej. Jeśli zaimportowano interfejs API usługi Azure OpenAI bezpośrednio z usługi Microsoft Foundry, uwierzytelnianie przy użyciu tożsamości zarządzanej instancji Azure API Management jest automatycznie konfigurowane.

Jeśli dodano interfejs API Azure OpenAI ze specyfikacji interfejsu OpenAPI, musisz skonfigurować uwierzytelnianie. Aby uzyskać więcej informacji na temat konfigurowania uwierzytelniania przy użyciu zasad usługi API Management, zobacz Uwierzytelnianie i autoryzacja do interfejsów API LLM.

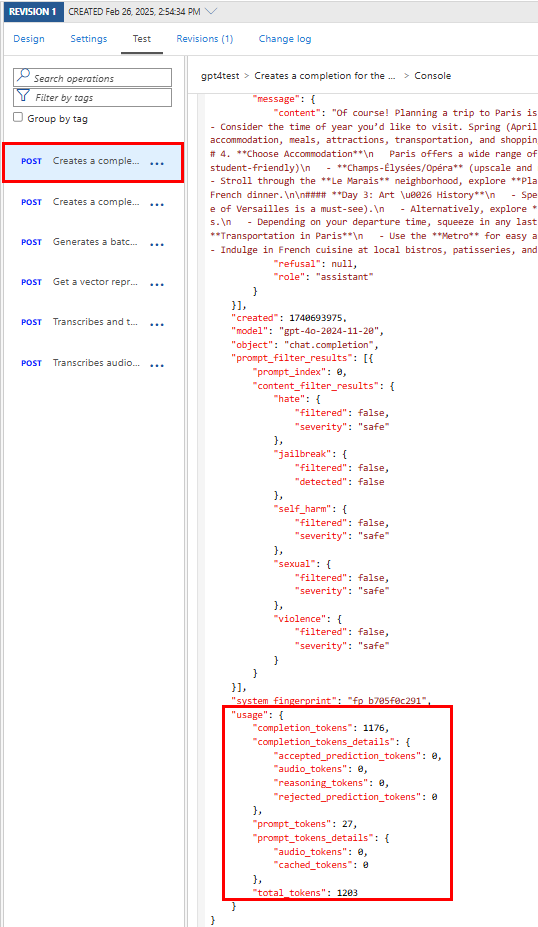

Testowanie interfejsu API usługi Azure OpenAI

Aby upewnić się, że interfejs API Usługi Azure OpenAI działa zgodnie z oczekiwaniami, przetestuj go w konsoli testowej usługi API Management. Musisz podać identyfikator wdrożenia modelu (nazwę) skonfigurowany w zasobie projektu Microsoft Foundry i wersję interfejsu API w celu przetestowania interfejsu API.

Wybierz interfejs API utworzony w poprzednim kroku.

Wybierz kartę Test.

Wybierz operację zgodną z modelem wdrożonym w zasobie Azure OpenAI. Na stronie są wyświetlane pola parametrów i nagłówków.

W obszarze Parametry szablonu wprowadź następujące wartości:

Wprowadź inne parametry i nagłówki zgodnie z potrzebami. W zależności od operacji i modelu może być konieczne skonfigurowanie lub zaktualizowanie treści żądania. Oto na przykład podstawowa treść żądania dla operacji uzupełniania czatu:

{ "model": "any", "messages": [ { "role": "user", "content": "Help me plan a vacation trip to Paris." } ], "max_tokens": 100 }Uwaga

W konsoli testowej usługa API Management automatycznie dodaje nagłówek Ocp-Apim-Subscription-Key i ustawia klucz subskrypcji dla wbudowanej subskrypcji z pełnym dostępem. Ten klucz zapewnia dostęp do każdego interfejsu API w instancji zarządzania API. Aby opcjonalnie wyświetlić nagłówek Ocp-Apim-Subscription-Key , wybierz ikonę "oko" obok żądania HTTP.

Wybierz Wyślij.

Po pomyślnym zakończeniu testu zaplecze odpowiada z pomyślnym kodem odpowiedzi HTTP i pewnymi danymi. Odpowiedź zawiera dane użycia tokenu, które ułatwiają monitorowanie użycia tokenów interfejsu API usługi Azure OpenAI i zarządzanie nim.

Powiązana zawartość

- Ograniczenia importu interfejsu API

- Importowanie specyfikacji interfejsu OpenAPI

- Importuj interfejs API SOAP

- Importowanie interfejsu API protokołu SOAP i przekształcenie go na interfejs API REST

- Importowanie API usługi aplikacji

- Importowanie interfejsu API aplikacji kontenera

- Importowanie API WebSocket

- Importuj API GraphQL

- Importowanie schematu GraphQL i konfigurowanie rozpoznawania pól

- Zaimportuj API aplikacji funkcji

- Importowanie interfejsu API aplikacji logicznej

- Importowanie usługi Service Fabric

- Importowanie interfejsu API usługi Azure AI Foundry

- Importowanie interfejsu API usługi Azure OpenAI

- Importowanie interfejsu API LLM

- Importowanie interfejsu API OData

- Eksportowanie interfejsu API REST jako serwera MCP

- Uwidacznia istniejący serwer MCP

- Importowanie interfejsu API agenta A2A

- Importowanie metadanych sap OData

- Importowanie interfejsu API gRPC

- Edytowanie interfejsu API