Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Observação

O Fabric Runtime 2.0 está atualmente em uma fase de versão prévia experimental. Para obter mais informações, consulte as limitações e as anotações.

O Fabric Runtime oferece integração perfeita no ecossistema do Microsoft Fabric, oferecendo um ambiente robusto para projetos de engenharia de dados e ciência de dados alimentados pelo Apache Spark.

Este artigo apresenta o Fabric Runtime 2.0 Experimental (versão prévia), o runtime mais recente projetado para cálculos de Big Data no Microsoft Fabric. Ele destaca os principais recursos e componentes que fazem desta versão um passo significativo para análise escalonável e cargas de trabalho avançadas.

O Fabric Runtime 2.0 incorpora os seguintes componentes e atualizações projetados para aprimorar seus recursos de processamento de dados:

- Apache Spark 4.0

- Sistema operacional: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Lake: 4.0

Habilitar o Runtime 2.0

Você pode habilitar o Runtime 2.0 no nível do workspace ou no nível do item de ambiente. Use a configuração do workspace para aplicar o Runtime 2.0 como o padrão para todas as cargas de trabalho do Spark em seu workspace. Como alternativa, crie um item de Ambiente com o Runtime 2.0 para usar com notebooks específicos ou definições de trabalho do Spark, o que substitui o padrão do workspace.

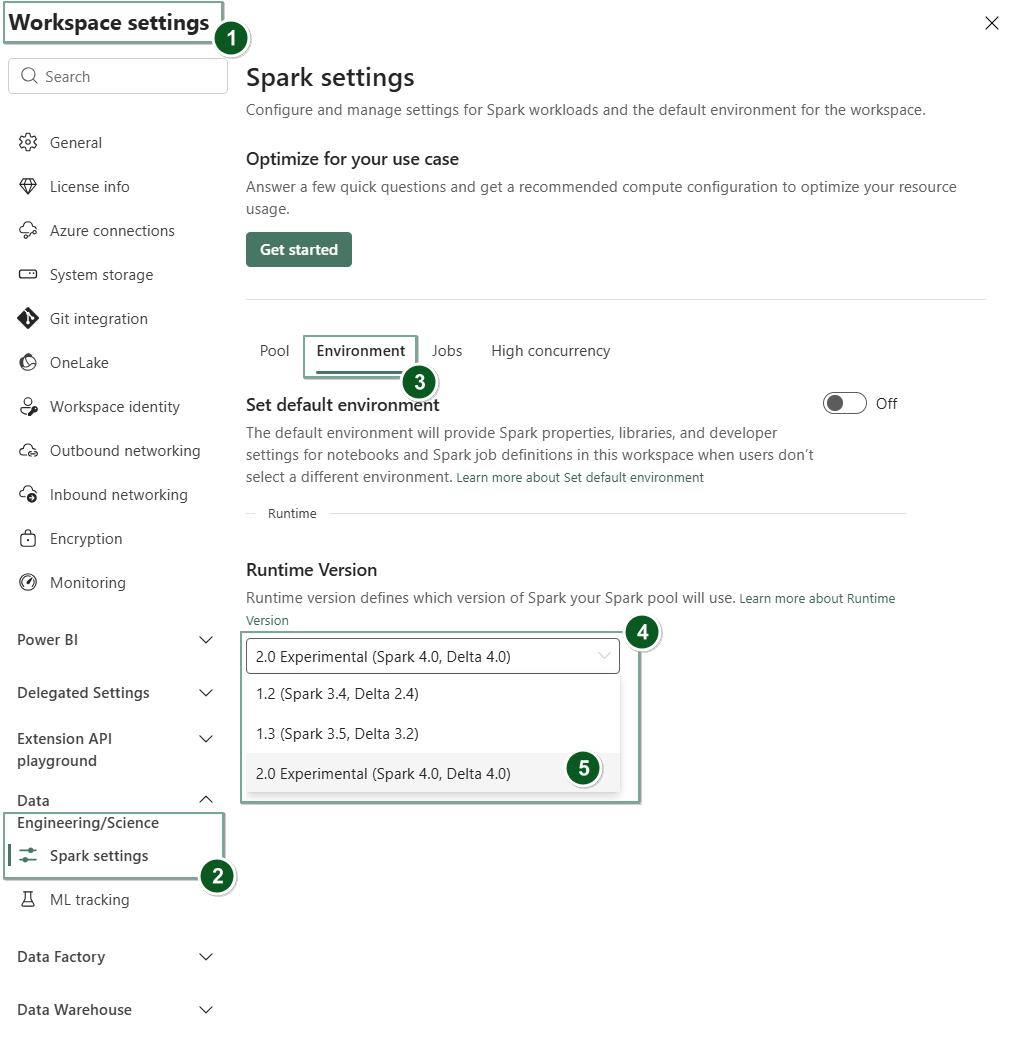

Habilitar o Runtime 2.0 nas configurações do Workspace

Para definir o Runtime 2.0 como o padrão para todo o workspace:

Navegue até a guia Configurações do espaço de trabalho dentro do espaço de trabalho do Fabric.

Vá para a guia Engenharia de Dados/Ciência e selecione as configurações do Spark.

Selecione a guia Ambiente.

No dropdown de versão do Runtime, selecione 2.0 Experimental (Spark 4.0, Delta 4.0) e salve suas alterações. Essa ação define o Runtime 2.0 como o runtime padrão para seu workspace.

Habilitar o Runtime 2.0 em um item de Ambiente

Para usar o Runtime 2.0 com notebooks específicos ou definições de trabalho do Spark:

Crie um novo item de Ambiente ou aberto e existente.

Na lista suspensa Runtime, selecione 2.0 Experimental (Spark 4.0, Delta 4.0)

SaveePublishsuas alterações.Importante

Pode levar cerca de 2 a 5 minutos para que as sessões do Spark 2.0 comecem, já que os pools iniciais não fazem parte da versão experimental inicial.

Em seguida, você pode usar este item de Ambiente com o seu

NotebookouSpark Job Definition.

Agora você pode começar a experimentar as melhorias e funcionalidades mais recentes introduzidas no Fabric Runtime 2.0 (Spark 4.0 e Delta Lake 4.0).

Visualização pública experimental

O estágio de versão prévia experimental do Runtime do Fabric 2.0 oferece acesso antecipado a novos recursos e APIs do Spark 4.0 e do Delta Lake 4.0. A visualização permite que você use os aprimoramentos mais recentes baseados no Spark imediatamente, garantindo uma boa preparação e transição para alterações futuras, como as versões mais recentes de Java, Scala e Python.

Dica

Para obter informações atualizadas, uma lista detalhada de alterações e as notas de versão específicas dos runtimes do Fabric, verifique e assine Versões e Atualizações de Runtimes do Spark.

Limitações e anotações

O Fabric Runtime 2.0 está atualmente em um estágio experimental de visualização pública, projetado para os usuários explorarem e experimentarem os recursos e APIs mais recentes do Spark e do Delta Lake nos ambientes de desenvolvimento ou teste. Embora esta versão ofereça acesso às principais funcionalidades, há certas limitações:

Você pode usar sessões do Spark 4.0, escrever código em notebooks, agendar definições de trabalho do Spark e usar com PySpark, Scala e Spark SQL. No entanto, não há suporte para a linguagem R nesta versão inicial.

Você pode instalar bibliotecas diretamente em seu código com pip e conda. Você pode definir as configurações do Spark por meio das opções de %%configure em notebooks e SJDs (Definições de Trabalho do Spark).

Você pode ler e gravar no Lakehouse com o Delta Lake 4.0, mas alguns recursos avançados, como V-order, escrita parquet nativa, autocompactação, otimização de gravação, mesclagem de baixo embaralhamento, evolução do esquema e viagem no tempo, não estão incluídos nesta versão inicial.

O Orientador do Spark está indisponível no momento. No entanto, ferramentas de monitoramento, como interface do usuário e logs do Spark, têm suporte nesta versão inicial.

Atualmente, não há suporte para recursos como integrações de Ciência de Dados, incluindo o Copilot, e conectores, como Kusto, SQL Analytics, Cosmos DB e MySQL Java Connector. Não há suporte para bibliotecas de Ciência de Dados em ambientes PySpark. O PySpark funciona apenas com uma configuração básica do Conda, que inclui o PySpark sozinho sem bibliotecas extras.

Não há suporte para integrações com o item de ambiente e o Visual Studio Code nesta versão inicial.

Ele não dá suporte à leitura e gravação de dados em contas de Armazenamento do Azure de Uso Geral v2 (GPv2) com protocolos WASB ou ABFS.

Observação

Compartilhe seus comentários sobre o Fabric Runtime na plataforma Ideias. Lembre-se de mencionar a versão e a fase de lançamento à qual você está se referindo. Valorizamos os comentários da comunidade e priorizamos melhorias com base em votos, certificando-se de que atendemos às necessidades do usuário.

Principais destaques

Apache Spark 4.0

O Apache Spark 4.0 marca um marco significativo como o lançamento inaugural na série 4.x, incorporando o esforço coletivo da vibrante comunidade de software livre.

Nesta versão, o SPARK SQL é significativamente enriquecido com novos recursos avançados projetados para aumentar a expressividade e a versatilidade para cargas de trabalho SQL, como suporte a tipo de dados VARIANT, funções definidas pelo usuário do SQL, variáveis de sessão, sintaxe de pipe e ordenação de cadeia de caracteres. PySpark demonstra dedicação contínua à sua área de funcionalidade e à experiência geral do desenvolvedor, trazendo uma API de plotagem nativa, uma nova API de Fonte de Dados em Python, suporte para UDTFs do Python e criação de perfil unificada para UDFs do PySpark, juntamente com vários outros aprimoramentos. O Streaming Estruturado evolui com as principais adições que fornecem maior controle e facilidade de depuração, notadamente a introdução da API de Estado Arbitrário v2 para um gerenciamento de estado mais flexível e a Fonte de Dados de Estado para facilitar a depuração.

Você pode conferir a lista completa e as mudanças detalhadas aqui: https://spark.apache.org/releases/spark-release-4-0-0.html.

Observação

No Spark 4.0, o SparkR foi preterido e pode ser removido em uma versão futura.

Delta Lake 4.0

Delta Lake 4.0 marca um compromisso coletivo de tornar o Delta Lake interoperável entre formatos, mais fácil de trabalhar e com mais desempenho. O Delta 4.0 é um lançamento marco repleto de novos recursos avançados, otimizações de desempenho e aprimoramentos fundamentais para o futuro dos lakehouses de dados abertos.

Você pode verificar a lista completa e as alterações detalhadas introduzidas com o Delta Lake 3.3 e 4.0 aqui: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Importante

Os recursos específicos do Delta Lake 4.0 são experimentais e funcionam apenas em experiências do Spark, como Notebooks e Definições de Trabalho do Spark. Se você precisar usar as mesmas tabelas delta lake em várias cargas de trabalho do Microsoft Fabric, não habilite esses recursos. Para saber mais sobre quais versões de protocolo e recursos são compatíveis em todas as experiências do Microsoft Fabric, leia Interoperabilidade do Formato de Tabela Delta Lake.

Conteúdo relacionado

- Ambientes de execução do Apache Spark no Fabric – Visão geral, gerenciamento de versões e suporte a múltiplos ambientes de execução

- Guia de migração do Spark Core

- Guias de migração de SQL, Datasets e DataFrame

- Guia de migração de Streaming Estruturado

- Guia de migração de MLlib (aprendizado de máquina)

- Guia de migração do PySpark (Python no Spark)

- Guia de migração do SparkR (R no Spark)